様々な「感覚」を提示するデバイス

様々な触覚を再現する棒状デバイス

東京大学 稲見・檜山研究室が展示していた「LevioPole」は、棒の両端に取り付けられたプロペラが生み出す風によって、多種多様な触覚を再現できるデバイスです。

展示会場では、実写全天球映像の中で地上から空高くへジャンプする体験、ボートに乗ってカヌーのようにオールで水を掻いて進む体験、逐次重さの変わるバーベルを持ち上げる体験の3種類が体験できました。実際に「水の中にオールが突っ込むと前に押し出しにくい」、「バーベルがずっしりと重い」など、プロペラによって実物さながらの非常に力強い「抵抗」を感じました。

展示名:LevioPole: Mid-Air Haptic Interactions Using Multirotor

出展者:Tomoya Sasaki、Richard Sahala Hartanto、Kao-Hua Liu、Keitarou Tsuchiya, Atsushi Hiyama, Masahiko Inami(東京大学 稲見・檜山研究室)

(その他:Mogura VRによるニュースリリース)

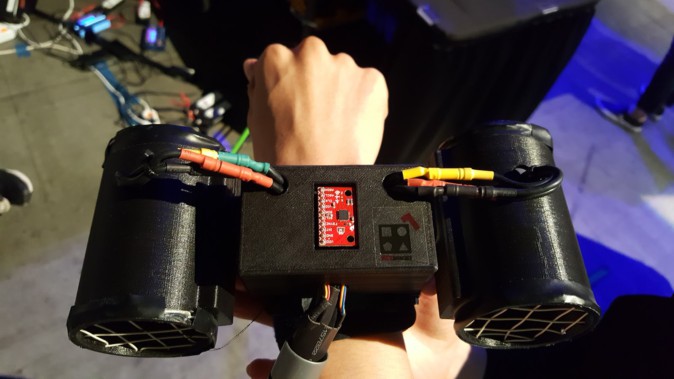

また、同様にプロペラを使った仕組みとしては、韓国の国立大学KAISTの研究室が展示していた「Wind-Blaster」があります。こちらは、バーチャル空間で生じた銃や剣の衝撃を腕に装着したプロペラ式のデバイスで再現するというものでした。

https://www.youtube.com/watch?v=31yilJGUkuM

展示名:Wind-Blaster: A Wearable Propeller-Based Prototype That Provides Ungrounded Force-Feedback

展示者:Seungwoo Je, Hyelip Lee, Myung Jin Kim, Andrea Bianchi(KAIST)

指先に触覚を提示するCube

同じくKAISTが展示していた「HapCube」は、指先につけることで、任意の方向の摩擦力を生み出し、様々な種類の「ボタンを押した感覚」を提示することができます。AR/VRのUI操作時のフィードバックなどへの応用が考えられるとのことです。

展示名:HapCube: A Tactile Actuator Providing Tangential and Normal Pseudo-Force Feedback on a Fingertip

展示者:Hwan Kim, HyeonBeom Yi, Richard Chulwoo Park, Woohun Lee(KAIST)

体感できる形状を変えるデバイス

東京大学 廣瀬・谷川・鳴海研究室が展示していた「Transcalibur」は、重りの位置を変えることで、物の形の感じ方を変えることができるデバイスです。

モーターで開閉する二本の棒と、それぞれに取り付けられた移動式の重り。2次元平面的に位置を変えるこの2つの重りがデバイスの慣性モーメントを変化させると、それによってデバイスの形状の感じ方も変化させることができます。

会場ではHTC Viveを装着し、剣や扇(盾)に手持ちの武器を変形させながら、対峙するモンスターを倒すコンテンツを体験しました。

プロジェクトのページはこちら。

展示名:Transcalibur: Weight Moving VR Controller for Dynamic Rendering of 2D Shape Using Haptic Shape Illusion

出展者:Jotaro Shigeyama, Takeru Hashimoto, Shigeo Yoshida, Taiju Aoki, Takuji Narumi, Tomohiro Tanikawa, Michitaka Hirose(東京大学 廣瀬・谷川・鳴海研究室)

電気を流して味覚をコントロール

同じく東京大学 廣瀬・谷川・鳴海研究室が展示していた「Taste Controller」は、電気味覚を利用して塩味を増減させる技術デモです。顎と首筋に電極を貼り、「ソルティライチ」を口に含んだところから体験が始まります。コントローラーで電流の強さや周波数を変えることで、ソルティライチの塩味の強さが変化します。

本展示では、1~20Hzの電流を使うことで電気刺激のオンオフを繰り返し、刺激を連続的に与えることで従来より味の変化持続時間を延ばす手法を提案しています。なお、人により効き方には違いがあるとのことでした。

展示名:Taste Controller: Galvanic Chin Stimulation Enhances, Inhibits, and Creates Tastes

展示者:Kazuma Aoyama(東京大学 廣瀬・谷川・鳴海研究室 特任助教)

腕が伸びる!あの世界的な海賊の能力を体験……!?

東京工業大学 長谷川研究室が展示していた「Gum-Gum Shooting」は、IVRC2017で登場した、自分の腕が伸縮する感覚を再現するデバイスです。腕を前に突き出すと、装着したデバイスが腕の皮膚を引っ張る、重心が移動するなどによって腕が伸縮する感覚を提示します。腕が縮んで元の長さに戻るときの「パチン」という感覚もリアリティがありました。

プロジェクトページはこちら。

展示名:Gum-Gum Shooting

展示者:Hsueh-Han Wu(東京工業大学 長谷川研究室)

VR/ARによる作業支援

遠隔地から二人羽織

慶應義塾大学大学院メディアデザイン研究科と東京大学 稲見・檜山研究室が展示していた「Fusion」は、二人羽織のようなウェアラブルロボットシステムを使って、遠隔地の人物との共同作業を支援するシステムです。

Oculus Riftを被った体験者は、もう一方の人が背負ったロボットの視点に入り込みます。音声通信に加え、Oculus Touchコントローラーでロボットの手を動かすことができるため、ロボットを背負った人と手を使った共同作業が可能になります。

(座っている体験者は、ロボットアームを使って遠くにある小さなボールをコップに入れている。)

他にも自分でロボットの手を動かして自分を触るといった体験もできました。

展示名:Fusion: Full Body Surrogacy for Collaborative Communication

展示者:MHD Yamen Saraiji, Tomoya Sasaki, Reo Matsumura, Kouta Minamizawa, Masahiko Inami(慶應義塾大学大学院メディアデザイン研究科、東京大学 稲見・檜山研究室)

(その他:Mogura VRによる記事)

タブレットでバーチャルな映画セットを確認

Filmakademie Baden-Württemberg GmbHらが展示していた「VPET」は、タブレット端末などを用いて現実空間と撮影したい映画の中のバーチャル空間を融合させ、、確認や編集作業ができるシステムです。オープンソースで開発が進められています(GIthub)。

展示名:VPET – Virtual Production Editing Tools

展示者:Simon Spielmann, Volker Helzle, Andreas Schuster, Jonas Trottnow, Kai Goetz, Patricia Rohr(Filmakademie Baden-Württemberg GmbH, Animationsinstitut)

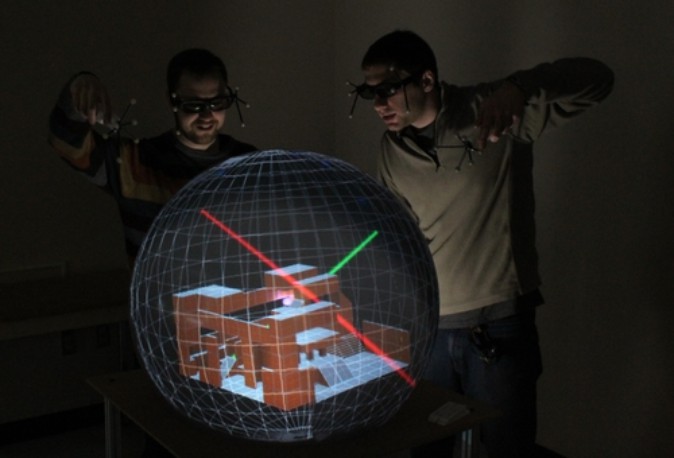

複数人で同時に体験できる球体3Dディスプレイ

3Dメガネなどを用いて見る、体験者の頭の位置に応じて変化するステレオの立体映像のことをFish Tank Virtual Realityと呼ぶことがあります。従来体験者が1人に限定されてしまうこのFish Tank VRを、2人で楽しむことができるようにしたもの。

アクティブシャッター方式の3Dメガネ(メガネのレンズが、左右の目に入る映像を高速で交互にオン・オフする)を用いて、それぞれの体験者には相手の(位置に対して表示されている)映像が見えないようになっており、一つの球体ディスプレイをシェアすることができます。

会場内では、対面で行う1対1の卓球ゲームなどが体験できました。

展示名:CoGlobe: A Co-Located Multi Person FTVR Experience

展示者:Sidney Fels, Ian Stavness, Qian Zhou, Dylan Fafard(University of British Columbia、University of Saskatchewan)

ロボットの応用、表現、テレプレゼンスも

ロボットの感情表現

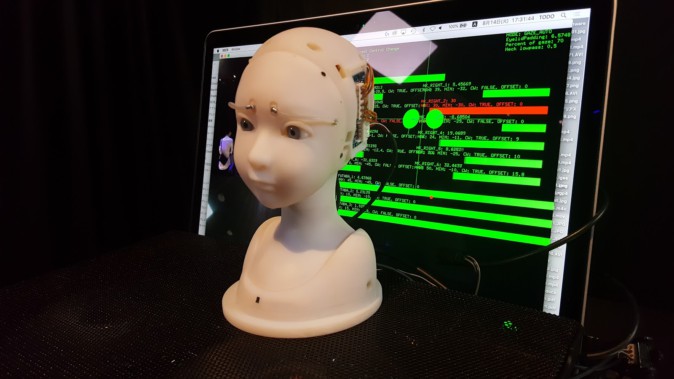

展示名:SEER: Simulative Emotional Expression Robo

展示者:Takayuki Todo(個人)

日本のアーティスト藤堂高行氏が展示していた「SEER」は表情・感情表現を行うロボットの展示です。無機質で硬い質感の素材でできており、表情筋や口の制御などはありません。最小限な構成ながらも、まぶた、眉、眼球の制御によって本当に生きているかのような表情を表現できている作品となっています。

(横顔も可愛らしいSEER)

会場では、表情検出用のカメラを使って体験者の表情を取得し、ロボットがその顔を真似するデモを体験できました。

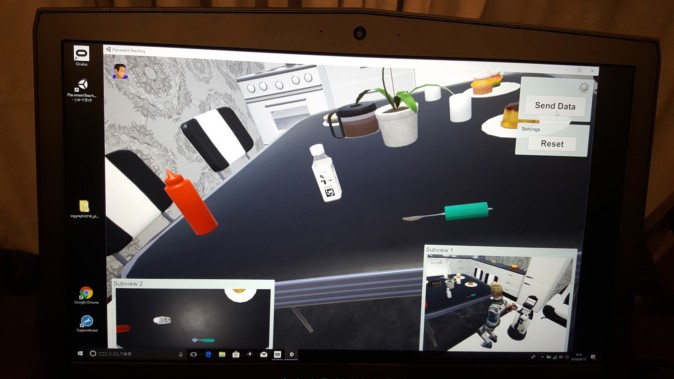

人助けロボット、バーチャル空間からの操作も

トヨタ自動車株式会社らが展示していた「Human Support Robot」はその名の通り、人助け用のロボットの展示です。会場で行われていたデモは、Oculus Riftを被ってバーチャル空間で机の上に道具を並べると、ロボットが現実空間でそれと同じように机にものを配置してくれるというものでした。

(左からケチャップボトル・ペットボトル・スプーンと並べてデータを送ると、ロボットが道具を一つ一つ手で掴み、現実空間で同様の配置を再現。)

展示名:Human Support Robot (HSR)

展示者:Takashi Yamamoto, Hideki Kajima, Mitsunori Ohta, Koichi Ikeda, Tamaki Nishino, Andrew Custer, Yutaka Takaoka(トヨタ自動車株式会社、トヨタ・リサーチ・インスティテュート)

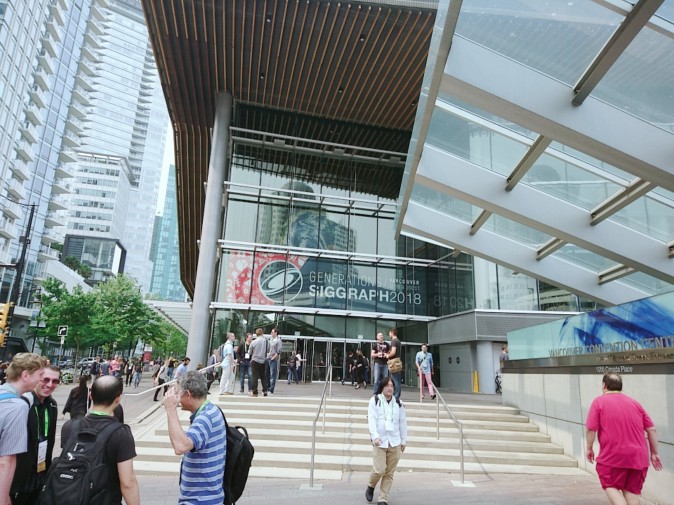

AR/VR技術が目白押しのE-Tech

CG系の展示がメインのSIGGRAPHですが、E-Techの展示のほとんどはAR/VRに関係したものでした。また、毎年E-Techでは日本勢の活躍が多く見られます。

SIGGRAPH2018ではE-Techとは別に、VR系の展示はImmersive Pavilionというコーナーに全てまとめられて大々的に取り上げられるなど、AR/VR系の展示の勢いは年々大きくなっているように感じられます。

次世代の技術として取り上げられるE-Techの中から、AR/VRに大きなインパクトをもたらす技術が萌芽するかもしれません。引き続き注目したい技術が目白押しのSIGGRAPH2018 Emerging Technologyでした。