2018年8月22日から24日にかけて開催された、ゲームを中心とするコンピュータエンターテインメントの開発者カンファレンス・CECEC2018。本カンファレンスではいくつかのバーチャルYouTuber(バーチャルユーチューバー・VTuber)関連セッションや、キャラクターを現実空間のイベントに呼び出して出演させる、という取り組みに関するセッションも複数開催されています。

今回は、技術だけでなく想いを込めてキャラクターを現実に存在させ続けてきた、ドワンゴとバンダイナムコスタジオのセッションを前後編に分けてレポートします。

前編(本記事)では、バーチャルキャラクターをリアルに召喚するための技術と現場経験からくる課題を網羅的に解説した、ドワンゴ/バーチャルキャスト岩城氏のセッション。後編ではキャラクターが活き活きと動く様を、モーションアクターの実演も交えライブで見ることができたバンダイナムコスタジオ大曽根氏・森本氏のセッションを取り上げます。

ドワンゴの「1万人規模音楽ライブからトークイベントまで、バーチャルキャラクターをリアルイベントへ召喚する技術」

本セッションは8月24日に行われました。登壇したのは、ドワンゴの各種イベントでバーチャルキャラクターを召喚してきた、MIRO氏こと岩城 進之介氏。7月27日には株式会社バーチャルキャストが設立され、岩城氏は同社のCTOを務めています。

まず最初に、岩城氏は本セッションで伝えたいことは、

・キャラクターをイベントや生放送に召喚するために必要な技術要素、技術選択基準

・大型イベントならではのよくある課題(落とし穴)と、その課題への向きあいかた

・キャラクターをイベントに召喚するときに気を付けてほしいこと

・これらを俯瞰して考えるための情報

であると説明がありました(※なお、当日の発表スライドは岩城氏より公開されています。こちらのリンクから閲覧が可能)。

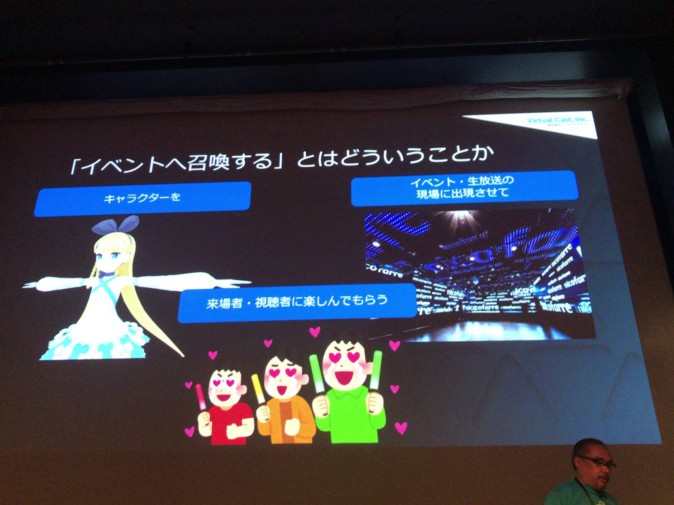

「バーチャルキャラクターをリアルイベントに召喚するということ」

まずはじめに、「バーチャルキャラクターをリアルイベントに召喚する」ということを分解して考えてみると、

1. キャラクターを、

2. イベント・生放送の現場に出現させて、

3. 来場者・視聴者に楽しんでもらう。

ということになります。ここで留意すべきことは「来場者・視聴者に楽しんでもらう」がゴールであるという点。「技術をばかり追っていると、見失ってしまうことがある」との前置きがありました。

ここから「イベントに召喚する」ための要素を考えていくにあたり、次の4つに分解して追っていきます。

1. キャラクターの動きをどうつけるか(モーションキャプチャ)

2. キャラクターをどう出現させるか(ディスプレイ)

3. キャラクターアクターにどう演じてもらうか

4. イベント全体をどう成立させるか(全体設計・運用)

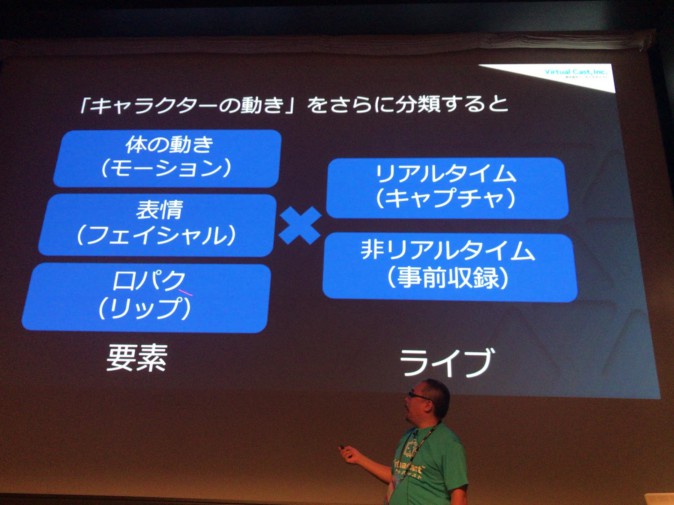

1.キャラクターの動き

キャラクターの動きは、要素として

1-1. 体の動き(モーション)

1-2. 表情の動き(フェイシャル)

1-3. 口パクなど、口の動き(リップ)

があり、これに対して

1-A.ライブ中にリアルタイムで動かすか、非リアルタイムで動かすか(リアルタイムキャプチャしたものを表示するか、事前収録したものを表示するか)

という風に分解して考えることができます。

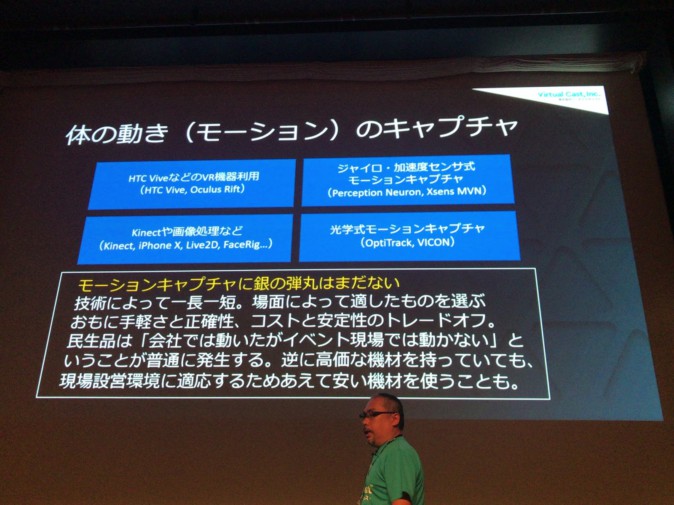

1-1. 体の動き(モーション)のキャプチャ

体の動きのキャプチャーは、

・VR機器でのキャプチャ

・ジャイロ・加速度センサ式モーションキャプチャ

・Kinectや画像処理など

・光学式モーションキャプチャ

といった選択肢が挙げられます。それぞれ手軽さや精度、コストと安定性など一長一短であり、「これなら間違いない」、いわゆる「銀の弾丸」となる手法はないそうです。例えば民生品は「会社では動いたがイベント現場の環境では動かない」というケースもあり、逆に高価な光学式モーションキャプチャがあったとしても、それを現場で設営する空間/時間が無ければ異なる機材を用いることになります。適材適所、ということですね。

1-2.表情(フェイシャル)の実現

次に表情(フェイシャル)。こちらは、

・画像処理によるキャプチャ(iPhone X,FaceRigなど)

・声や動きによる自動適応

・コントローラーによる外部オペレーターによる操作

・コントローラーによる出演者自身による操作

が挙げられました。ワンオペレーション向けにコントローラーで出演者自身が操作できるようにする場合、出演者が慣れていればベストだが、慣れていない場合は操作しきれないケースがよくあるそう。現在はコントローラーを使って外部オペレーターが変更できるようにするのが一般的とのことです。

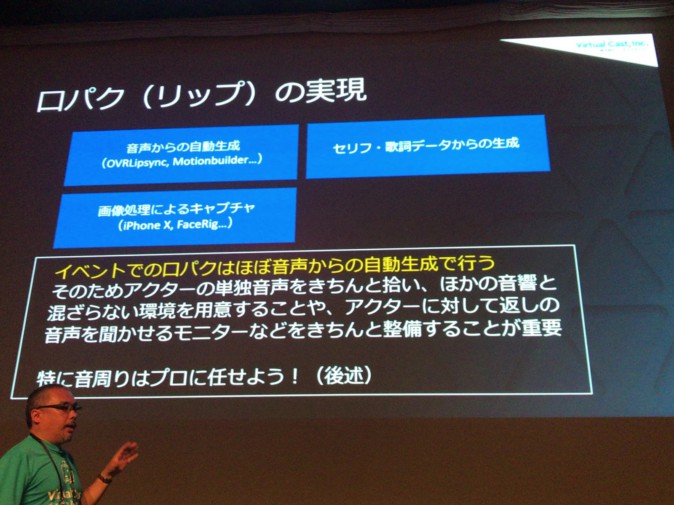

1-3. 口パク(リップ)の実現

口パク(リップ)の制御については、音声からの自動生成ほぼ一択とのこと。よく使われているのはOculus社が提供している「OVRLipSync」というライブラリだそうです(岩城氏のチームでは独自実装のものを使用することもある、とのこと)。

アニメのキャラクターであれば、出している声を元に口の動きを作るのがしっくりきます。ただし、イベント特有の事情として、イベントでの他の音声と混ざらないような環境を用意したり、アクターに対して返しの音声を聞かせるモニターを用意するなど、繊細な環境を構築する必要があるため、これらについては必ず音響周りのプロに任せましょう、と強調していました。

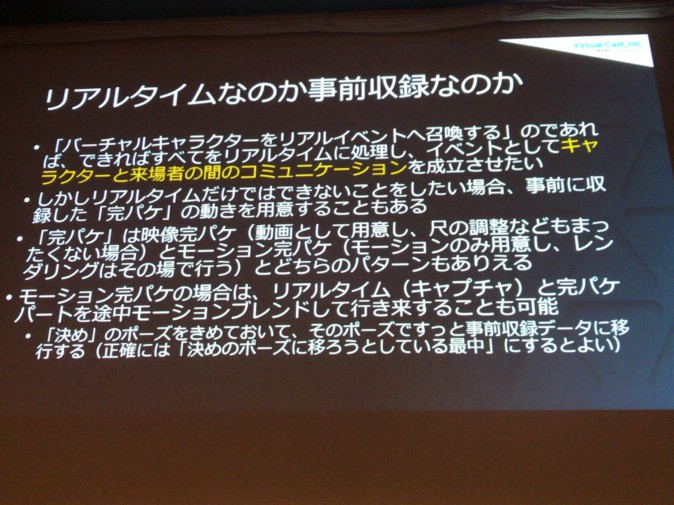

1-A.ライブ中にリアルタイムで動かすか、非リアルタイムで動かすか

キャラクターをリアルタイムで動かすのか、それとも事前収録しておくかという観点については、キャラクターと来場者とのコミュニケーションを成立させるためにリアルタイムで制御させるのがベターではある、と岩城氏は話しました。

ただし、キャラクターにダンスを踊らせるなど、リアルタイムではどうしても辛いというケースについては、あらかじめモーションを収録しておくという手段もありえます。リアルタイムで動かしている所から事前収録モーションにすり替える際は、リアルタイム側で「決め」のポーズを決めておき、その決めのポーズに移ろうとしている最中に切り替えるとうまくいくそうです。

2.キャラクターをどう出現させるか(ディスプレイ)

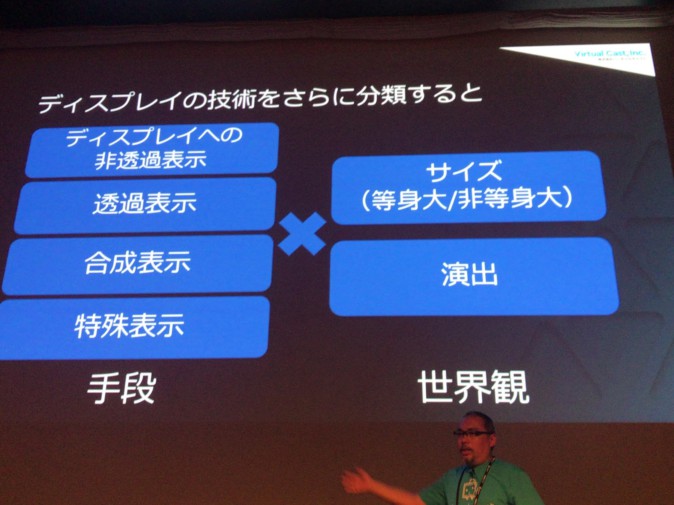

ディスプレイの技術について要素を分解すると、手段としては、

2-1. プロジェクターなどのディスプレイへの非透過表示

2-2. 透過表示

2-3. 合成表示

2-4. 特殊表示

があり、その上で

2-A. 召喚の世界観をどうつくるか(キャラクターのサイズや演出)

2-1. プロジェクターなどのディスプレイへの非透過表示

通常のディスプレイへ出力する場合は背景が透けたりはしていないため、デバイス自体による実在感への強化はできません。そのため、いかに実在感を演出するかが鍵になります。

例えば、

・中継画面を模す

・現地の画像やそこにありそうなものを背景に使用する

・ノイズをいれてカメラで撮影している感を出す

2-2.透過表示

透過表示させる際に利用するデバイスも多種多様です。透過スクリーンにプロジェクターで映し出す場合、壁に透けて表示されるのを防ぐため、スクリーンの後ろから投射する必要があります。しかし、キャラクターを等身大で表示するためには投射距離(スクリーンとプロジェクターの距離)がある程度必要になります。また、照明などによっては周りの明るさに負けてしまうこともあるそうです。

ハーフミラーを配置して上もしくは下から映像を投射する形式では、ミラーの奥に人がいるように見えるため、ミラーの前に人を立たせることができず、ステージの動線を意識する必要があります。

透明有機ELは現在生産されておらず市場流通分しかないため、入手したいならば今のうちに購入するしかないとのこと(なお、1台あたりおよそ150万円!)。

2-3. 合成表示

配信や生放送にて、中継用のカメラに対してARを用いてキャラクターを合成して視聴者に見せるというケースが「合成表示」にあたります。ドワンゴが関わるイベントでもよく見られるように、岩城氏のチームで強みであるとのことです。ゲーム実況などの画面の下に表示させるというケースもここに含まれます。

(キャラクターをAR合成で表示した例:電脳少女シロ生誕祭)

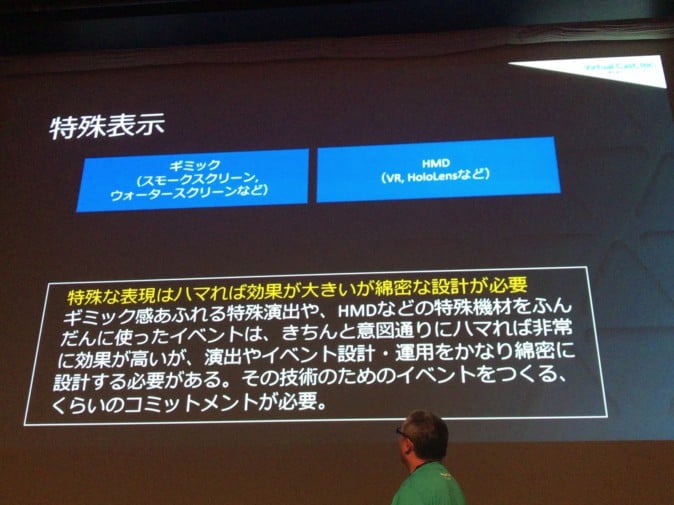

2-4. 特殊表示

その他、スモークスクリーンやウォータースクリーンなどの特殊なギミックを用いるケースや、来場者にHMDを被せてその中でキャラクターを表示する、なども考えられます。

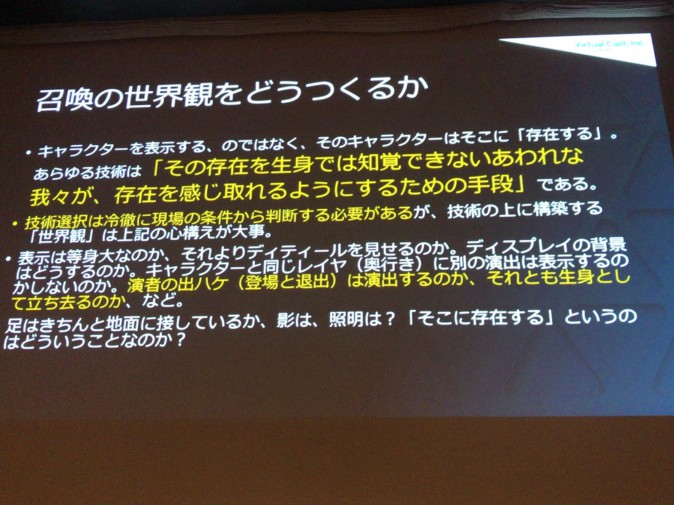

2-A) 召喚の世界観をどうつくるか

キャラクターを召喚させる上ではディスプレイの技術だけでなく、どうしてそこに表示させるのかを必ず考えてほしいと岩城氏は語ります。そして、キャラクターは表示させるものではなく、そこに「存在する」し、その上で技術は「その存在を生身では知覚できない哀れな我々が、存在を感じ取れるようにするため」の手段であるという心構えが必要であると続けます。

例えば「モニターを置いてキャラクターの上半身を表示させればいいでしょ」というわけではなく、「キャラクターがここにいるんだ」というのを前提とした上で、この部分だけモニターで出すんだ、という考え方をしてほしいと強調します。

また、演者の出ハケの仕方についても、キャラクターの世界観にあった演出を考えてほしいということです。パーティクルととも登場/退出するのはそういう世界観を持ったキャラクターだから許されるのであり、「現実世界にいるんだ」という世界観のキャラクターは舞台袖から(へ)歩かせるか、せいぜい舞台を暗転してから登場(退出)させるべきと述べました。

3.イベントにおいてキャラクターアクターにどう演じてもらうか

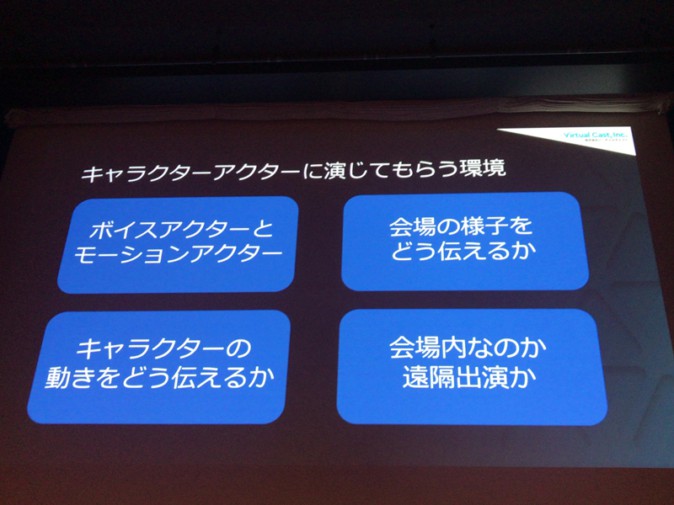

アクト環境の構築についても、

3-1. ボイスアクターとモーションアクターが同じ人なのか別の人なのか

3-2. 会場の様子をどうアクターに伝えるか

3-3. キャラクターの動きをどうアクターに伝えるか

3-4. アクターがいるのは会場内なのか外から遠隔出演なのか

といった要素に分解し、考えていきます。

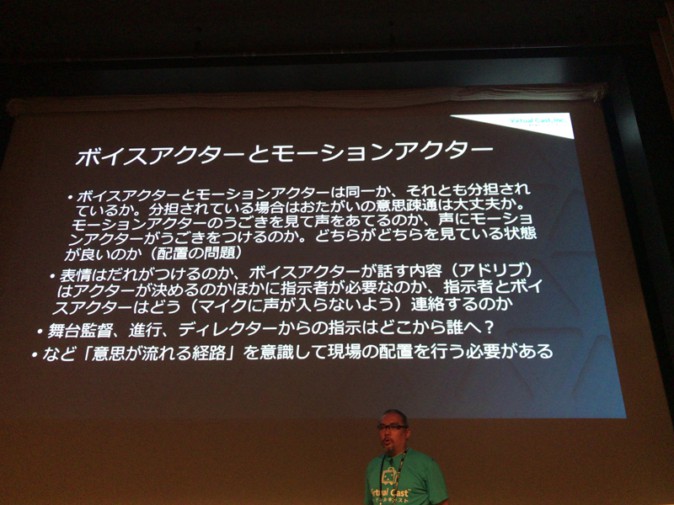

3-1. ボイスアクターとモーションアクター

VTuberの場合、「同一人物が担当するが、キャラクターの声を声優が担当している場合は動きの演技を一緒につけてはもらえないケース」もあり、ボイスアクターとモーションアクターが別の人物が担当するパターンも結構あるとのこと。

その場合、ボイスアクターとモーションアクターの意思疎通をどのように図るか(どちらがきっかけで動くのか)、機材の配置の段階から考える必要があります。また、キャラクターの表情もボイスアクターとモーションアクターがつけるのかということも検討するポイントです。

さらに、舞台監督や進行担当、ディレクターなど、イベント全体の進行をだれが決めてどうやって伝えるのか、意思の流れる経路も重要になります。

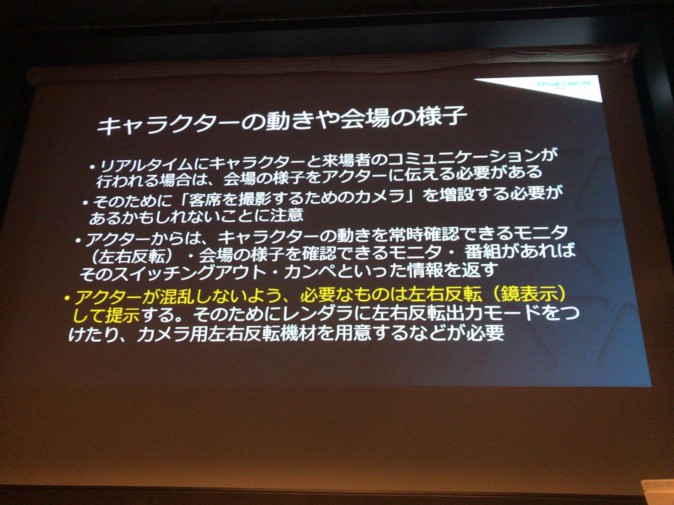

3-2 + 3-3. 会場の様子やキャラクターの動きをどうアクターに伝えるか

アクターに対して舞台上のキャラクターがどのように観客を見ているかを伝えるために会場内に配置したカメラや、キャラクターが舞台上でどのように動いているかをアクターに伝えるためのモニターにも工夫が必要です。

例えば、会場都合で客席後部からステージ方向へ配置した時の会場カメラや、キャラクターをレンダリングするモニターは、アクターが混乱しないよう左右反転させて表示させる必要があります。

3-4. アクターがいるのは会場内なのか外から遠隔出演なのか

会場のスペース的や、時間的にモーションキャプチャエリアを設営できないケースなど、アクターが遠隔地から出演することも考えられます。ただ、アクターが会場の雰囲気を肌で感じたり、生バンドにあわせて歌うなど高度な同期が必要な場合は遠隔出演は向きません。また、舞台進行にかかわるスタッフを遠隔収録する現場にもきちんと手配する必要があります。

4.イベント全体の設計・運用

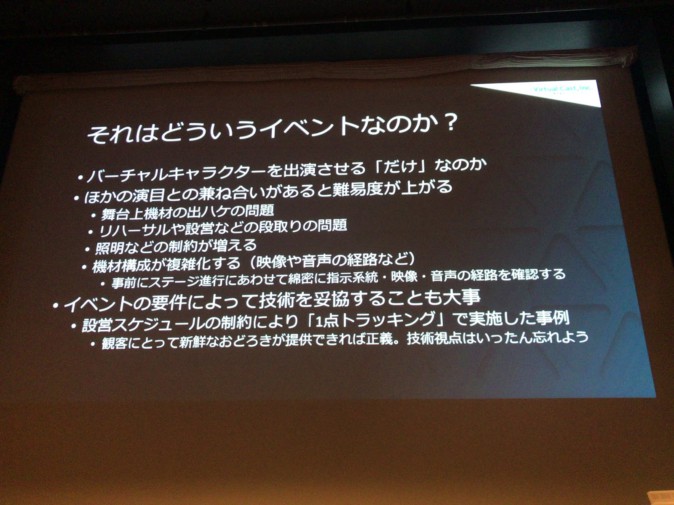

それがどういったイベントであるか

バーチャルキャラクターが出演するだけでなく、他の演目がある中で出演するとなると、機材や段取り、照明など他の演目との兼ね合いを考えなければならず、一気に難易度が上がるそうです。

さらに、イベントの要件によっては技術を妥協することが大事とも語りました。設営スケジュールの都合で、動きは頭がどちらを向いているかだけの「一点トラッキング」、手の動きなどは事前収録で行ったケースもあったそうですがが、観客にはきちんと、失神しかねないほどの驚きを与えられたそうです。

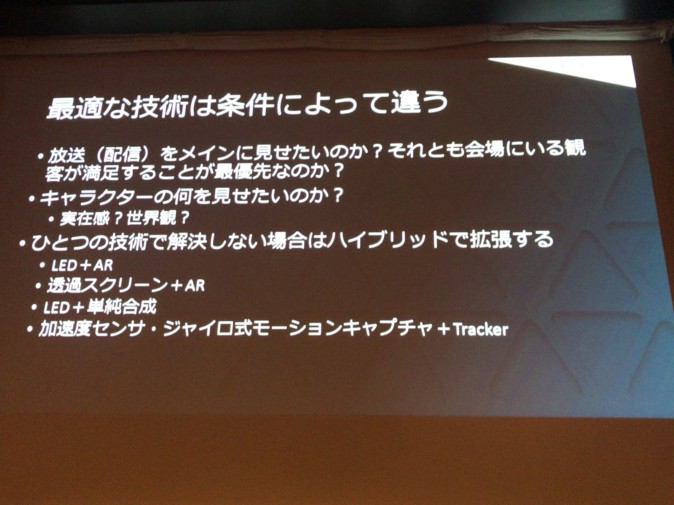

最適な技術は条件によって違う

放送をメインに見せたいのか、それとも会場にいる観客が最優先なのか、またはキャラクターの実在感を見せたいのか、世界観を見せたいのか。このように企画主旨によって最適な技術は異なるので、同じような場所で同じようにやっているものでも、使用される技術は違うとのこと。

例えば、加速度センサ・ジャイロ式モーションキャプチャで位置のズレが起きるときは光学式のものを追加して原点を補正したり、透過スクリーンだけでなくARを重ねるとか、ある技術の弱点を補強するためにほかの技術を足したりなど、ひとつの技術だけで解決しない場合はハイブリッドで解決を図ります。

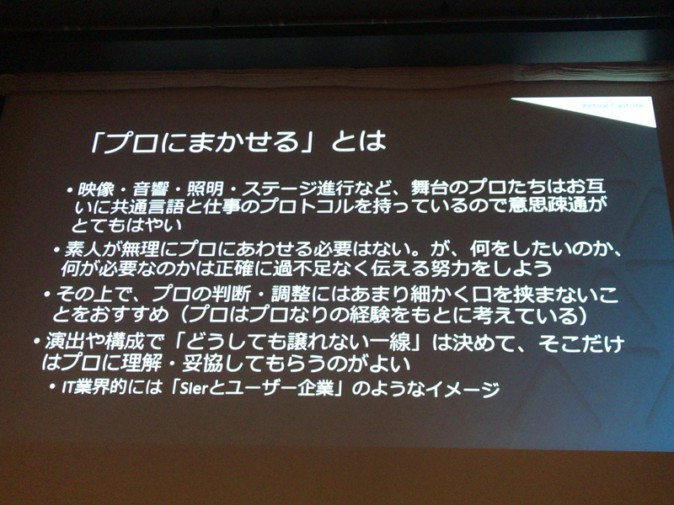

イベントにはイベントの設計がある プロにまかせる

そして、映像・音響・照明・ステージ進行にはそれぞれ専門職のプロがいるので、プロの仕事はプロにまかせることの重要性を岩城氏は強調していました。

舞台のプロはその世界の業界用語で、高速で意思疎通をしているそうです。初めてそれを聞いたときは何を話しているのかはほとんど分からないものの、何を言っているのか分からないときは無理してそれに合わせようとせず、自分は何をしたいのか、そのために何が必要なのか一生懸命説明し、その上でプロのアドバイスがあったときは素直に聞いたほうがいいと岩城氏。舞台には舞台の気にしなければいけない点があって、プロはきちんとそれを気にしてくれているからです。

その上で、演出や構成上「ここはこうしたい」という譲れない一線は決めておいて、そこに関しては交渉し、妥協してもらうというほうがうまくいくそうです。例えば、ARでキャラクターを舞台に登場させる際に、舞台照明のプロは演者がキレイにみえるように照明を当ててくれますが、照明がキャラクターにきちんと反映されているのをアピールしたかったので、あえてキャラクターに影を落としたり色を変えたりといったことをお願いした、という経験を岩城氏は述べました。

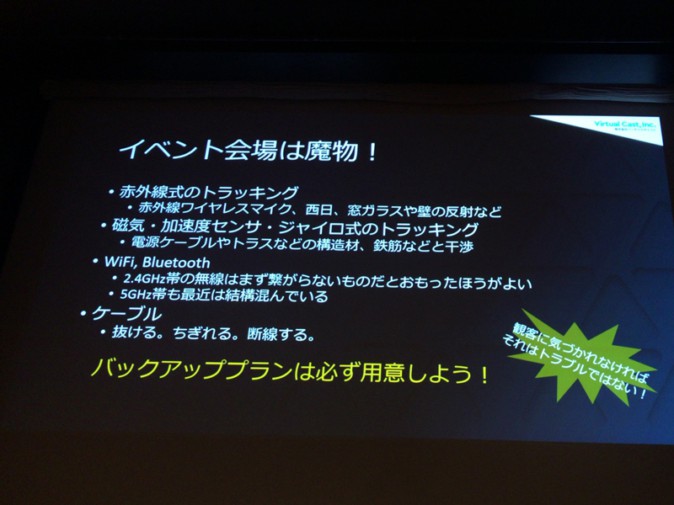

イベント会場は“魔物”

このトピックについては、経験を踏まえ「本当に何かが起こる」「必ず何かが起こる」と何回も繰り返していました。その事例として、

・赤外線式のトラッキングを用いようとした時に、会場の赤外線ワイヤレスマイクの光や、西日、ピカピカに磨かれた床による反射などで正しくトラッキングができなかった

・磁気式のモーションキャプチャでも、電源ケーブルやトラスなどの構造材で磁気が乱れてしまうことがある(MVNは最近のファームウェアでだいぶよくなった)

・無線はまずつながらないので、VIVEトラッカーなどは使いづらい

・ケーブルが抜ける、ちぎれる、断線。必ずあるので予備のケーブルは絶対に持っていく

といった事例をあげ、バックアッププランは必ず用意するよう注意喚起を行いました。それと同時に、観客に気づかれなければそれはトラブルではない、現場での機転が大事であると述べました。

キャラクター召喚事例

ここで、岩城氏がこれまで関わった中で「トリッキー」とされる事例についていくつか紹介されました。

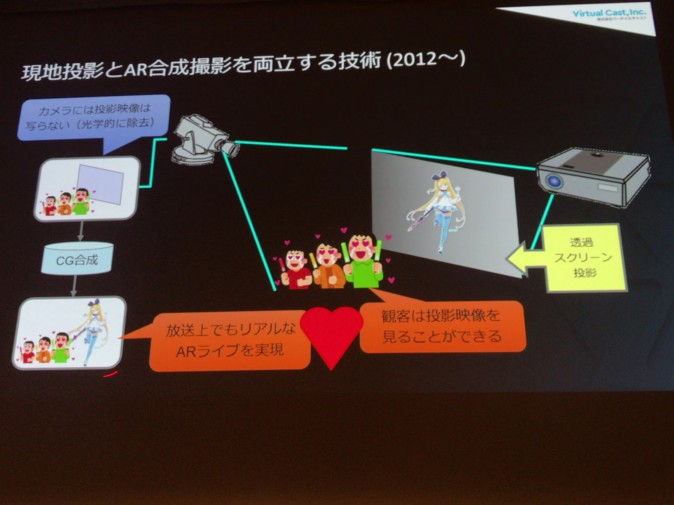

ニコニコ超パーティ2015 花たん

こちらは現地での投影とAR合成撮影の両立。カメラ越しで見てる人はARで見えるが、ステージを見ている人には舞台上にある透明なスクリーンに映された彼女を見ている(カメラ上ではスクリーンへの投影映像は光学的に除去)といった状態。

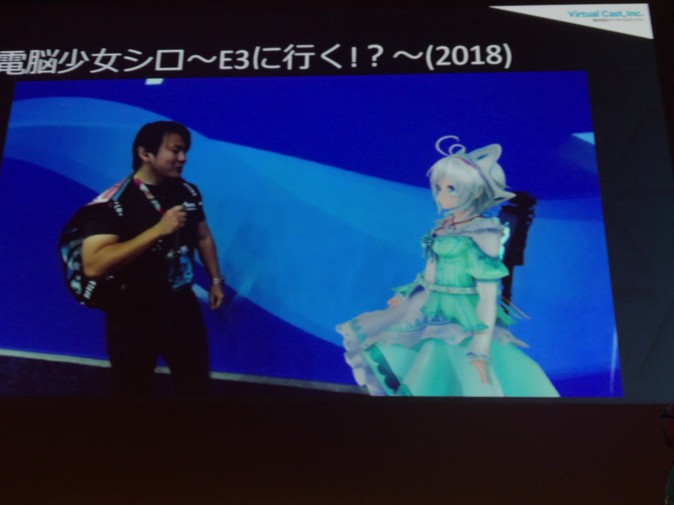

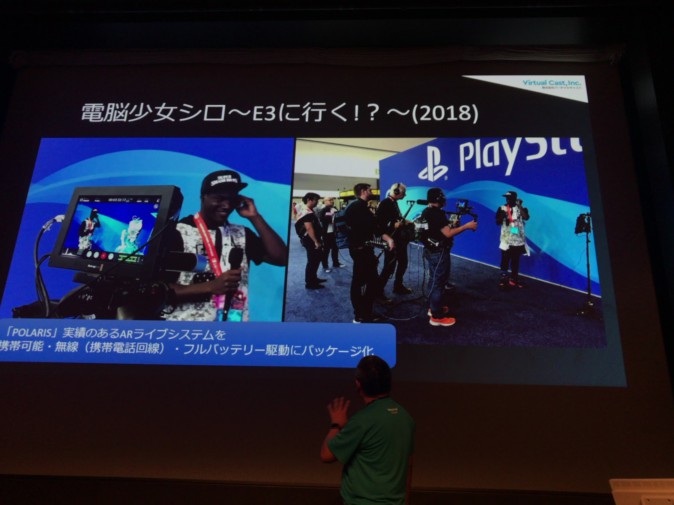

ARライブシステムのポータブル化

ARライブシステムを携帯できるようにするパッケージも開発。電脳少女シロが2018年のE3にて生レポートするという放送で使用しています。

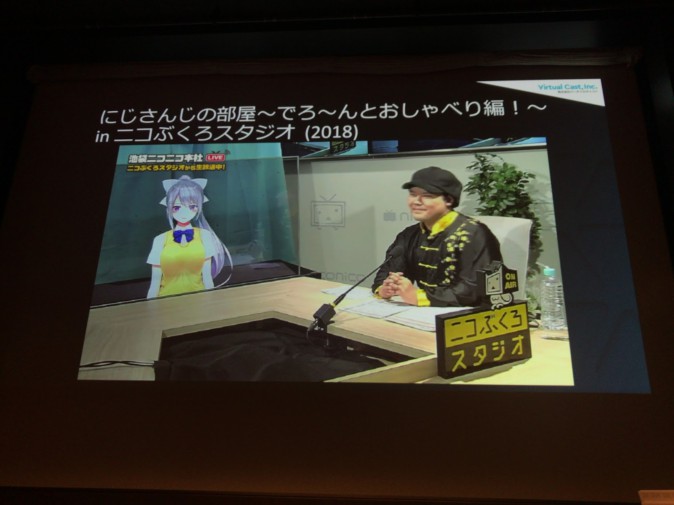

透過ディスプレイとカメラの組み合わせで自然な会話を

「にじさんじの部屋~でろーんとおしゃべり編!~in ニコぶくろスタジオ」では、透過有機ELディスプレイの裏に演者の視点用カメラを配置することで、ディスプレイの樋口楓さんと現実世界のゲスト・中音ナタさんとが目をあわせて自然に会話できるようになっています。

これは、2018年のニコニコ超会議の「超バーチャルYouTu“BAR”」でも同じ仕組みが使われています。

キャラクターの影の反映とキャラクターへの光の反映

IA & ONEのAR Live Movieでは、キャラクターをARで映すだけでなく、舞台後ろのスクリーンにキャラクターの影を投影しています。同時に、目まぐるしく変わる舞台照明をARキャラクターに反映させることで、実在感を強化する手法をとりました(舞台照明は、ダイナミックレンジを変えた2台のWebカメラに魚眼レンズをつけて撮影し、そこで得られた画像を解析するという方法でセンシングしている)。

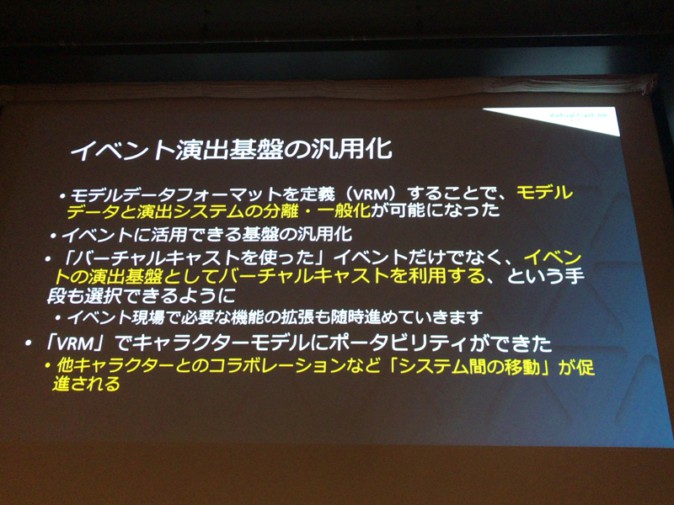

3Dアバターフォーマット「VRM」のリアルイベントへの活用

そして岩城氏は、バーチャルキャスト社などが取り組んでいる3Dアバターフォーマット「VRM」について触れました。

VRMを用いることでモデルデータと演出が分離させることができ、それによりイベントに活用できる基盤を汎用化させることができる未来が来ていると語ります。なお、バーチャルキャスト社のシステム「バーチャルキャスト」でもイベント現場で使えるような機能拡張を進めていくそうです。

最後に岩城氏は、「リアルとバーチャルの境目は技術で乗り越えられる! 積極的に境目を溶かしていきましょう!」と来場者に語りかけ、セッションを締めくくりました。

(参考)CEDEC2018 「1万人規模音楽ライブからトークイベントまで、バーチャルキャラクターをリアルイベントへ召喚する技術」