本記事はCEDEC2017で開講された、3Dオーディオに関係するセッションの内容のまとめ記事後編です。前編では3Dオーディオの用語や原理を解説する基礎的知識の紹介と、『サマーレッスン』開発で実践された事例の紹介を行いました。

後編は立体音響技術に関連する「Ambisonics」「HRTF」「バイノーラル」について、個別に詳しく取り扱っているセッションのまとめを行います。

(後編 各論)

3.基礎から応用 3DサウンドAmbisonicでなにができる?(講演ページ)

4.HRTFを極めた者が3Dオーディオを制する!? ~カプコンとヤマハの3Dオーディオプラグイン共同開発事例~(講演ページ)

5.VRサウンドの究極演出 リアルタイムバイノーラルの挑戦(講演ページ)

3.基礎から応用 3DサウンドAmbisonicでなにができる?

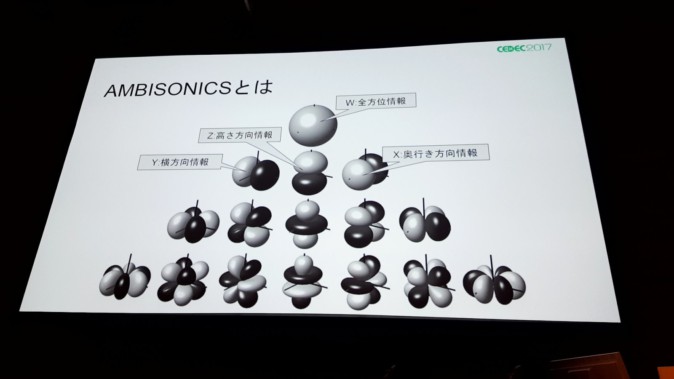

Ambisonicsとは

1970年代から始まった、ある一点(聴き手)を取り巻く音場全体の物理情報を記録再生するシステムのこと。

ゼンハイザー社の手掛けるAmbisonics用マイク「AMBEO VR MIC」

上図のようなAmbisonics用マイクは、正四面体の頂点の位置計4か所にマイクが設置されています。このマイクで収音したデータはA-Formatと呼ばれます。

このA-Formatのデータを改めて全方位のWとXYZ軸の4方向(上図の上から2段目までの4つのモデル)に変換したものをB-Formatと呼び、これがAmbisonicsに使われます。

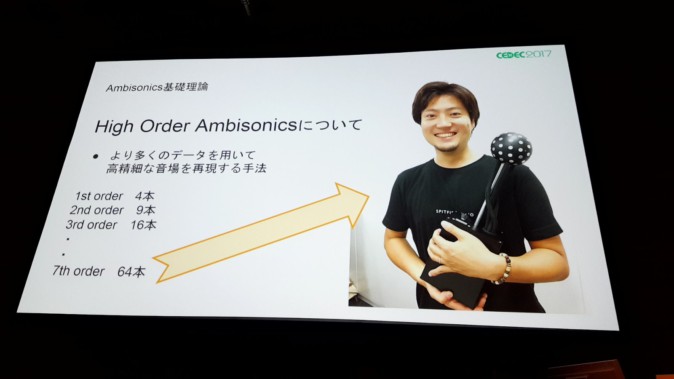

4つのデータを使う通常のAmbisonicsをFirst Order Ambisonics(FOA)と呼ぶ一方で、3段目以降のデータも取り入れた、より高品質なものをHigh Order Ambisonics(HOA)と言います。

Ambisonicsを用いるメリットとして、出力先のチャンネル数に関係なく(ステレオミックスなどを個別に用意する必要がなく)常に同じデータを利用できる点、またストリーミングのデータで音場を再現できる点が挙げられます。また音場の回転が容易なため、360度動画などと相性が良いとされます。

A-FormatからB-Formatへの変換には、様々な無償プラグインも公開されています。

HOAはまだ発展途上の技術ですが、HOA対応のマイクとして64ch収録が可能な「ViReal Mic」(ヤマハ)が登場するなど、今後に期待です。

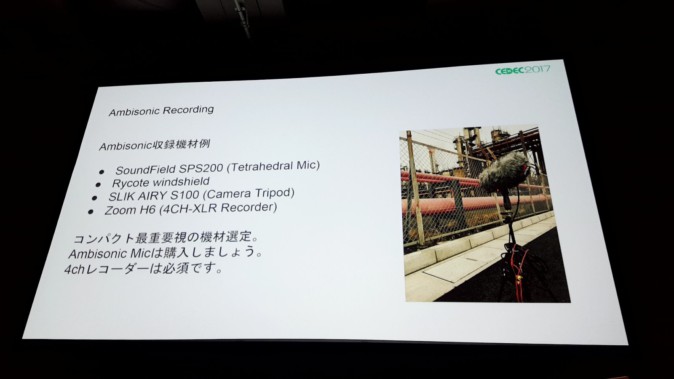

Ambisonicレコーディング

収録の注意点として、以下のようなことが紹介されました。

・回転具合のリアルタイムチェックができない

・どの向きを正面としたかを覚えている必要がある(正面情報が記録されない)

・入力ゲインや加工時の処理はすべてのチャンネルデータで同じにする必要がある

など。

Ambisonicレコーディングの手順や実例として、以下の動画などが挙げられます。

【チュートリアル】ゼンハイザー「AMBEO VR マイク」録音からYoutube掲載まで

【360°音声つき映像】ゼンハイザー 「AMBEO VR マイク」と「Ricoh Theta」で収録

F2/F15フライバイ

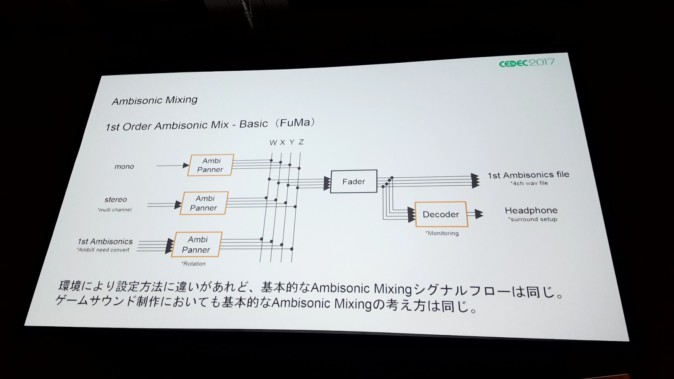

Ambisonicミキシング

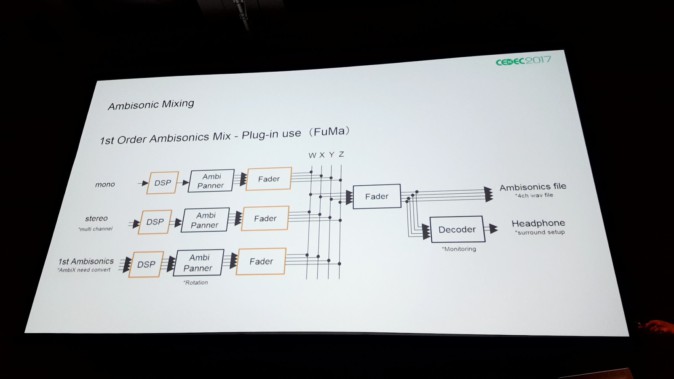

まず、Ambisonicsミキシングには各社から様々に出ている「Ambisonic Pannner」と「Ambisonic Decorder」が必要になります。たとえばNoise Makersによる「Ambi Pan」・「Ambi Head」や、Audio Easeによる「360monitor」・「360pan」など。

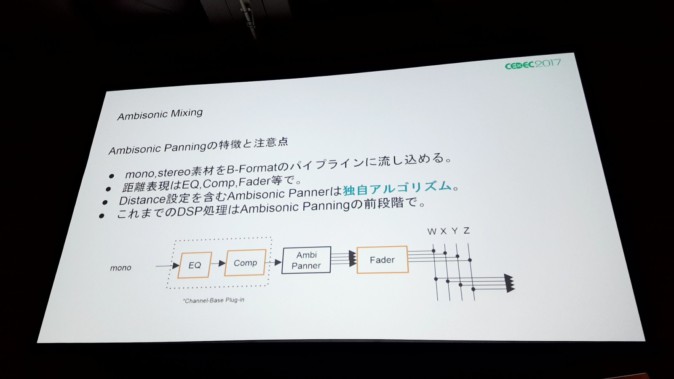

ミキシングは上図に示される通り、各種音源をパンニングしたB-Formatデータをフェーダーに流し込み、(ヘッドホン向けならデコーダーを通して)アウトプットします。

従来のデジタル信号処理を行うのであればパンニング前に行います。

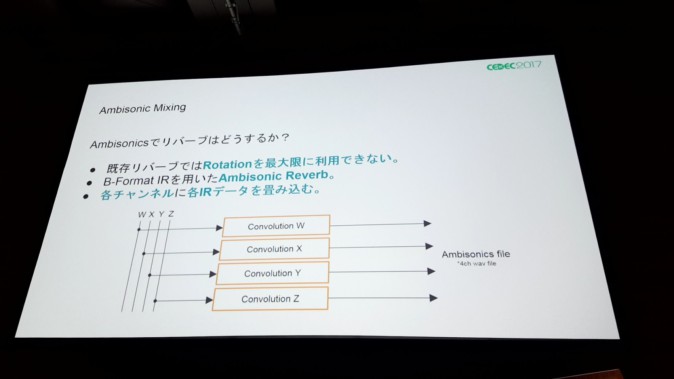

また既存のリバーブでは回転を最大限に活かすことが出来ないため、Ambisonic用のリバーブが推奨とのこと。

その他、ナレーションを回転させたくない場合は、無指向性のWチャンネルに配置するという方法も紹介されました。

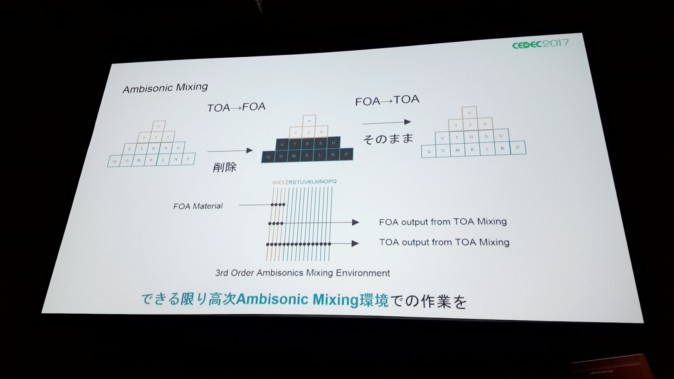

またAmbisonics音源では、これまでの「5.1ch→ステレオ(2.0ch)」にするためのダウンミックスのような作業が不要になります。高次のAmbisonics音源を低次にしたい場合、高次の部分を削除してやるだけでいわゆる“変換”が可能です。

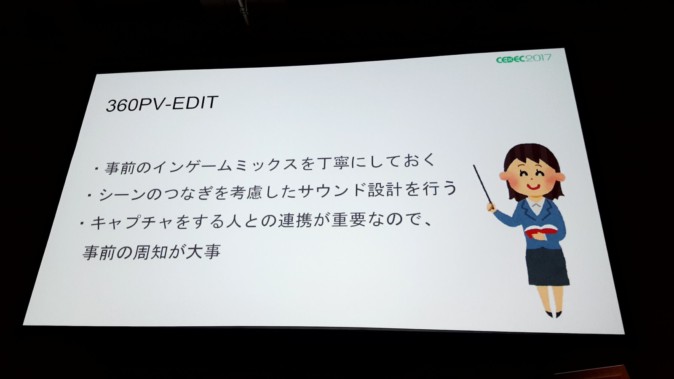

Ambisonicsのゲーム応用

たとえば

「早い納期でVRゲームのPVを作る仕事が来た。絵は回転しても音は回転しない……」

「旧作のVRリメイクをするとき、カットシーンの仕込み直しが面倒くさい……」

こういった問題は、Ambisonicsをうまく使うことで解決できる可能性があります。

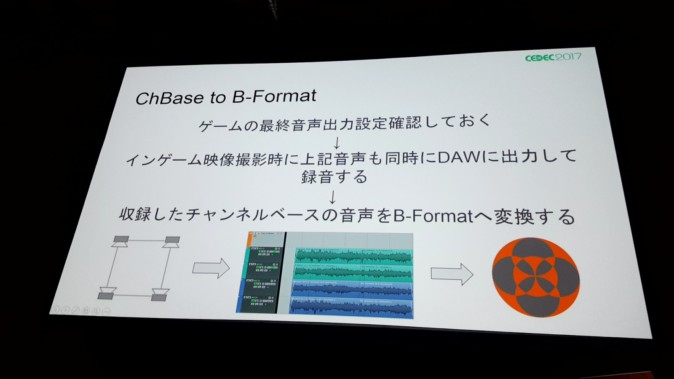

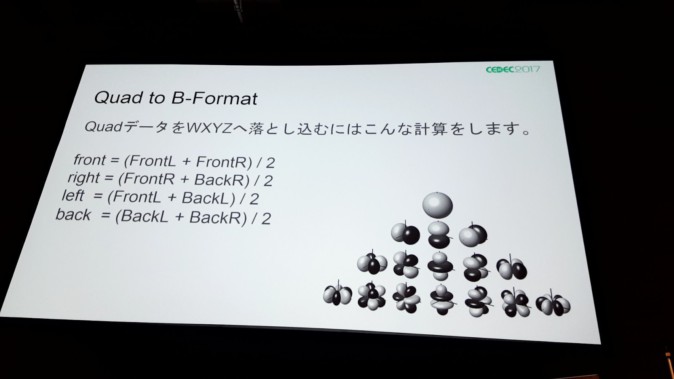

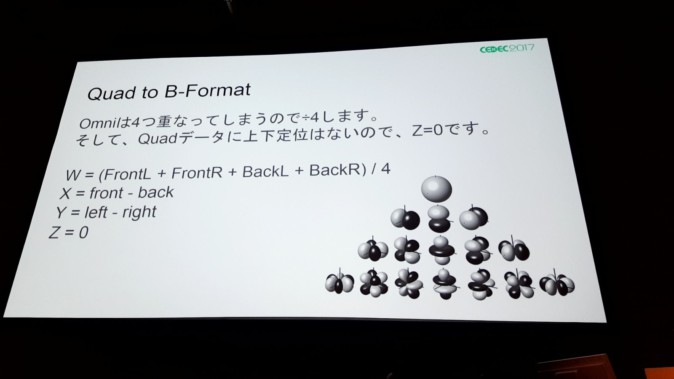

既にもとのゲームにおいて、音声の仕込みがきちんと出来ている物に関しては、チャンネルベースの音声をB-Formatに変換するという手法が使えます。

こういったB-Formatへの変換は、専用のツールを使うことで簡単にできるそう。

また別の方法として、インゲームのAmbisonicsバスを直接録音してしまうアプローチもあります。

これらの手法で素材をAmbisonics化することで、オブジェクトベースの音源をシーンベースに置き換えることができ、処理の削減につなげることが出来ます。ただ、Ambisonics音源は現状データ容量が大きく、圧縮技術の改善も求められるのが現状です。

4.HRTFを極めた者が3Dオーディオを制する!? ~カプコンとヤマハの3Dオーディオプラグイン共同開発事例~

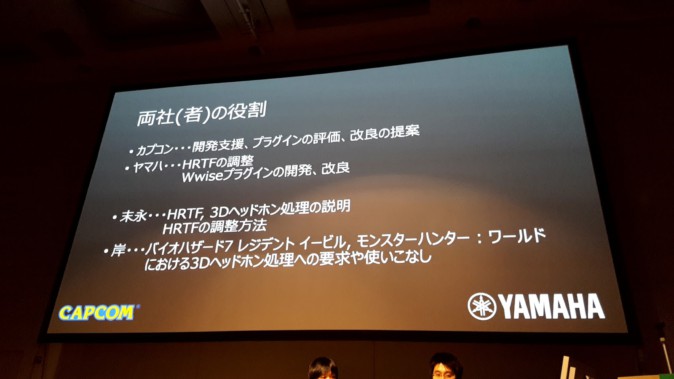

このセッションは株式会社カプコンの岸 智也氏とヤマハ株式会社の末永 司氏が登壇し、カプコンとヤマハが3Dヘッドホン処理(プラグイン)の共同開発をしたことについて、プラグインの詳細や開発Tipsが紹介されました。

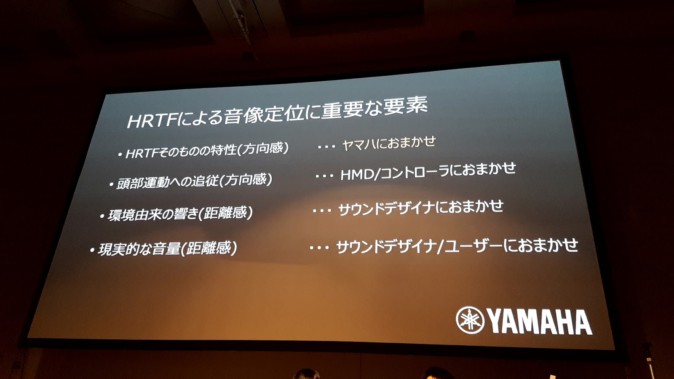

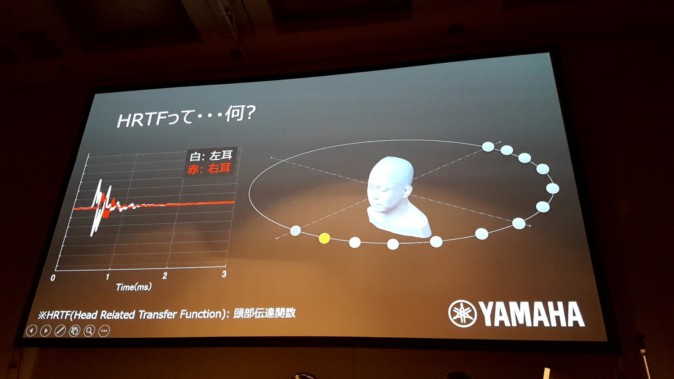

HRTFとは

Head Related Transfer Function、頭部伝達関数のこと。ある音が特定の位置から両耳に届くまでの特性を表すものです。

人間の耳は頭部の側面に一つずつ付いており、左右で物理的に位置が異なります。また耳の形状も人によって異なります。HRTFはこれら物理的要因を考慮し、音がその人にどのように聞こえるかを表しています。

このHRTFは、たとえばカリフォルニア大学デービス校の研究室や東北大学など、様々な研究機関が集めたデータセットが公開されている他、実際に個人のHRTFを測定したり、耳などの形状データから音響シミュレーションによって計算したりすることで得られます。

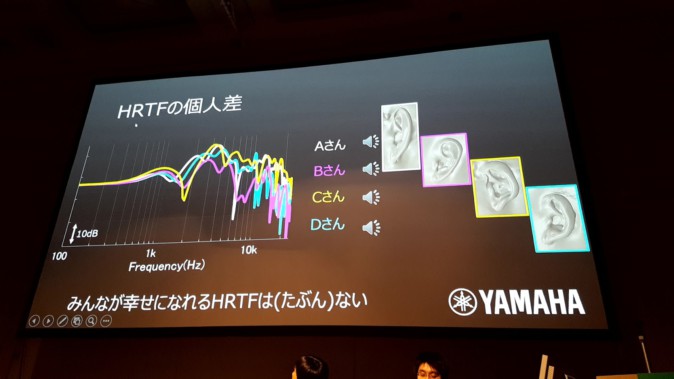

ただHRTFは個人差が大きく、自分のものではないHRTFで音を聞くと、定位のずれや音色の違和感などが生じてしまいます。

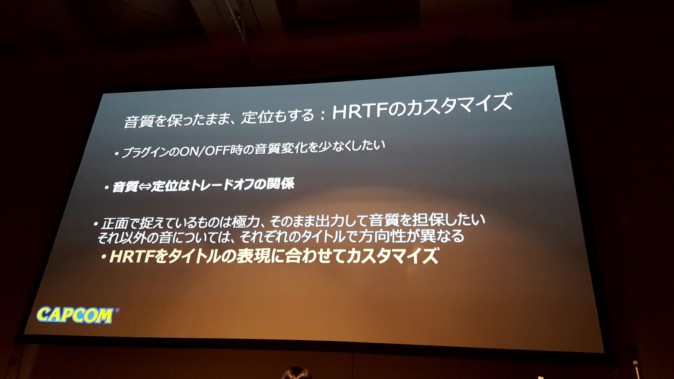

HRTFを利用することで、ヘッドホンでも360度の立体音響やスピーカーでは難しい近距離の音像を実現できる利点がありますが、HRTF自体に個人差があることや、ON・OFFでの音色の差が大きいことが問題としてありました。

各ゲームに合わせたHRTFのカスタマイズ

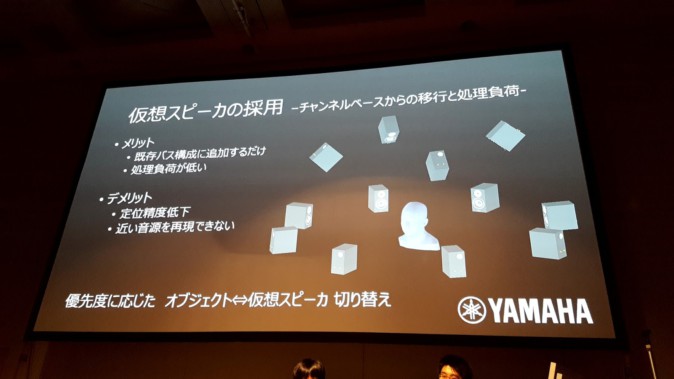

当初ヤマハ側は、オリジナルのHRTFデータを用いて音源1つにつき処理を1つかけるエフェクトプラグインを制作していました。定位感などははっきりと得られるのは良かったものの、ゲームへの応用という観点からいくつか問題が出たそうです。

1つはオブジェクト数に応じて処理負荷が大きくなってしまう点、そしてもうひとつはON・OFFでの音色差が大きすぎたことです。

処理負荷に関しては、プラグインはミキサーにかけるタイプにしてバーチャルサラウンド(仮想スピーカー)とオブジェクト定位を並列させる仕様にすることで解決。

ON・OFFの音色差問題は、ゲームタイトルに合わせてHRTFをカスタマイズすることで解決したそうです。

たとえば『バイオハザード7 レジデント イービル』は、上方向の移動物は少ない一方で、画面外の音や後ろの音の定位を感じさせたいというゲーム内容でした。一方で『モンスターハンター:ワールド』では空を飛ぶ敵や環境音の臨場感など、上や後ろに回ったときの定位感を必要としています。

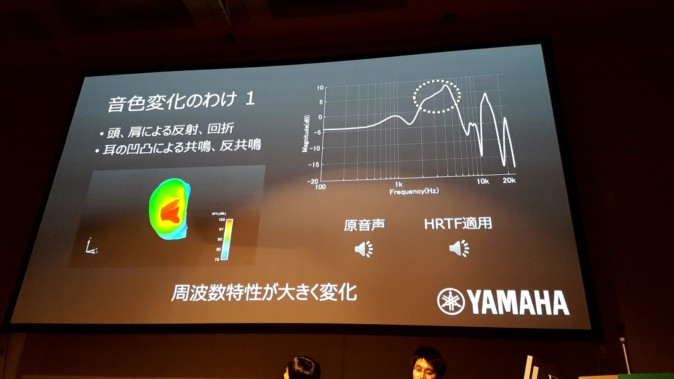

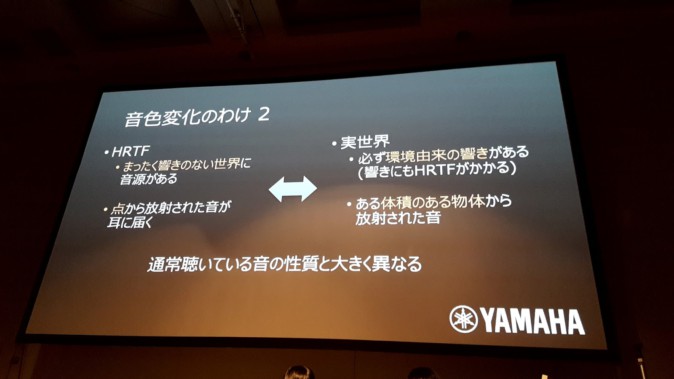

HRTFをON・OFFすることで音色が変化する理由は、主に耳の形状による音波の共鳴・反共鳴によるもの。4kHz付近が10dB程度増幅された特性を示しています。またHRTFは無響の世界に点音源があることをシミュレートしたもので、現実環境とは異なるという点も挙げられました。

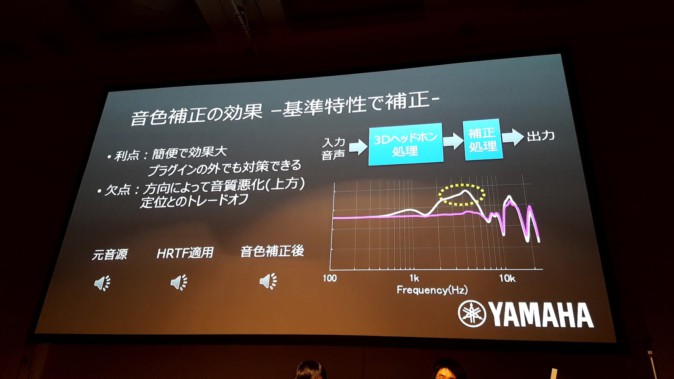

ヤマハが行った対策の1つは、基準となる位置(たとえば正面)の特性をイコライザーで補正するというもの。ただし正面を合わせても他の方向(たとえば上方向)では高音がきつくなるなどの音質問題があったり、定位感とトレードオフになる行為なので慎重に行う必要があるとのこと。

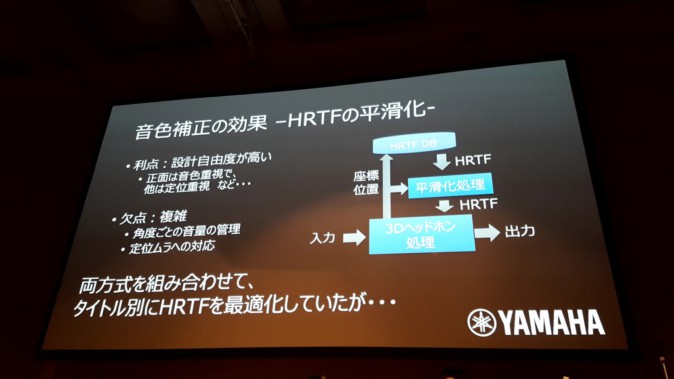

また別の対策として、HRTF自体を平滑化することも行われました。

HRTFを強調する

この3Dオーディオプラグインを『モンスターハンター:ワールド』へ導入することを決めた時、カプコン側はヤマハに、モンスターの動きの臨場感を増すためにさらなる定位感の強調を打診したそうです。

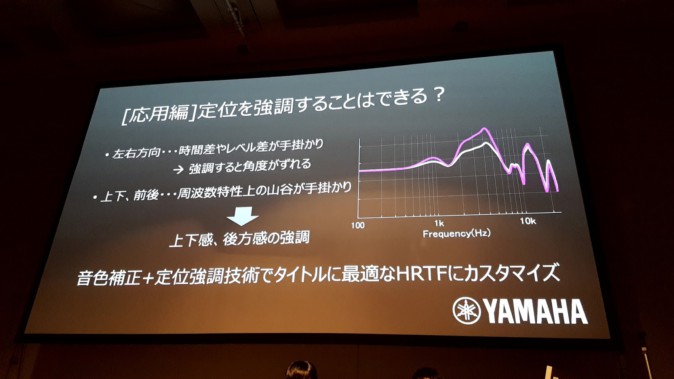

ヤマハ側は、「左右の定位感は、音が左右それぞれの耳に届く時間差やレベル差が手がかりになっているため、強調すると角度が崩れてしまう恐れがある。一方で上下や前後の定位感は周波数特性の変化が手がかりになっているので、強調が可能」といった対応をしました。

最後に

岸氏は最後に「個人差のあるHRTFを、開発側がどう評価し、どれを採用するのか」といった問題に触れました。今回カプコンでは、開発メンバー個人のHRTFをそれぞれ測定し、汎用的なHRTFと自分のものの差異を確認した上で議論をするようにしたとのことです。

5.VRサウンドの究極演出 リアルタイムバイノーラルの挑戦

登壇したのは株式会社カプコンの中島 健太郎氏と宮田 祥平氏。世界初の取り組みとなるバイノーラル収録音のリアルタイム制御を考案し、検証した結果が紹介されました。

開発の経緯

中島氏がかつて各社3D Audioプラグインの性能を比較検証した際、各社2000Hz以降の周波数に大きな変化が見られました。そこでこの周波数変化によって音質変化と距離感が生まれると予想し、これを改善したいと思ったと言います。特に近くの物の近接感を表現しようとする時、既存のプラグインでは物足りないと感じたのだとか。

氏はバイノーラル収録の音源なら、近接感と音質のクオリティが高いことに注目。そこでバイノーラルマイクの弱点である「回転に対応できない(プレイヤーの視界に合わせて音が動かない)」という問題を、解決することに。

バイノーラルマイクで上下前後左右の6方向を収録し、リアルタイム制御で回転させることが考案されました。

収録と検証

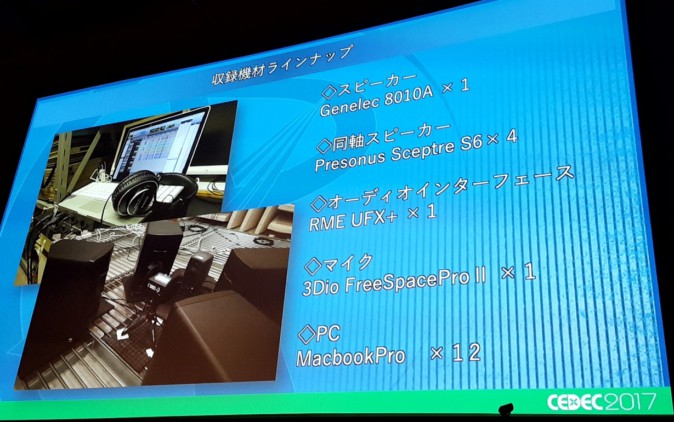

〇収録機材

バイノーラル収録に用いた機材。特にスピーカーでは、「バイノーラル収録では音源位置が点で発音すべき」といった観点から、より音像のはっきりする同軸スピーカーを採用したとのこと。(※スライド注 使用Macbook Proは1台)

また収録時には反響音が入ることを避けるため、無響室が推奨だと言います。

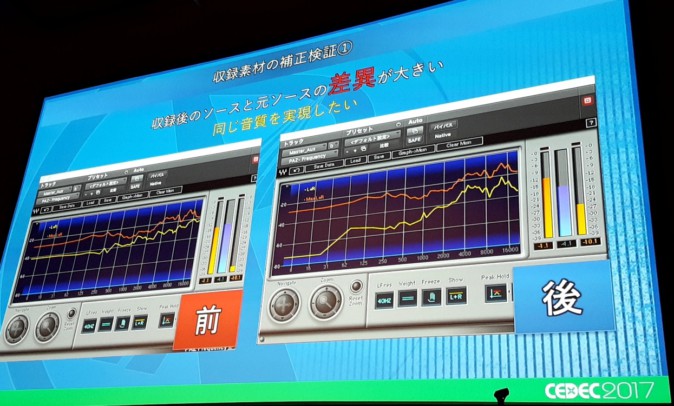

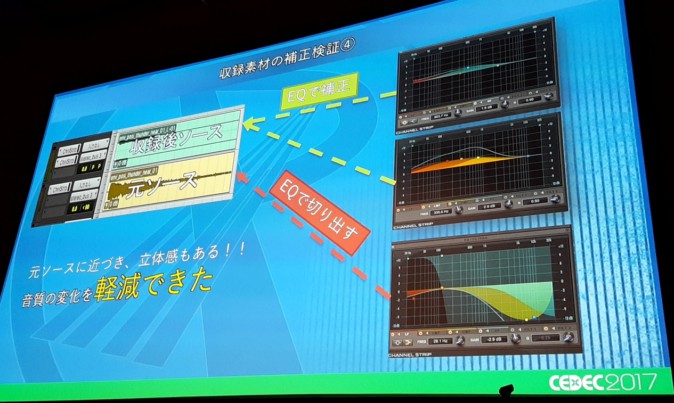

〇収録後の補正

収録の前後で音質(特に低周波数領域)が変化してしまうという問題は、「収録後のソース」と「元ソース」の両方を組み合わせ、イコライザーで補完。この補正は6方向全ての音源に対して行われました。

〇収録距離

今回「近接感」をテーマに、マイクとスピーカーの距離を1m・50cm・30cm・10cmと変えたところ、バイノーラル特有の音の近接感と方向感を損なわない適切なバランスは30cmの距離だったそうです。マイクとスピーカーの距離は、求める音によって変えればいいだろうと中島氏は言います。

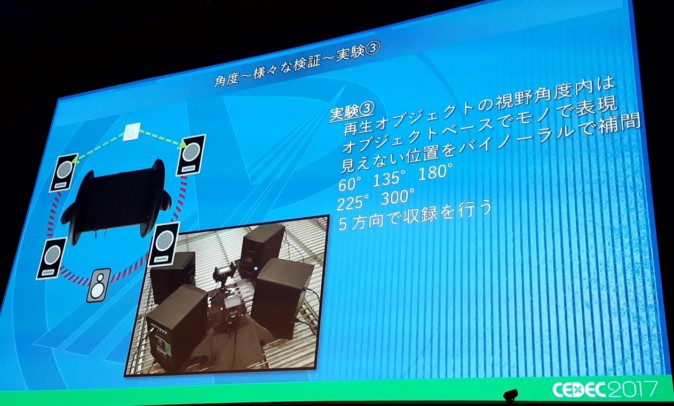

〇収録角度

前後左右の位置で収録を行った結果、左右は分別が容易だが前後の区別がつきにくい結果になったとのこと。これは正面と後ろでは、音が耳に到達する時間がほぼ同じだからではないか、と考察されました。

そこで今度は45度・135度・225度・315度と、斜め方向にスピーカーを置いて収録したところ、後ろ方向のわかりやすさは改善したものの、前方向の認識がまだ難しかったそう。

結局方針を変えて5方向での収録を行い、再生オブジェクトの視野角度内ではオブジェクトベースで鳴らし、見えない位置をバイノーラルで補完することに。

実装方法

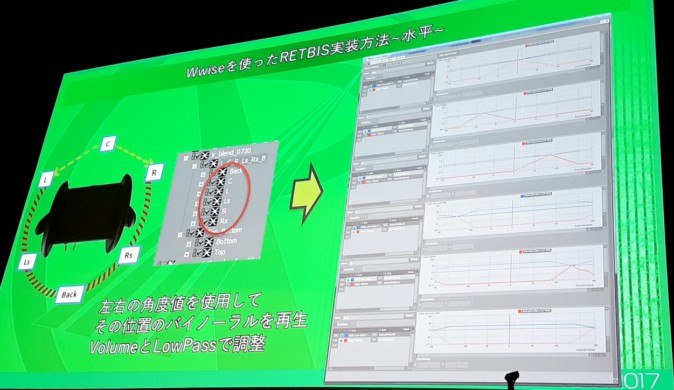

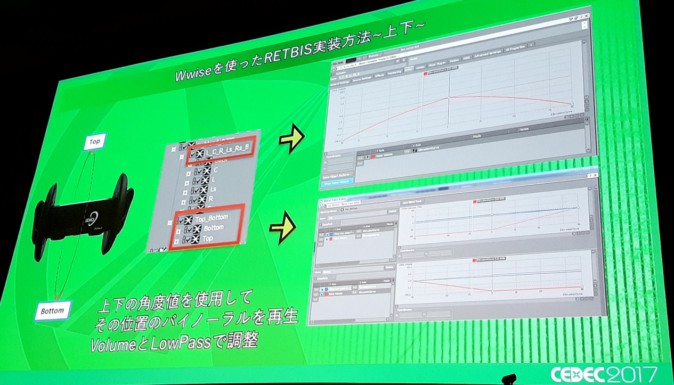

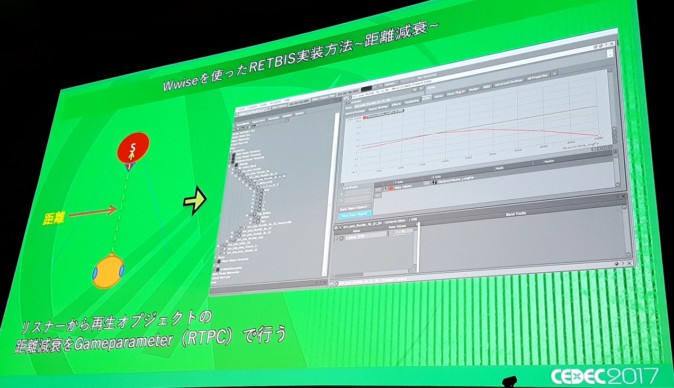

WwiseとCRIWAREでの実装方法が簡単に紹介されました。両者基本的に行うことは同じです。

波形のブレンド

水平角度ごとの音の鳴り方を調整

上下方向の角度でも同様

距離減衰の指定

(RETBISはREal Time Binaural Systemで、本セッションで解説したリアルタイムバイノーラルシステムのこと)

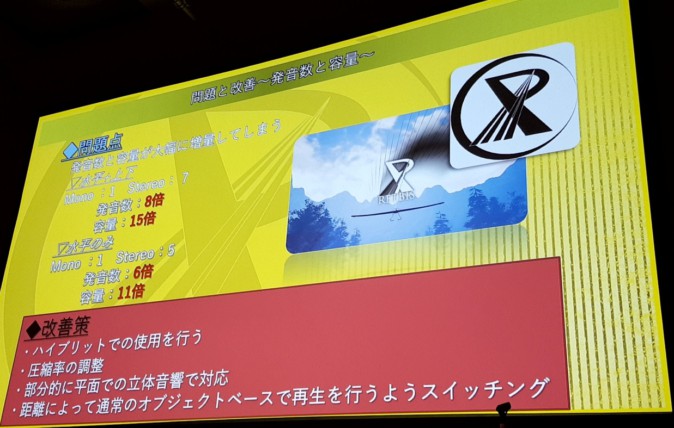

結果と課題

本システムの開発により、近接感再現と音質変化の軽減が達成できました。しかし一方で、前後左右上下のすべてにリアルタイムバイノーラルを適用すると、発音数8倍・容量15倍と、非常に大きなサイズになってしまう問題があります。改善策として中島氏は、別の手法とのハイブリット使用を行うことや、圧縮率の調整を挙げました。