2021年5月18日~20日(日本時間5月19日~21日)にかけて開催されているGoogleの開発者会議「Google I/O 2021」において、ARCoreの最新アップデート内容が発表されました。

最新版となるARCore 1.24では、新たに「Raw Depth API」「Recording and Playback API」を導入。開発者が新しいタイプのAR体験をより短期間で作れるようになるとしています。

精度がより向上した「Raw Depth API」

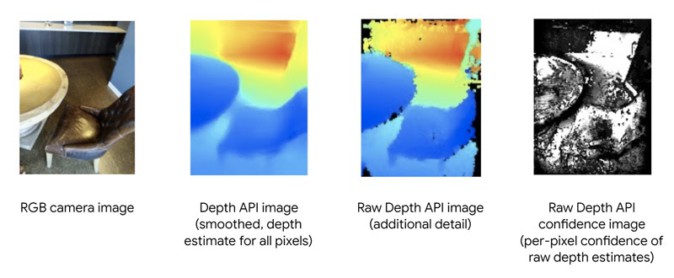

2020年6月のARCoreアップデートでは、スマートフォンのカメラだけで奥行きを含む空間情報を取得できる「Depth API」が導入されています。

今回新たに導入される「Raw Depth API」では、従来のDepth APIでは取得しきれなかった“生の”深度マップを生成。より正確な深度測定と空間認識が可能になります。また、ユーザーがアップロードした2D画像を現実世界のオブジェクトに貼り付けたりなど、深度データをリアルタイムにフィルタリングすることもできるようになります。

(右の2つがRaw Depth APIを利用して作られた深度データ付き画像の例。画像元:Google)

(TikTok(左)および3D Live Scanner(右)でのRaw Depth API使用例。画像元:Google)

さらに、深度マップの判定精度も強化。平面でないエリアや、視覚的特徴が少ないエリアでのデータ検知率が向上しています。

(平面ではなかったり、視覚的特徴が少ない場所での深度データ検知精度も向上。画像元:Google)

なお、Raw Depth APIは従来のDepth APIと同様、スマートフォンのカメラのみで動作します。特殊なセンサーは必要としませんが、ToF(Time-of-Flight)センサーがあればさらに体験の質が向上するとのことです。

取得した深度データを復元できる「Recording and Playback API」

ARコンテンツ制作の過程では継続的なテストが必要です。しかし、特定の場所に紐づくARコンテンツでは、開発者が毎回その場所に行けるとは限らず、また、照明状態や置かれているオブジェクトの状態なども毎回変化している可能性があります。

今回導入された「Recording and Playback API」では映像データのほか、慣性データや深度データも記録することが可能。これにより、開発者は毎回同じ状態のデータでテストすることができ、コンテンツ制作の手間が軽減されます。

(Didi Chuxing社のスマホアプリ「DiDi-Rider」。Recording and Playback APIの利用によりテスト費用を25%、撮影のための移動費用を60%削減。開発期間も6か月早めることができた。画像元:Google)

また、Recording and Playback APIを利用することで、時間や場所の制約を受けない非同期型のAR体験が可能になります。例えば、ARで家具の試し置きをする場合、ユーザーは自宅の3Dマップ映像を取り出して、そこにARの家具を配置できます。ユーザーは家の中にいる必要すらなくなり、「ARをどこにでも持っていける」ようになります。

(韓国のSK Telecomのスマホアプリ「JumpAR」。室外で撮影した映像を自宅に持ち込みARコンテンツを楽しめる。画像元:Google)

(Nexus Studiosのスマホアプリ「VoxPlop!」。AR空間にユーザーが手を伸ばして3Dキャラクターとインタラクションできるほか、その様子を録画して家族や友人と共有もできる。画像元:Google)

今回導入された新APIについては、いずれもARCore開発者サイトから参照することができます。