XR/メタバースをテーマとした国内最大級のカンファレンス「XR Kaigi」が今年度も開催されました。今年の「XR Kaigi 2023」は「さらに未来に近づく10年へ」をテーマとし、オンラインと現地、双方で計60以上のセッションが実施されています。

今回はその中から、12月22日に行われたセッション「最新ARデバイスで迫力の3Dジオラマ体験!~『Diorama Vision』の概要と開発Tips ~」をレポート。登壇者は、アップフロンティア株式会社の代表取締役社長、横山隆之氏と同社システム開発部 XRチームリーダー エンジニア鬼村遼太郎氏です。

観光/防災/建設等で使える、Project PLATEAUを活用した新視覚体験「Diorama Vision」。開発で得た知見を、前半はサービス概要、後半はARインタラクションデザインという2段組みでお届けします。

ARアプリの開発に取り組むアップフロンティア

まずは横山氏が登壇。アップフロンティアの取り組みについて紹介しました。2005年12月に設立されたアップフロンティアは、現在はスマートフォン向けアプリの開発とそれに付随するサーバー系アプリの開発を主軸に事業を展開しています。XR領域には2014年1月に参入、直近ではARアプリの開発に注力しています。横山氏によれば、「最新のデバイスは一通り購入し、市場に受け入れられそうかを判断しながら開発をしている」とのこと。

ARデバイスの普及は「まだまだ」

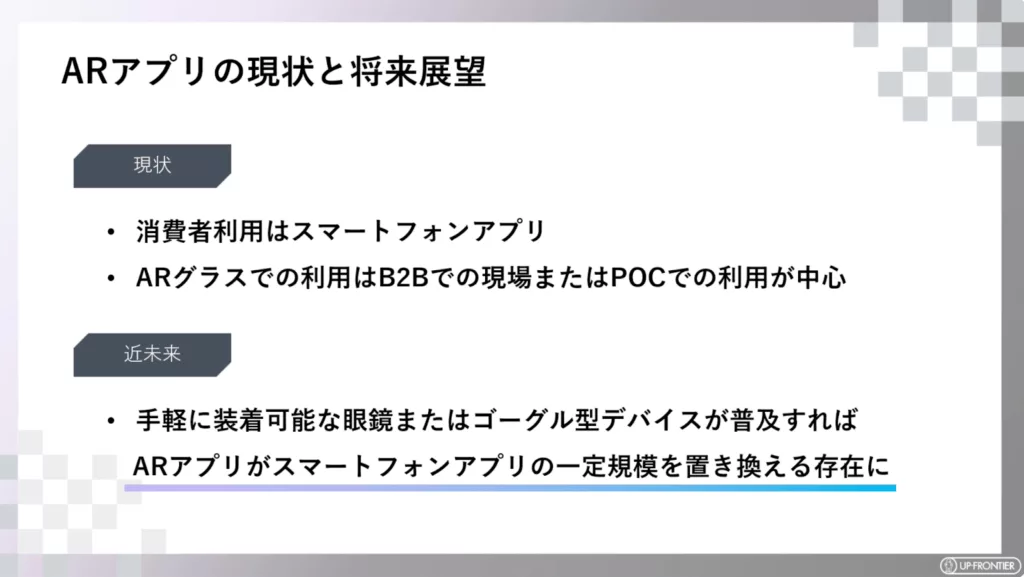

続いて横山氏は、ARアプリの現状と将来の展望、ARデバイスの現状について語りました。消費者は主にスマートフォンでARアプリを使用しており、「ARグラスはBtoBの建築現場や工場、研修、実証実験等で使用されているため、BtoCの市場では普及していない」とコメント。将来的に超軽量のARデバイスが登場すれば、ARアプリは急速に普及しスマートフォンアプリを置き換える存在になるのではないかと予測しました。

ARデバイスの現状としては「性能が高いものが増えている」と前置きしたうえで、とくにパススルー機能を搭載したデバイスに期待を寄せました。MetaのVR/MRヘッドセット「Meta Quest 3」向けのアプリを開発し、その可能性を探っているとのこと。

マルシェの出店情報や植物をARで表示

続いて、アップフロンティアのXRアプリの事例紹介に移りました。1つ目の事例は、同社と清水建設会社らが共同で開発した豊洲の場外マルシェのガイドARです。

(出典:アップフロンティア株式会社)

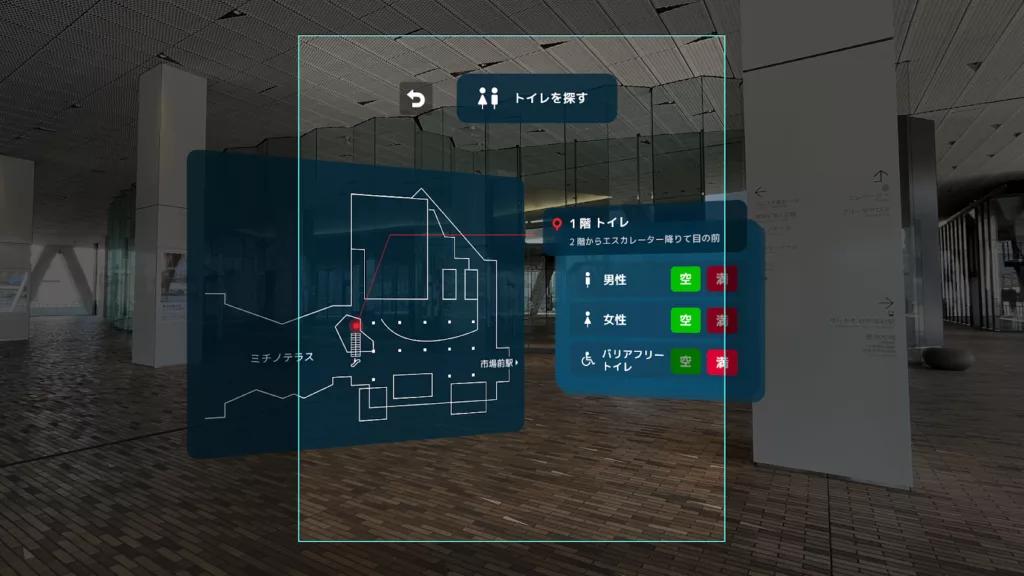

月に一度豊洲駅前で開かれる「豊洲場外マルシェ」は新鮮な海産物や青果を取り扱う、いわば”都市型の道の駅”。清水建設の都市OSと連携することで、ARグラス越しに販売商品や最新のイベント情報、リアルタイムのトイレの空室状況などを確認できます。

(出典:アップフロンティア株式会社)

AR表示には、VPS(Visual Positioning System)の「Immersal」を使用し、現地の地形にフィットした演出を実現しているとのこと。また、デバイスにはMagic Leap社が開発したARヘッドセット「Magic Leap 2」を採用。同デバイスの特徴であるDimming(調光)機能により、屋外でも輝度を担保することで視認性を高めています。

https://www.youtube.com/watch?v=GAa_PrAt8GQ

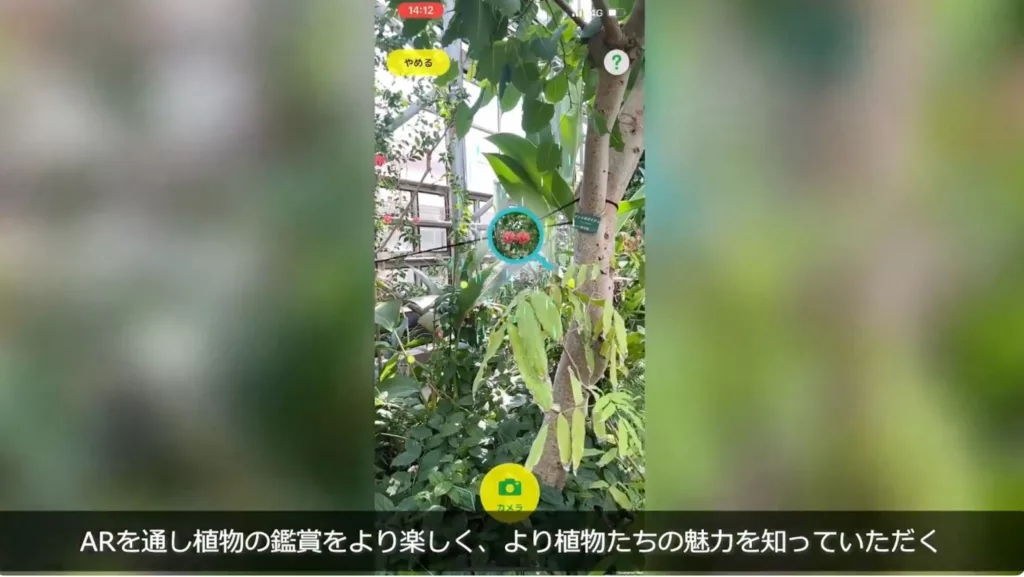

2つ目の事例は、東京都の湯の島熱帯植物館で使用できるスマートフォン向けARアプリ「熱帯植物 虫めがねAR」です。

館内に設置された2次元バーコードを読み取ると、詳細な植物の情報がARで表示されます。季節ごとに表示したい植物の情報が変わる場合は、サーバーを通じて情報を配信できるのだそう。

https://www.youtube.com/watch?v=07c95juMmRM

3DジオラマでARグラス越しに地域情報を“みる”

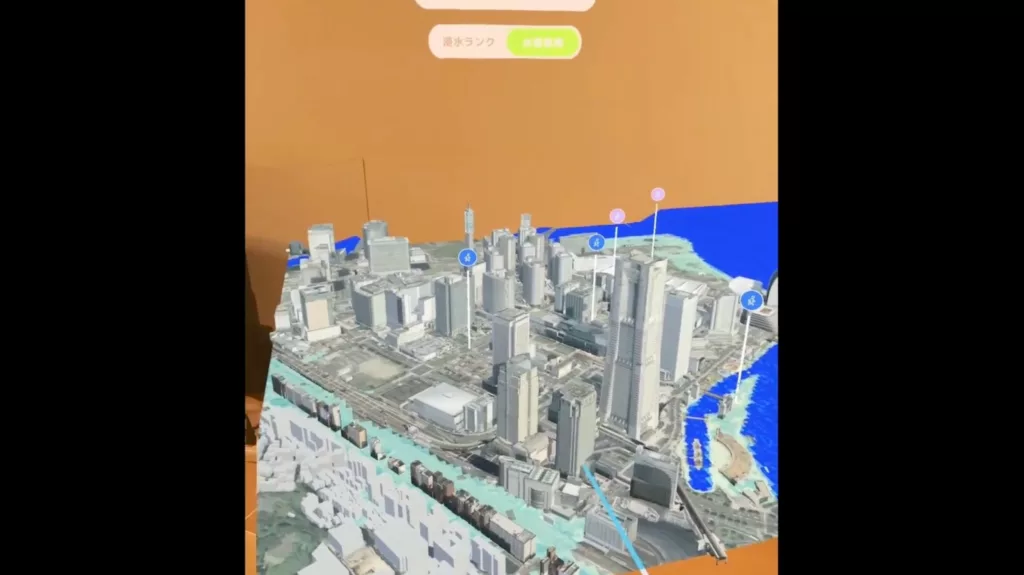

ここからは本題である、アップフロンティアのサービス「Diorama Vision(ジオラマビジョン)」の紹介です。

ジオラマビジョンは、地域情報をARグラスを通して3Dジオラマ上で見ることができるソリューションサービス。国土交通省の3D都市モデルの整備・オープンデータ化プロジェクト「Project PLATEAU(プラトー)」の3Dデータを利用しています。

https://www.youtube.com/watch?v=t57o1UIdNUQ

「ジオラマビジョンは4つの特徴があります。1つ目は、現地に行かなくてもジオラマ上で目的地の周辺情報を確認できること。2つ目は『Magic Leap 2』に対応しており、ダイナミックで新感覚な映像がみられること。3つ目はプラトーのデータを使用しているため、全国各地の都市に対応できること(2022年時点で全国約130都市)。最後に、ARグラス以外のデバイスにも対応していることです」と横山氏。

(ソニー株式会社の空間再現ディスプレイ「ELF-SR2」でジオラマビジョンを利用する様子)

ユースケースとしては、観光案内やモデルルームでのシミュレーション、防災啓蒙・教育での使用等を想定しています。

対応端末の拡大も予定中。2023年10月に発売された「Meta Quest 3」に既に対応しているほか、「Vision Pro」への対応に向けた開発にも着手しているといいます。横山氏は最後に、ジオラマビジョンの導入クライアント、用途開発パートナー、販売パートナー、各種データ提供パートナーを募集していると語り、前半を締めくくりました。

ARインタラクションをどうデザインしたか

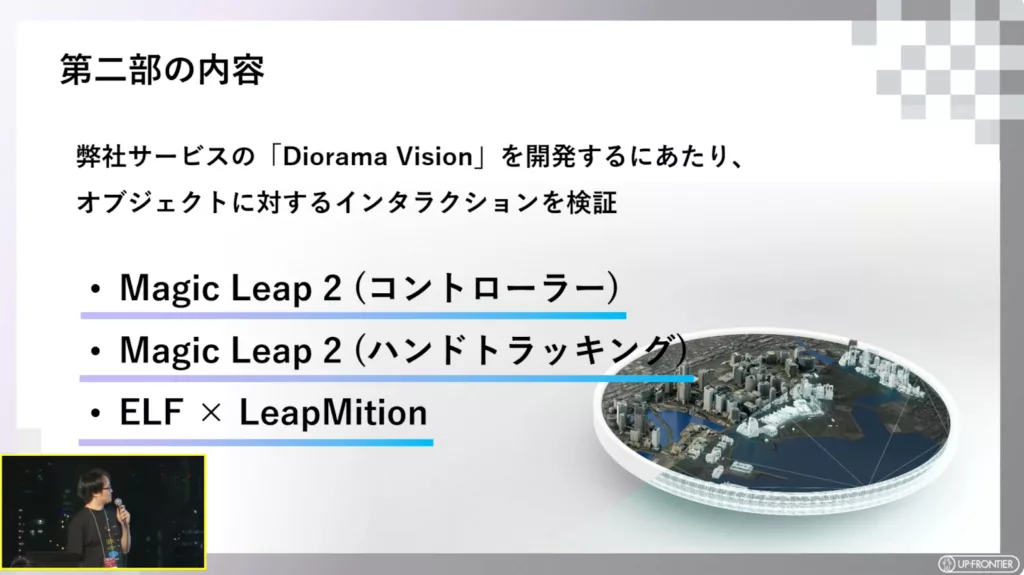

後半は、鬼村氏よりジオラマビジョンのARインタラクションデザインについて説明が行われました。

鬼村氏は、ジオラマビジョンの開発にあたって、「Magic Leap 2」のコントローラー操作、ハンドトラッキング、ELF-SR2とLeap Motionをかけあわせたハンドトラッキングを対象に、オブジェクトに対するインタラクションを複数検証しました。

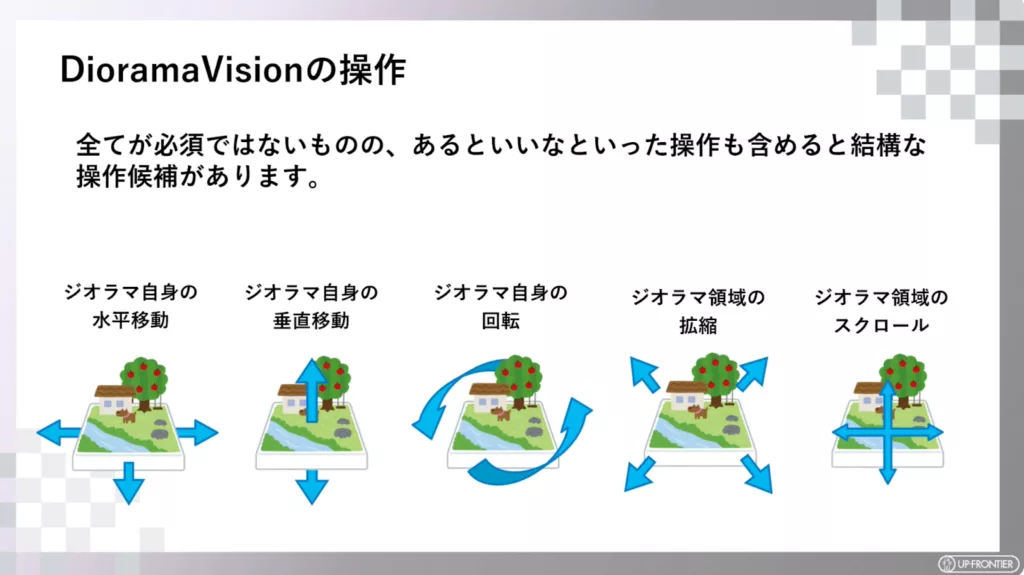

「ジオラマビジョンは、ジオラマ自身の水平移動や垂直移動など複数の操作候補があります。すべてを検証することは難しかったため、必要なものを割り当てて検証しました」(鬼村氏)。

「Magic Leap 2」での検証

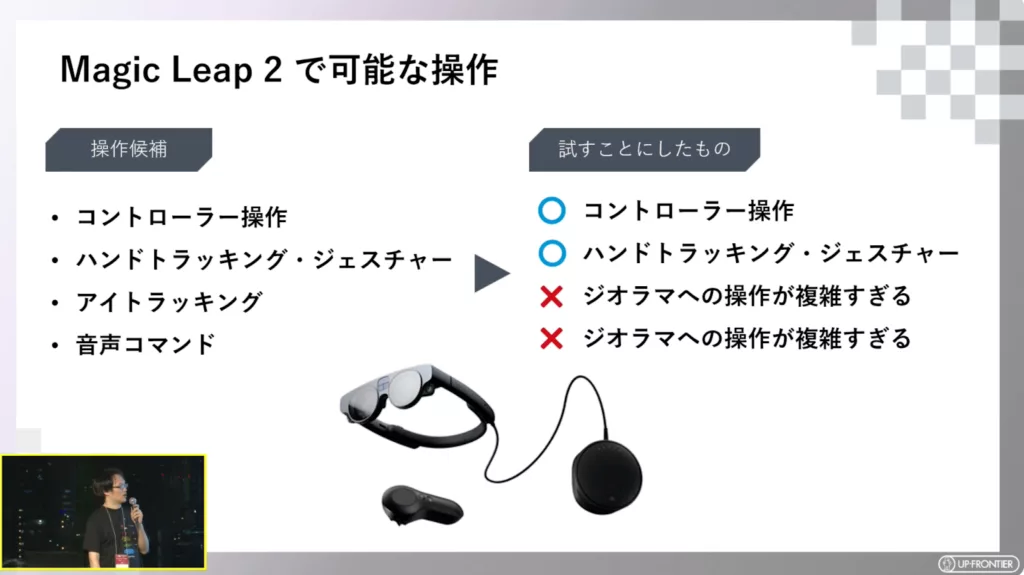

まずは「Magic Leap 2」での検証です。「Magic Leap 2」では、コントローラー操作、ハンドトラッキング・ハンドジェスチャー 、アイトラッキング、音声コマンドが操作候補になりました。

アイトラッキングと音声コマンドはジオラマへの操作が複雑になることから、検証を見送ったとのこと。「Vision Pro」への対応に向けて「アイトラッキングの検証は今後じっくり取り組んでいきたい」と鬼村氏は話しました。

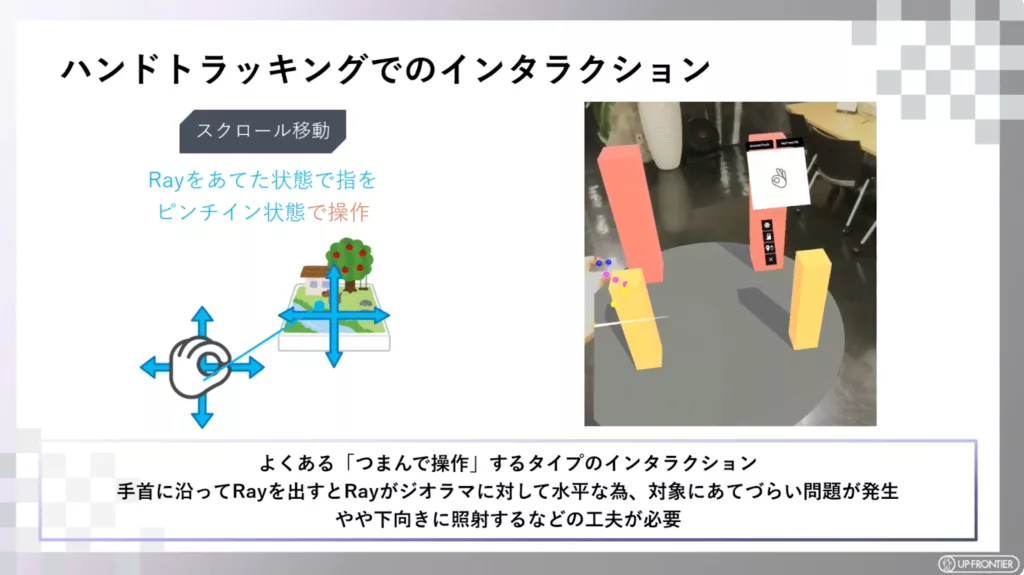

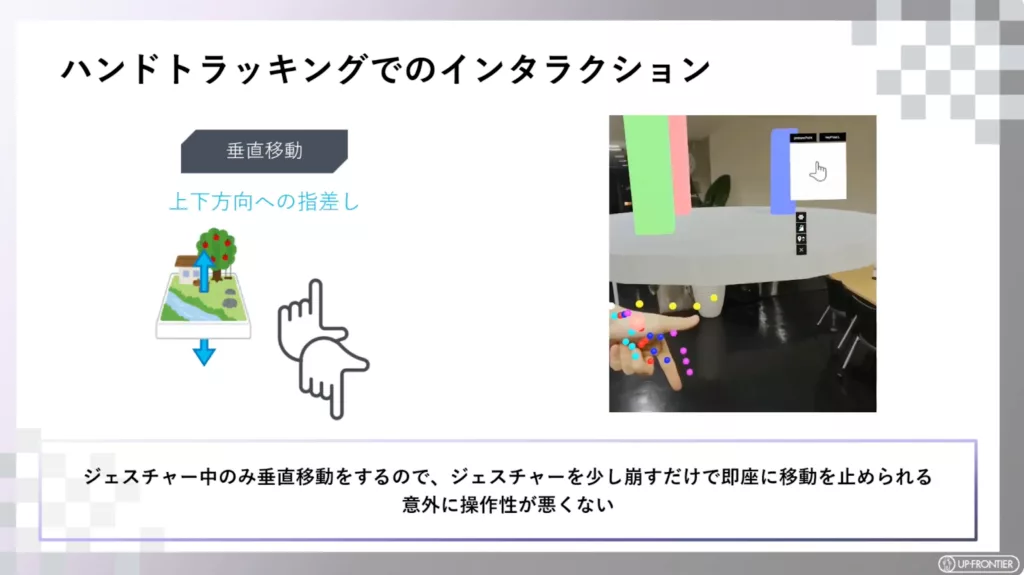

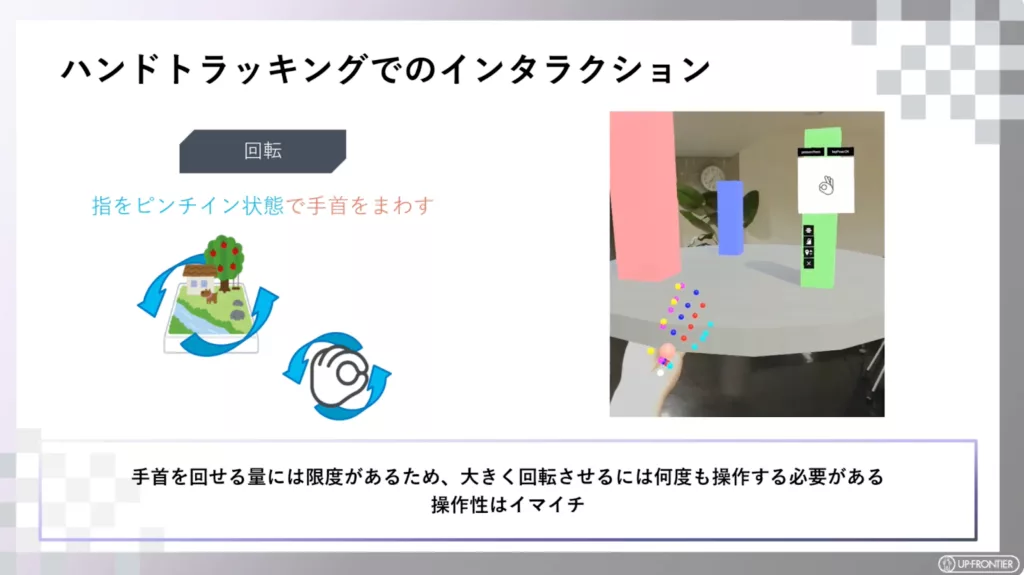

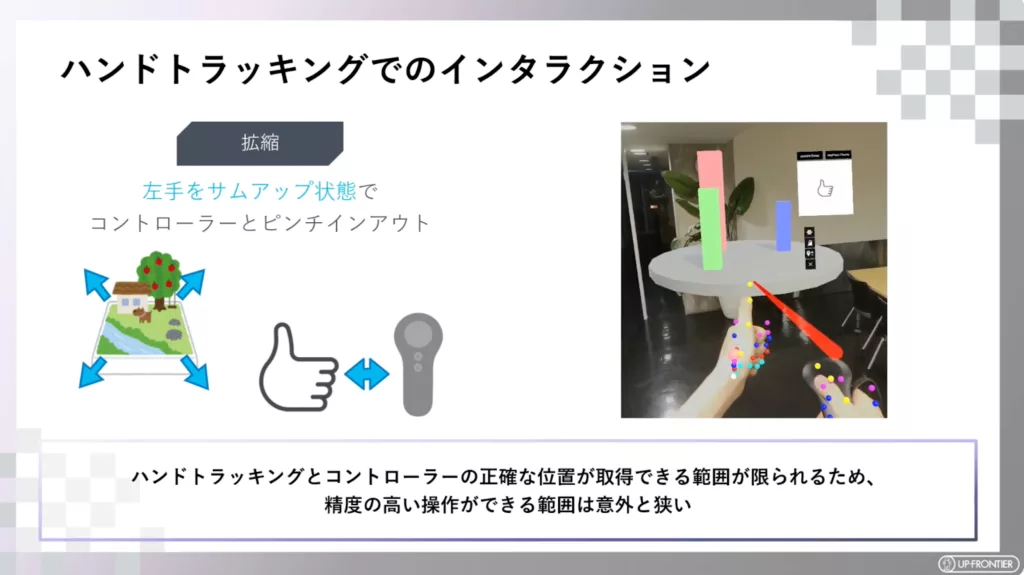

ハンドトラッキングでのインタラクションでは、スクロール移動、垂直移動、回転、拡縮を検証し、垂直移動以外は課題が残る結果となりました。

これらの結果を受けて鬼村氏は、「『Magic Leap 2』のハンドトラッキングはOSのアップデートごとに性能はあがっているが、他のデバイスと比較するとやや劣る。ハンドジェスチャーを切り替える際に手が動くため『手からRayを飛ばして操作』や『手の位置や傾きをもとに操作』をさせるジェスチャーは細かい操作がしづらい。また、視界に手が入るため体験を損ねる可能性がある」と評価しました。

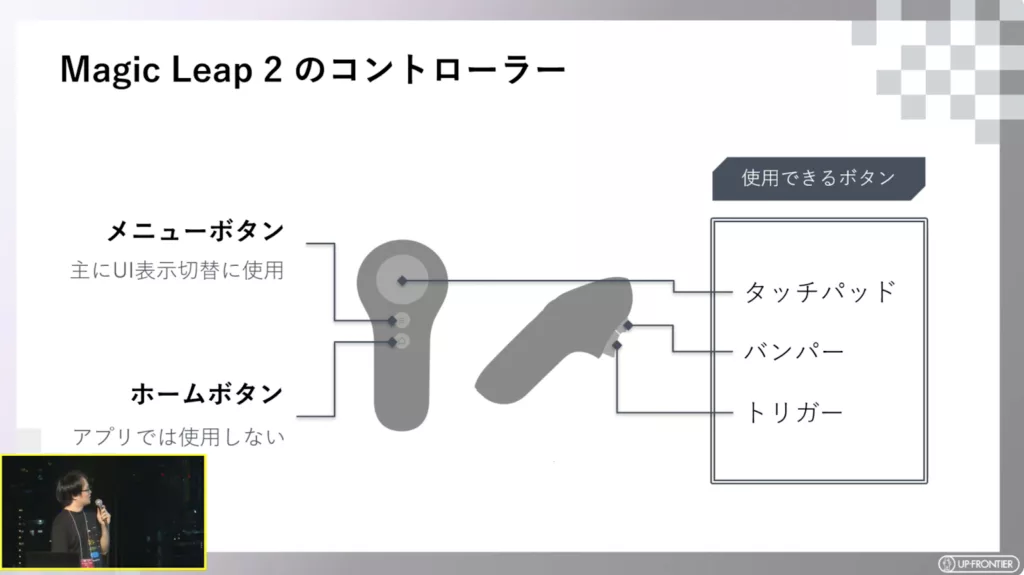

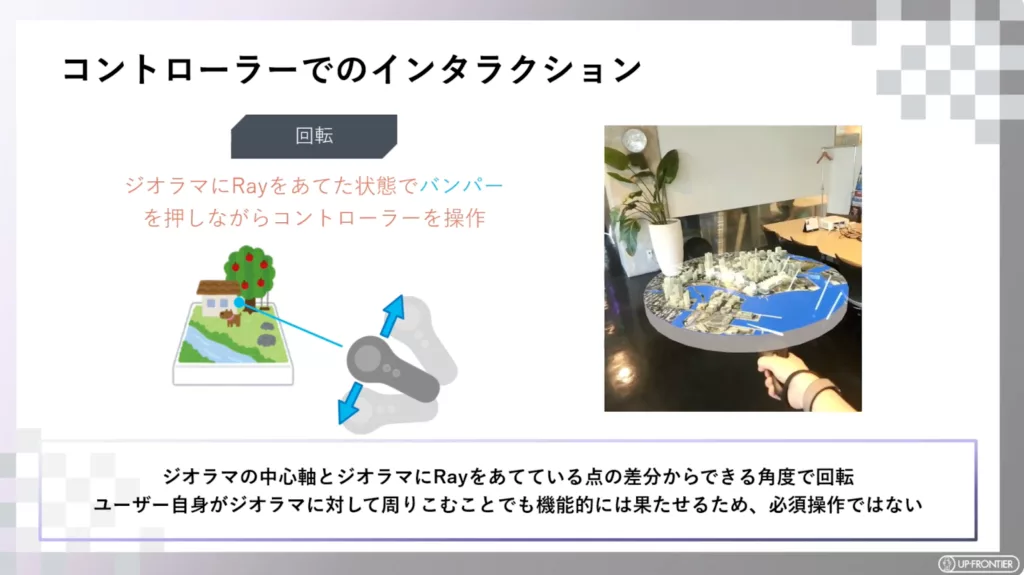

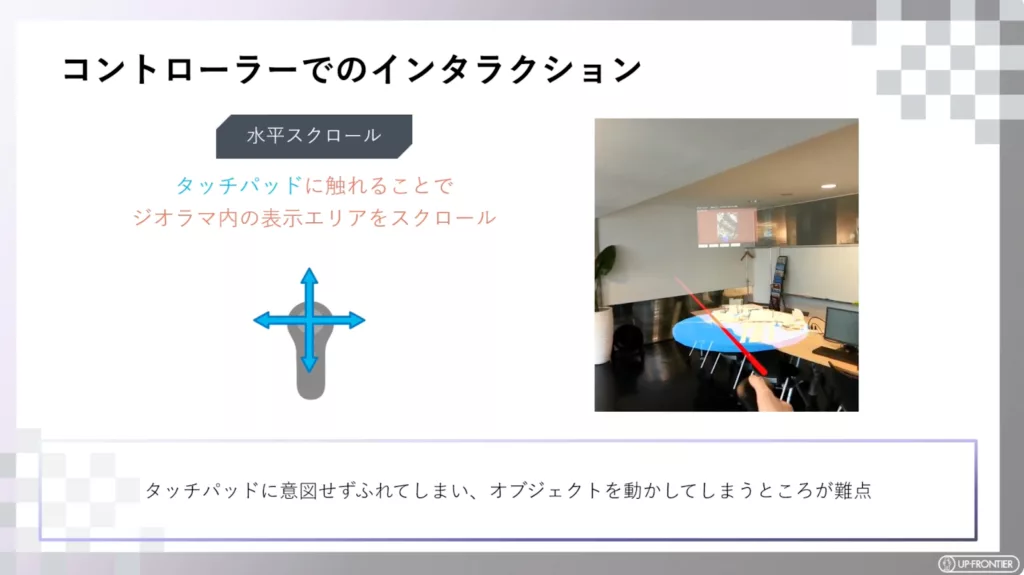

続いて、コントローラー操作でのインタラクションです。タッチパッド、バンパー、トリガーを使用可能なボタンと定め、検証をおこないました。

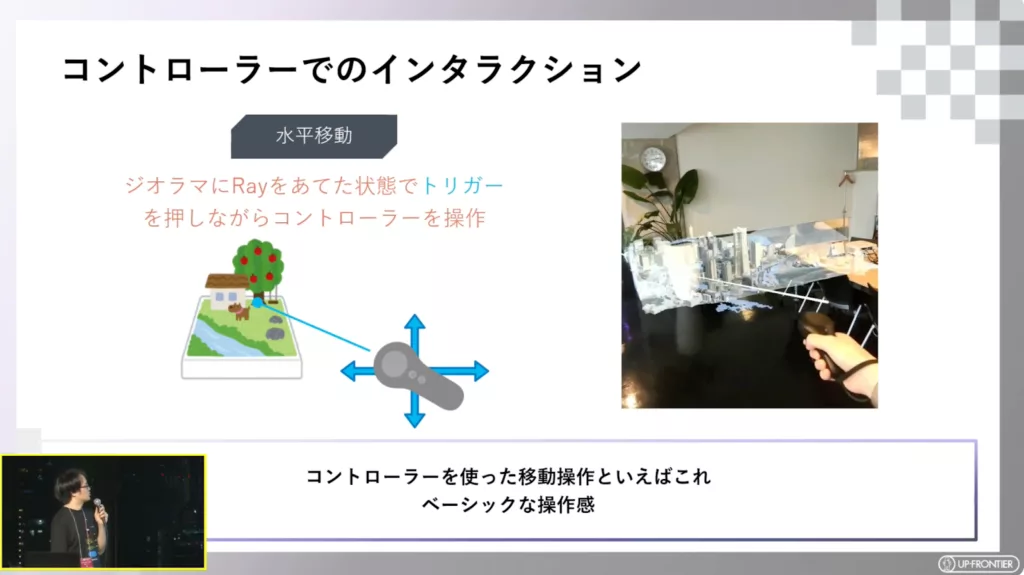

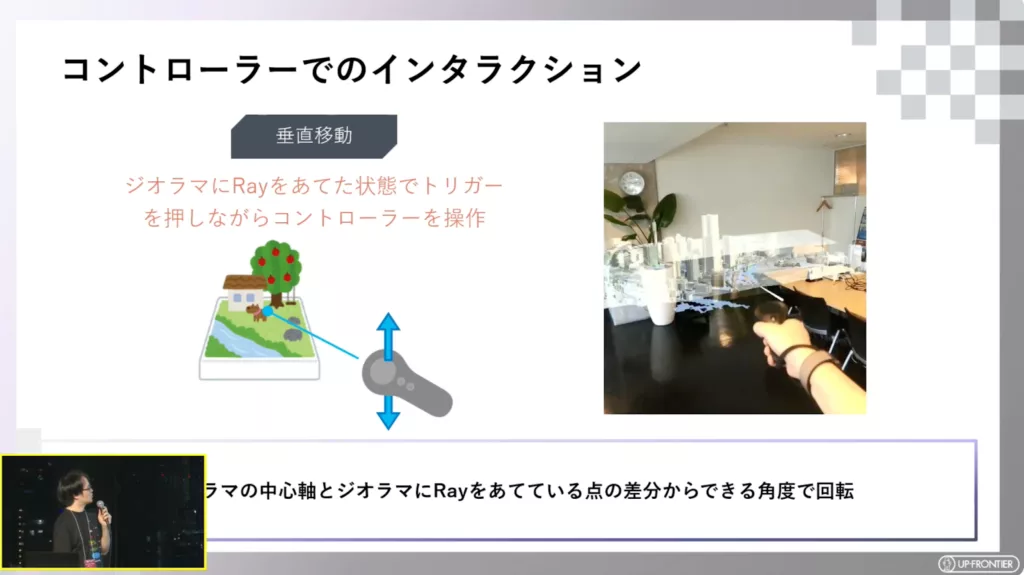

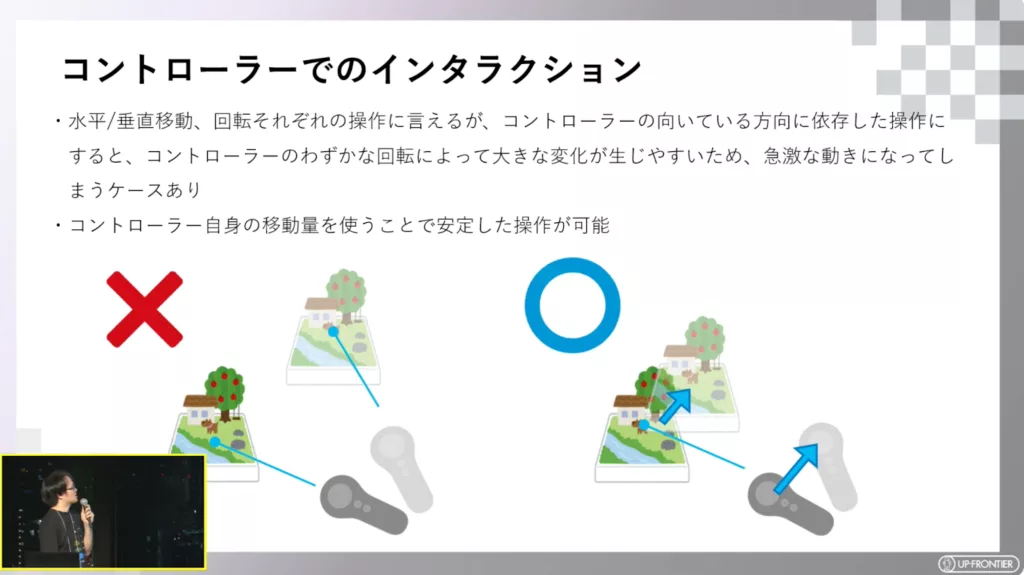

水平移動と垂直移動の検証結果から、コントローラーの向きではなくコントローラー自体の移動量を使うことで安定した操作を実現しました。

他にも、回転や水平スクロールも検証。水平スクロールでは、意図せずタッチパッドに触れてしまう点が課題として浮上しました。

これらの結果を受けて鬼村氏は、「ハンドトラッキングやハンドジェスチャーと異なり、コントローラーはグラスの視界に自身の手を収めなくても操作できるため、視界の確保や腕の負担の軽減という観点で大きなメリットになる。『Magic Leap 2』は複数のインタラクション候補があるが、オブジェクトへのインタラクションとしてはコントローラーのほうが使用感が良い」と結論づけました。

「ELF×Leap Motion」での検証

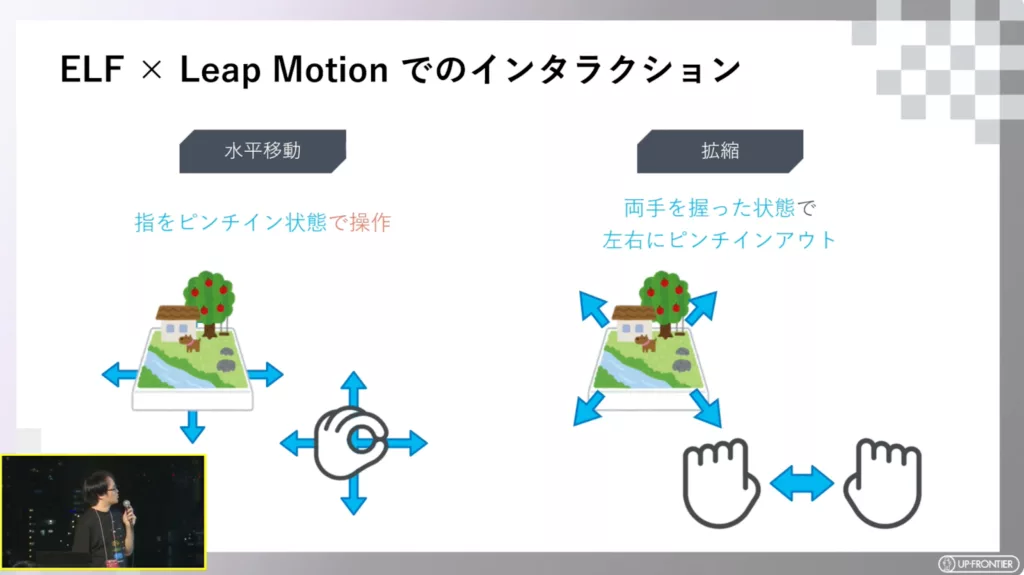

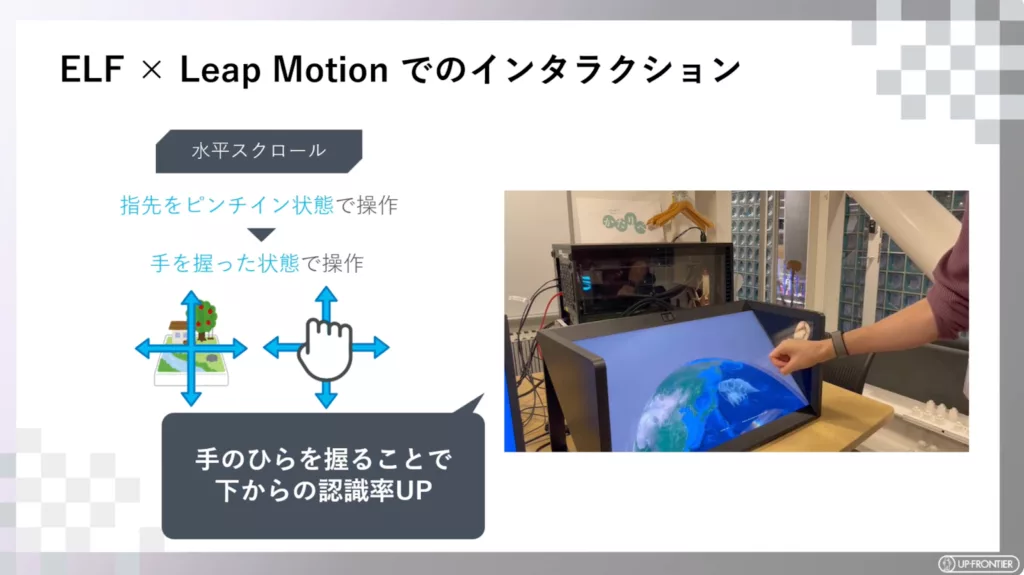

続いては、ソニーの空間再現ディスプレイ「ELF」シリーズと、Ultraleapのハンドトラッキングデバイス「Leap Motion Controller 2」でのインタラクションです。水平移動と拡縮を検証しました。

検証の結果、「Leap Motion Controller 2」を下に置いてピンチインアウトの操作をすると角度によって認識しづらくなることや、左右へのピンチインアウトでは手が認識範囲外となることが判明。水平スクロールでは、手のひらを握った状態での操作に変更することで下からの認識率を向上し、拡縮では左右ではなく上下の動きにすることで、手を認識範囲内に収めることに成功しました。

鬼村氏は「ELF×Leap Motion」の検証を終え、「Leap Motionでは、仮想空間上のジオラマに対し、実際の手の動きで干渉できるため没入感が非常に高かった。 今回試した操作は、ある程度の習熟度が必要だが、未来感を出しつつ操作性も保つことができたインタラクションになったのではないか」と語りました。

データの取り込みはPLATEAU SDK for Unityで

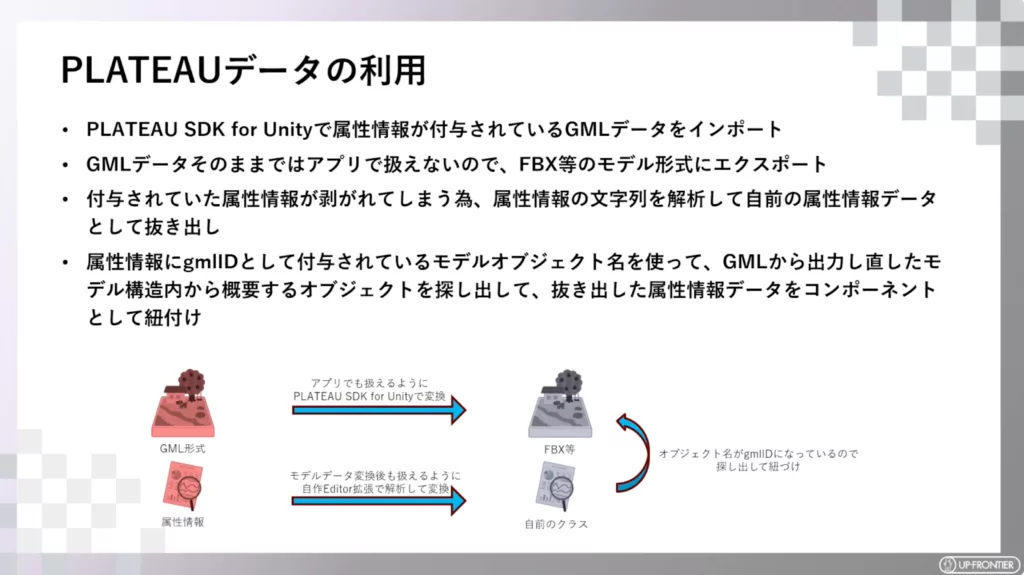

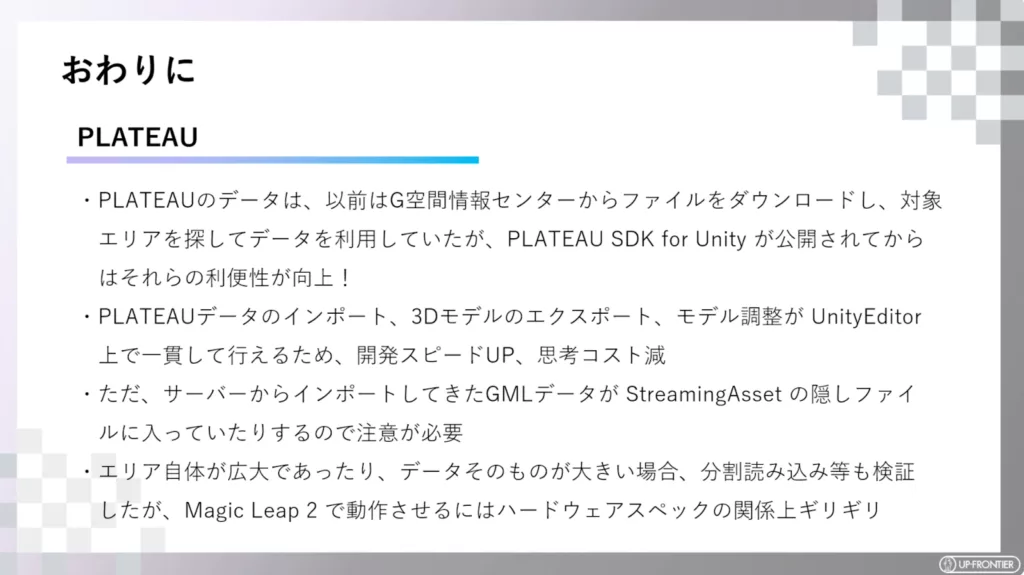

鬼村氏は最後に、プラトーのデータの取り込み方法について説明しました。PLATEAU SDK for Unityで取り込んだGMLの都市モデルには、「建築物」「都市計画区域」「区域区分」などの属性情報がstring型で付与されています。

GMLデータをFBX等のモデル形式にエクスポートする際に属性情報が失われてしまうため、独自の方法で属性情報データを復活させてFBX等と紐づけたといいます。

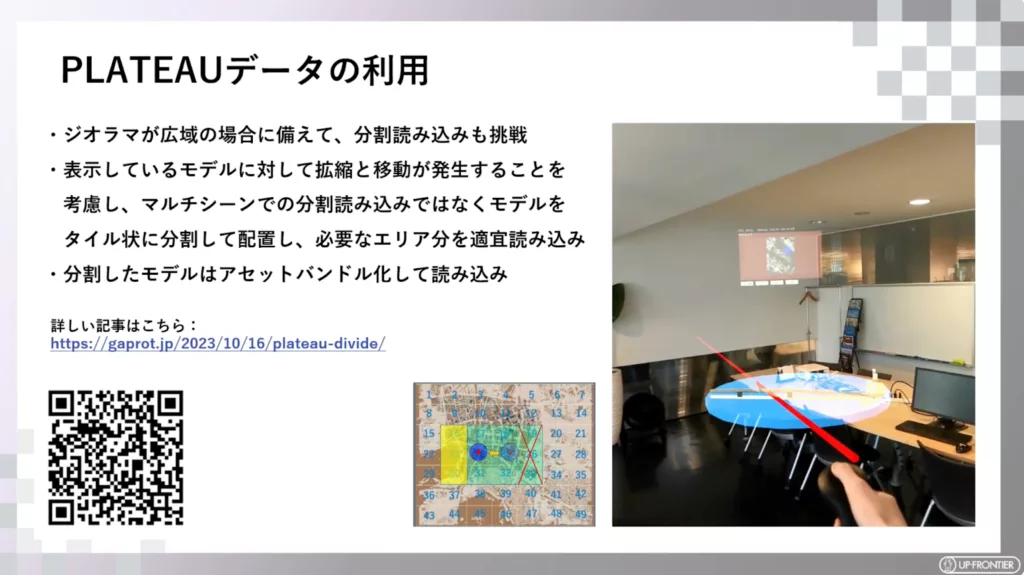

ジオラマが広域の場合に備えて、分割読み込みにも挑戦。表示しているモデルに対して、拡縮と移動が発生することを考慮し、 マルチシーンの分割読み込みではなく、モデルをタイル上に分割して配置し、必要なエリア分を適宜読み込みます。分割したモデルは、アセットバンドル化して読み込むことで軽量化を図りました。

検証でわかったこと

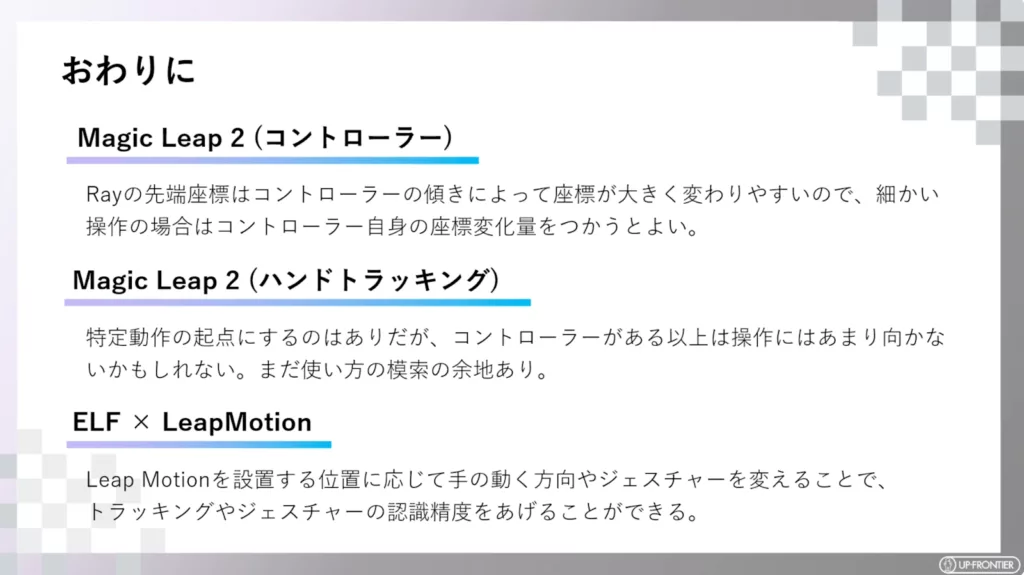

本セッションの締めくくりとして、奥村氏は各検証結果をまとめました。「Magic Leap 2」の操作性は、コントローラーに軍配が上がりました。「ELF×Leap Motion」の検証では、Leap Motionの設置位置に応じて、手の動く方法やジェスチャーを変えることで、トラッキングやジェスチャーの認識精度をあげることができるという結果が大きな収穫だったとのこと。

PLATEAUのデータの取り込みについては、「注意点はあるものの、PLATEAU SDK for Unityの登場により利便性が向上した。開発スピードが上がり思考コストが減少した」と語りました。分割したモデルは軽量化を図りましたが、「Magic Leap 2」のハードウェアのスペックでは動作がギリギリだったとのこと。

最後に鬼村氏は「アップフロンティアでは、最新のハードウェア・ソフトウェア研究を引き続き続けていきます。一緒に研究ができる仲間を募集していますので、ぜひお声がけください」と語り、セッションを締めくくりました。

【Sponsored】アップフロンティア