複数回にわたり、アメリカ・アナハイムで開催されたコンピュータグラフィックスとインタラクティブ技術の国際会議 ACM SIGGRAPH 2016 の情報をお送りしています。

例年のSIGGRAPHにおけるインタラクティブ技術の発表は、デモ展示を中心に大規模に行われます。Art Gallery や Studio そして VR Village 、企業による機器展示 Exhibition など、他の国際会議よりもデモを重視する文化があります。

今回の白井博士のVRおもしろ相談室は、発展途上の先端技術を扱うセッション「エマージングテクノロジーズ」(Emerging Technologies;以下E-Tech)での展示から、巨大ロボットと触覚、AR/MRを紹介します。

E-Techを分類する

こちらが SIGGRAPH2016 公式のティザー動画です。全部で24作品が採択されました。

SIGGRAPH 2016 – Emerging Technologies Trailer

もちろんティザー動画だけで体験なしではよくわかりません。そして “Emerging” とは「新興の、現出しつつある」と言った意味があります。「現在のVR技術の延長にはあるけれど、どう扱ったらよいかわからない」という技術分野でもあり、その意味や使い道を理解していく必要もあります。この連載では筆者の分類で以下の6つの分野で紹介していきたいと思います。

巨大ロボット

触覚

AR/MR

視覚工学

知覚心理

物理変換

今回は前半の3つを中心に紹介します。

(1) 巨大ロボット

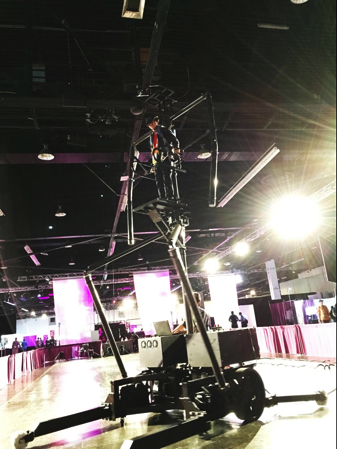

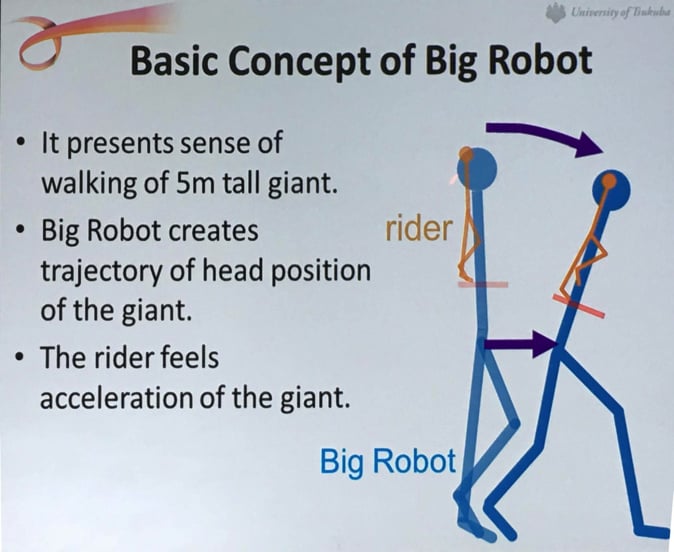

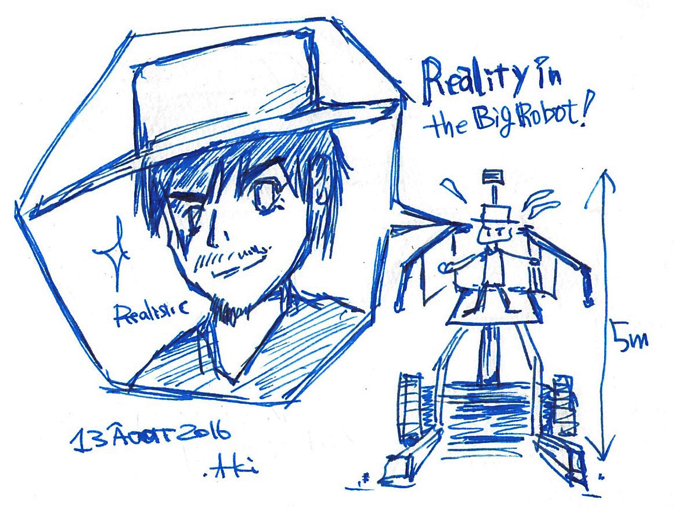

まず、今年のE-Techのシンボル展示的役割を果たした作品が、筑波大学 岩田研究室による「Big Robot Mk.1A」ではないかと思います。その名の通り「巨大ロボット」。体験者は高さ5メートルの高さまで登り、パイロットとして、自分の足の動きにより制御することができ、まさに「少年の夢、実現!」です。

<体験の様子。ARロボットがリアルタイム重畳表示される(本人は見えない)>

もともとはメディアアートプロジェクトだったそうですが、とにかくインパクトがあります。体験せずに横で見ているだけでも迫力があることは間違いないです。構造上、電源喪失しても落下するようにはできていないそうですが、万が一のために体験には同意書にサインする必要があります。

体験者はヘッドマウントディスプレイ(HMD)を装着しているように見えますが、これは安全のためのヘルメットです。HMDではありませんが、会場脇でARのロボットがリアルタイム重畳表示して「ツクバの白い悪魔」に乗っている世界観を描き出しています。

ちなみに体験者本人は必死なのでそこまで気にしていられません。操作感はどうだったか…というと正直なところ、簡単ではありませんでした!筆者は高所恐怖症ではないので、高いところは大丈夫なのですが、歩行させるためには「立ったまま片側の足を上げ6秒かけて歩行動作をする」という、まるでシン・ゴジラのような動きをする必要があり、かなり必死です。参考までにタイムラプスによる筆者の体験映像を紹介しておきます。

Big Robot Mk.1A experience in E-Tech 2016 time-lapse

https://www.youtube.com/watch?v=ugP02aJHDUA

岩田先生に伺ったところ、今回のE-Techでの展示は完璧な状態ではないらしく、実は米国への輸送中に重心動揺装置の一部が破損してしまい「体験者が傾かない状態」で歩いているそうです。もし完璧に動いていたら、さらに難度が上がるような気もしますが、没入感や一体感は上がりそうです。

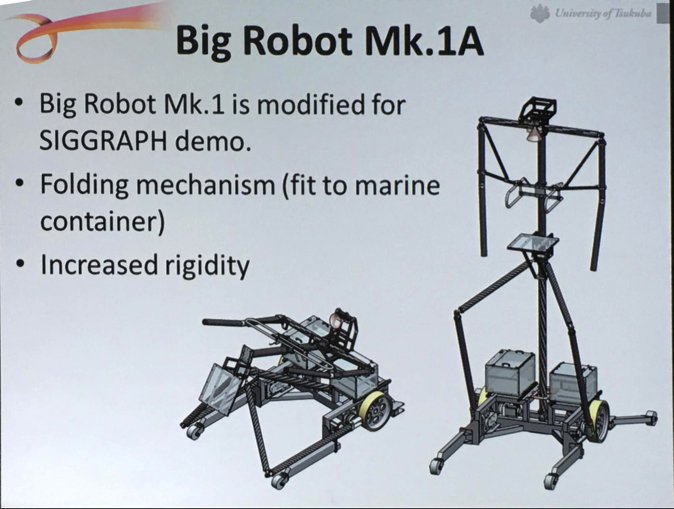

<岩田先生による、技術詳細プレゼン資料>

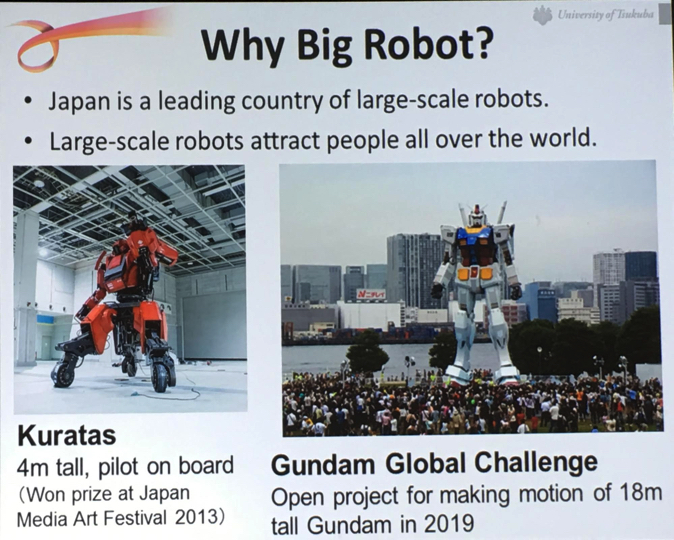

このプロジェクトはどのような意味を持っているのでしょうか? 日本はそもそも巨大ロボットの先進国であり、すでに水道橋重工「Kuratas」(4メートル高)や、2019年を目標とした「ガンダム・グローバル・チャレンジ」といったプロジェクトがあり、メディアートの世界では評価が高いのです。さらにこのような巨大ロボットは一般に目を引きます。お台場のガンダム像が良い例で、まさにシンボルです。

Big Robot はそのような背景で、筑波大学 エンパワーメント情報学プログラムのハンガーで生まれました。リンツのアルスエレクトロニカに向けて準備され、現地での展示は話題になりました。しかしこの頃はまだ一般の体験者が搭乗できる状態ではなかったそうです。つくば市内での展示などを通して、体験可能な状態になり、さらに今回のSIGGRAPHでの展示に向けて、輸送コンテナに搭載できる変形メカニズムを取り入れ、5m高になり、実現しています。動画は大学内ハンガーでの組み立ての様子です。操縦者が乗る支柱を立てる作業が最も危険そうです。

Big Robot Mk.1A, presentation video by Prof. Iwata

https://www.youtube.com/watch?v=5VJXQBGEGoU

そして現在もこの Big Robot Mk.1A の改良は続けられております。なお2016年9月14〜16日に開催される第21回日本VR学会大会(つくばにて開催)のテクニカルツアーでは身長8メートルの Big Robot Mk.2 が体験できるかもしれない、とのお話でした。今後、HMDを被ったり、リモート操作したりと、さらに没入感の高い巨大ロボット操作ができる時代もすぐにやってくる感じがします。大変スケールが大きい研究です。まさに「巨大ロボット系研究」と呼ぶべき一つのVR研究分野がここに突然として誕生しました。

(2)触覚

触覚技術はSIGGRAPHにおいても大いに期待されるインタラクティブ技術です。

Oculusの研究成果に直接触れる

HMDの先進企業であるOculus Research Labsによる「HapticWave: Directional Surface Vibrations Using Wave-Field Synthesis」は円形の薄板に複数の振動子と波面合成の物理により、方向性のある振動触覚の提示をデモしました。

筆者も昔は方向性のある振動触覚を研究していたのですが、体験してみて感じることは、昔と違って、「高品位なHMDと完全な位置合わせが融合すると、ある程度の波面合成でも多様な表現ができるものだな」、という感想を持ちました。またこのプロジェクトはカリフォルニア州立大とOculusのコラボレーションで成立しており、担当のRiccardo DeSalvo先生は宇宙物理学、重力波の研究バックグラウンドを持っていらっしゃいました。

余談ですが、SIGGRAPH会場ではOculusの研究体制作りを進める活発な動きが感じられました。この業界の企業研究所の王道なのですが、活きの良い大学院生や研究室を丸ごと産学連携や高待遇のインターンシップ等で協力体制におき、秋から1月ごろまでのSIGGRAPH投稿シーズンまでに挑戦的な期間限定プロジェクトをこなしていきます。来年はまたすごいものが見れるかもしれませんね。

梶本研究室は触覚の並列化に挑戦

今回のETechにおいて「HALUX: デジタルスポーツのためのプロジェクションベースのインタラクティブ肌」 、「HapTONE: 豊かな音楽演奏のための触覚楽器」、そして「FinGAR: 高忠実度触覚提示のための電気的および機械的刺激の組み合わせ」(邦題は筆者による)と、同時に3つの触覚系デモが採択された電通大(電気通信大学)梶本研究室ですが、ちょっとした新しい特徴を感じました。従来、触覚ディスプレイといえば、皮膚の表面を刺激するためにたくさんのアクチュエータを使い、大きめのリンク機構や、中央制御的な構造を構築するデバイスが多く存在したのですが、今回の触覚デモは3つとも、分散的なアクチュエータで複雑な触覚を表現している点が特徴といえます。

ピアノ用鍵盤にアクチュエータを埋め込んだ「HapTONE」、まずは公式動画がよくできているのでそちらをご覧ください。「豊かな音楽演奏のための触覚楽器」と銘打っている部分ですが、鍵盤内部に埋め込んだアクチュエータとセンサによって、材質や音の性質を触覚とともに変化させることができます。デモでは木琴や鉄琴といった模様を鍵盤にプロジェクションマッピングして、その触り心地をその材質に合わせています。

HapTONE, experience

https://www.youtube.com/watch?v=ba0xfzDsCw4

デモでは8鍵しかありませんが、構造的には白鍵に完全に収まっているので、アクチュエータを完全並列させてフルキーボードを作ることはできそうです。

「HALUX」はプロジェクタによるHMD装着者への触覚信号の投影に挑戦しています。

HALUX, experience

https://www.youtube.com/watch?v=IoXTrx19URA

HMD装着した人間はプロジェクタの光は見えませんので、逆転の発想です。全身や腕全体といった広い面積に細かい触覚を提示するためには、振動子ごとにコントローラーや電源に結線せねばならず、結構簡単に壊れてしまいます。この方法であれば、それぞれの振動子は独立で動きますので電源だけです。デジタルスポーツへの応用、ということを銘打っていますが、少なくとも梶本研究室卒業生の過去のIVRC学生作品「虫 How?」もこれで作れるということになりますね。

最後に「FinGAR」は、指一本に対しての多様な触覚表現について注目しています。人間の触覚における生理的なセンサーは、マイスナー小体、メルケル細胞、パチニ小体、ルフィニ終末と4種類あり、それぞれ周波数や応答速度、皮膚の深層、表現できる感覚が異なります。FinGARは電気的および機械的刺激の組み合わせによって、マイスナー小体とメルケル細胞には電気刺激、パチニ小体とルフィニ終末には小型モータによる回転刺激を使って表現するという試みです。SIGGRAPH期間中は大変人気だったので、「どんな触感になるのか?」は結局実際に試すことができなかったので、機会を見つけて電通大梶本研究室に取材してこようと思います。公式動画をご参考ください。

FinGAR: Combination of Electrical and Mechanical Stimulation for High-Fidelity Tactile Presentation

https://www.youtube.com/watch?v=kB_uMeDtIk8

(3) AR/MR

AR/MRに分類できる展示は24件中7件あり、最も多く分類できる分野とも言えます。多くのデモが「〜したい」という希望を実現する、「ドラえもんのひみつ道具」的な世界観を持った展示でした。

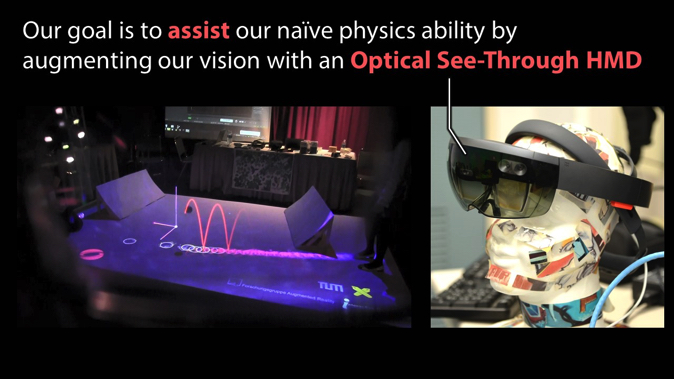

投げたボールの未来を見たい

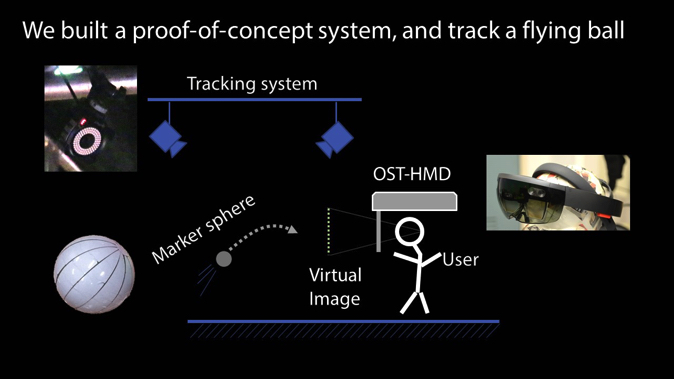

慶應義塾大・大阪大・ミュンヘン工科大による「Laplacian Vision: Augmenting Motion Prediction via Optical See-Through Head-Mounted Displays and Projectors」は、ARによる実物体の運動予測で、高速トラッキングと運動予測による跳ねる実ボールの軌跡を光学シースルーHMD(HoloLens)とプロジェクターを利用してリアルタイム可視化する取り組みででした。

本展示を開発した伊藤勇太先生は、東京工業大学修士卒業後、東芝、ミュンヘン工科大学で博士課程研究員、現在は慶應義塾大学特任助教という経歴を持つ、光学シースルー頭部搭載型ディスプレイ(OST-HMD)の研究者です。Laplacian Visionとは「ラプラスの悪魔」と呼ばれる言説をARで具現化したものです。伊藤先生からプレゼン資料をご提供いただきましたので紹介します(プロジェクトのホームページ)。

ちょうど期間中に「ポケモンGO」が公開されたこともあり、「ARでボールを投げる、はずむ」という「子供じみた物理(Naïve Physics)」をリアルタイムでHoloLensを通して見るインパクトは大きく、反響も大きかったです。早くHoloLensが日本で使える日が来て欲しいと強く思いました。

Laplacian Vision、体験の様子

http://www.youtube.com/watch?v=E6vsb-zEEYI

遠くのオフィスと自然にコラボしたい

東京大学 舘研究室の「Layered Telepresence: Simultaneous Multi-Presence Experience Using Eye-Gaze-Based Perceptual Awareness Blending」は、複数のリモートロボットによるテレビ会議において、視線入力可能なHMDを使って、VR空間内に会議参加者をオーバーレイ表示してシームレスに繋ぐことで、距離を超越する試みです。

Layered Telepresence,SIGGRAPH2016 E-Tech

http://www.youtube.com/watch?v=_Jzg6nP_vRE

映像中の会話に出てくる「the Office of the Future」とはHenry Fuchs, Ramesh Raskarらによって1998年ごろに提案された有名な研究で、未来の職場環境のための基盤技術研究です。特に Andrei State の描いたスケッチには、遠く離れて時差のある職場環境においてコラボレーションする様子が想像図として描かれています。

Rameshらの研究では自由な空間にプロジェクションを用いてディスプレイを構成するAR技術が多く提案され、その後のプロジェクションマッピングの火付け役にもなりました。

Layered TelepresenceはそのARによる協働を、小型のLinux系のリアルタイムOSで構築されたリモートロボットと、HMDを用いて実現したものと表現できます。

剛速球を投げつけられたい

NTT研究所による「VR Technologies for Rich Sports Experiences」は、今年1月にNTT R&Dフォーラムで公開された技術デモから、特にスポーツに関連する技術が複数点展示されていました。特に目を引いたのは選手強化のための実写ベースVRによるデモで、体験者は野球のバッターボックスに立ち、任意の投球の選択をすることができます。

バッターボックスからの視点

https://www.youtube.com/watch?v=6DioO_NAMAc

実写ベースVRでビーンボールや苦手な球種などを体験できる面白さがあります。選手の強化にも使えるという期待があるそうです。

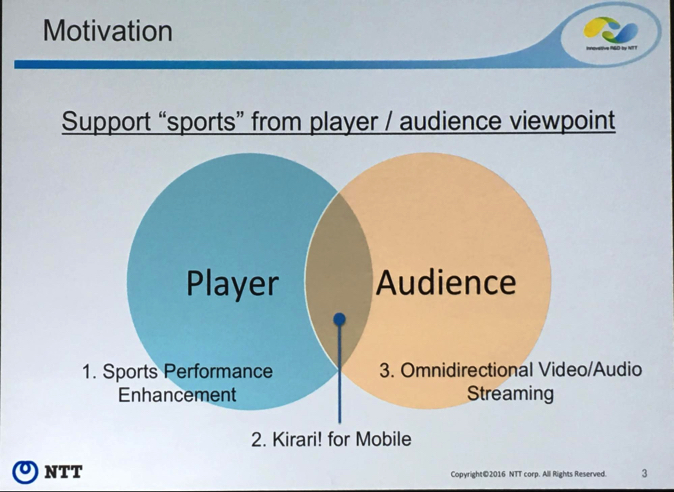

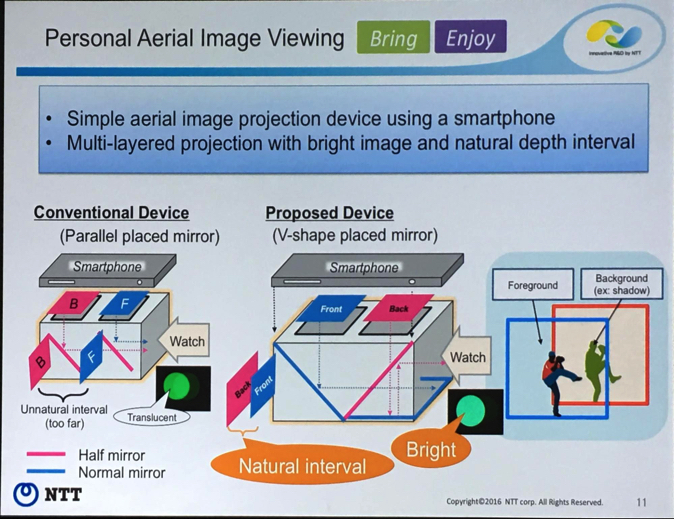

同じブースでもう一つ、Kirari! for Mobileの展示も行っていました。技術プレゼン時にNTT研究開発としての戦略と位置づけ、光学系についての紹介も行われていましたので紹介します。

「NTTによるVRスポーツ」とは、VR技術によるリッチなスポーツ体験であり、選手向けには「スポーツパフォーマンスの強化」、観衆向けには「多視点映像音声のストリーミング」があり、その集合部分に「Kirari! for Mobile」があると説明されています。

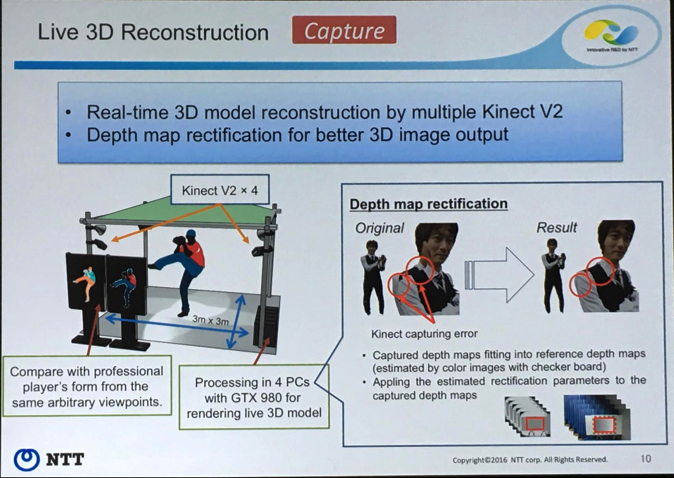

まずLive 3Dの撮影系として、投手の投球モーションの撮影は、Kinect V2を2台でリアルタイム生成しています。より良い画質の3D映像出力のために奥行きマップによる補正(recticication)を行っています。

Kirari! for Mobileはペッパーズゴースト風の2層空中像をスマホで表示できる技術ですが、スマホでの自然な奥行き感の維持と、工学系の構成に工夫があります。まず、ミラーは前側映像をミラーし、後ろ側映像を半透明ミラーで一旦透過したのちにミラーで反射します。前後像の位置関係が逆になっていて、「前側が透けない・明るい・折りたためる」という特徴を持ちます。なおKirari! for Mobileスマホアプリビューワーは配布されており各ストアから入手可能です(iPhone/Android)。

あの人を自由に喋らせたい

スタンフォード大「Demo of Face2Face: Real-Time Face Capture and Reenactment of RGB Videos」。Face2Faceは以下の動画が大変有名になったので、見たことがある人もいるかもしれません。

Face2Face: Real-time Face Capture and Reenactment of RGB Videos (CVPR 2016 Oral)

https://www.youtube.com/watch?v=ohmajJTcpNk

実際にこのデモを試すことができるのか!と喜んでやって見たのですが…どうやら筆者のヒゲは不可能とのことで、微グロ映像が生成されましたので、代わりに隣にいた女性によるシュワルツェネッガーさん風映像を紹介します。

Demo of Face2Face

http://www.youtube.com/watch?v=lBSFKSpwMQo

デモ開始後の非常に短いセットアップ時間(数秒)で、テクスチャマップの取得、ジオメトリ、口や目などの特徴データベースの取得を普通のRGBカメラから行っています。RGB画像から行っているということは、YouTube等の動画でも適用可能ということで、シュワルツェネッガーさんの首や表情、発言を自分の口でアテレコすることができます。

下にずらっと並んでいるのが口の表情データベースです。政治家の画像を置き換えるという応用はセンセーショナルですが、他にもMR、特に映画業界でのプレビズや放送業界など様々な使い道がありそうです。プロジェクトのホームページはこちらです(Matthias Nießner)。

後半に続く!

SIGGRAPHでも最も体験する価値があるエマージングテクノロジーの世界、いかがでしたか? 今回は巨大ロボットに始まり、触覚技術、そしてARとMRにつながる近未来のVRの可能性に関連付けて紹介させていただきました。長くなってしまいましたので、続きの(4)視覚工学、(5)知覚心理、(6)物理変換については次回に持ち越したいと思います。

<告知>

8/23にSIGGRAPH報告会を行います。平日で有料ですがご興味ありましたらどうぞ。

http://eventdots.jp/event/596833