Metaは2月24日(アメリカ太平洋時間)、同社の研究開発部門に関する情報公開イベント「Inside the Lab」を開催した。同イベントは主にメディア関係者に向けて定期的に開催されているものだが、今回で3回目。テーマは「メタバース構築におけるAIに関する取り組み」だ。

とはいえ、内容は多岐に渡り、より一般的なAIに関する内容も含まれる。今回は特に、本誌のテーマであるメタバース・XRに関わる部分をピックアップしてご紹介したい。

なお、イベントの動画は以下のFacebookページから見ることができる。ただし2時間30分にわたる長い動画であり、英語のみでの提供なので、その点はご留意を。

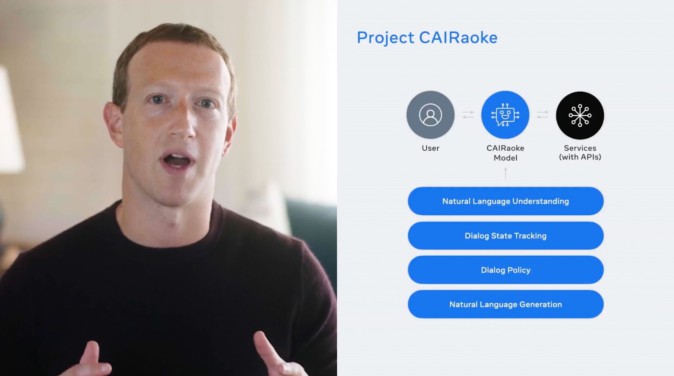

メタバース用AIアシスタント「Project CAIRaoke」とは何か

「メタバース実現のためには、新しいハードウェアデバイスから、世界を構築し探索するためのソフトウェアまで、あらゆる分野の進歩が必要です。そして、これらの多くを実現するカギとなるのが、AIの進化です」

Metaのマーク・ザッカーバーグCEOは、イベント冒頭でそう述べた。メタバースのような空間の中では、タッチ・マウス・キーボードのような既存のUIが使いづらい。移動できる空間が広がり、できることの幅も広がる可能性が高いが、我々が操作上できることには限界も多く、メタバースの可能性を生かすことは難しい。そこでMetaが取り組んでいるのは「メタバース世代のための新しいAIアシスタント」の開発だ。

「仮想世界と、拡張現実による物理世界のナビゲーションを支援するAIが必要になるでしょう。これらの世界はダイナミックで常に変化するため、AIは人間が行うように文脈を理解し、学習することができるようになる必要があります」

ザッカーバーグCEOはそう答える。

そのために彼らが取り組んでいるのが「Project CAIRaoke」だ(この発音は筆者には英語の「Karaoke(kɑ`ːrəóuki )」とほぼ同じに聞こえたので、当然意識していそうだ)。

(Project CAIRaokeの概要説明。動画はYouTubeで視聴できる)

AIアシスタントとしての技術の詳細は省くが、Project CAIRaokeはスクリプトによるシナリオベースでの解答ではなく、文脈を読みつつパーソナライズされた受け答えの実現を目指す。そのためには音声認識後の文章をどう把握するのか、という点で大幅な進化が必要になる。

そしてそれだけでなく、将来的にProject CAIRaokeは現状のAIアシスタントのような「声で命令を与える」ことだけを前提としたものではない世界を目指す。それが「メタバースのためのアシスタント」としての要素だ。

ARやVRは「一人称視点である」という特徴がある。それに加え、位置情報なども活用する。声での命令に加え、どこにいるのか、なにを見ているのか、といった情報を加味することで、自分がやっていること、これからやろうとすることなどに合わせた行動のアシストを目指している。

説明の中では、特にARでの活用例が目立った。例えば料理中に何を入れるべきか、どう切るべきかなどを指示されるイメージ映像が流れたが、これはAIが「何の料理をしているか」「今目の前で扱っているものはなにか」を認識した上で指示を行った例である。

(Project CAIRaokeで実現するAIのイメージ。手にしているのがハラペーニョだと認識した上で、家族の好みの調理法まで教えてくれる)

モード切り替えもなく、複数のメディアを活用し、AR上のナビゲーションアシスタントを目指す、という方向性がよくわかる。

「Builder Bot」による「音声でのメタバース構築」

音声アシスタントによるメタバースでの操作改善の可能性の一つとしてデモンストレーションされたのが、「音声によるメタバースの構築」だ。「Builder Bot」と名付けられたこの機能は、Project CAIRaokeの存在を前提としたものだ。

デモでは、ザッカーバーグCEOが声で「海辺に行ってみよう」「雲を追加して」「テーブルやラジオを置こう」と話しかけると、仮想空間内にオブジェクトが配置され、彼らが考えている空間が出来上がっていく。

(「Builder Bot」を使い、音声で命令して好みの仮想空間を作っていく)

(「Builder Bot」のデモ動画)

もちろん、これはデモに過ぎない。どこまで自由に、自分の意に沿ったものが作れるのかはわからないところがある。とはいうものの、気軽にその場で空間を作って、仕事やプライベートに活かせるとすれば、そこには大きな可能性が生まれる。

メタバースで利用する空間を自分で作るのは一般的な話だが、3D空間内にオブジェクトを思うように配置し、快適な空間を作るのは意外と大変なことだ。それを声だけで、ニュアンスを汲み取って行えるなら確かに便利になる。

しかも前述のように、Project CAIRaokeではそこから文脈を読み取って活動のサポートをするのが目的だ。そうした使い方の移行がスムーズかつ快適にできるようになるなら、大きな変化である。

現在は「リサーチ」目的、オープンな開発とプライバシーがみんなのメタバースを生み出す

では、これらの機能は、いつ私たちが使えるようになるのだろうか?

実は、「製品に実装されるタイミング」についてのアナウンスはなかった。発表後、プレス関係者でMetaのAIマネージングディレクター、Joelle Pineau氏に対するグループインタビューにおいて、彼女は以下のように答えている。

(MetaのAIマネージングディレクターであるJoelle Pineau氏)

「今回発表したものは、すべて『リサーチ』段階のものです。しかしそれらはオープンな科学プロジェクトの論文として、コードとして、誰もがアクセス可能です。Facebook AIのページや、GitHubから参照していただけます。ただ、実際の製品で利用できるようになるには、まだ時間がかかると思います」

(Meta AIのページでは、今回の動画だけでなく、各種情報へのリンクなども公開されている)

今回のイベントにおいてポイントだったのは、彼女も指摘した「科学としてのオープン性」だ。大手IT企業のリサーチプロジェクトというと「それが使われる製品」の話が気になるが、実際には基礎研究的なものも多く、Meta AIとして今回公表したのは、科学的プロジェクトである、という扱いである。そうした技術と知見を、ある部分で音声エージェントやメタバース向けアシスタントの基礎技術としていくことで、メタバース全体の進化と活性化を狙っている。

ザッカーバーグCEOはその点について、こう説明している。

「私たちは長期的な目標に突き動かされています。私たちが今日、このメタバースの仕事をできるのは、ほぼ10年前に始めた、AIとバーチャルリアリティへの長期的な投資のおかげです。そして、私たちが今見ているAIの躍進は、私たちの研究所が初期に行った、自己教師付き学習への長期的な投資のおかげです。私たちはオープンで責任ある開発を行うことを約束します。この道のりを進んでいければ、私たち全員にとって、より良い、より安全なオンライン環境を構築する機会が得られます」

当然、こうしたAIには「責任」がつきまとう。ユーザーのパーソナルデータを活用することになるわけで、現在のウェブとSNS以上にセンシティブな部分が出てくる。

「こうした道のりを進むことは、最高レベルのプライバシーを提供し、被害を防ぐのに役立つAI技術を生み出すことを意味します。人権・公民権・障がい者の権利、そしてプライバシーの専門家と協力し、公平性・尊敬・人間の尊厳に基づいたシステムを構築することも意味します。そして、オープンに仕事をし、進捗を共有し、世界中の人々が自分たちの未来のビジョンを実現するためのツールやテクノロジーにアクセスできるよう、みんなのためにメタバースを構築することを意味します」

(Meta AIの活動を意義を、ザッカーバーグCEOは4つの観点で解説)

このような話は、同社に寄せられる「独占」批判を避ける目的……と穿った見方をすることもできる。

だが事実、理想的なメタバースを構築するための技術は発展途上であり、そのための技術的・科学的ビルディングブロックは多数必要だ。メタバースの進化に賭けているMetaとしては、メタバースが広がる可能性が高くなることが重要であり、Meta AIの活動もその一環、と見ることができるだろう。