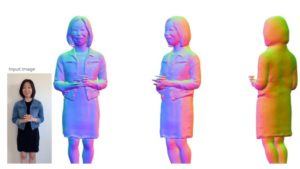

Googleは、1枚の2D画像から3Dモデルを生成するという研究成果を発表しました。対象1点につき1枚の画像のみを使い、一度の学習で完結させる点が特徴です。

使うのは1枚の画像のみ

Googleが用いるのは、「LOLNeRF」と名づけた3Dモデル生成プロセスです。その特徴は、ある1つの視点から見た1枚の2D画像のみから3Dモデルを推定し、構築できるという点。Googleは次のように説明しています。

「“LOLNeRF: Learn from One Look”の中で、我々は(対象につき)1枚のイメージ画像を集めたものから、3Dの構造や見た目のモデリングを学習できる、フレームワークを提案しています。“LOLNeRFは車、人の顔、猫といったものの集まりから、その特徴を抽出した3D構造を学習できるのです。対象のオブジェクト1つにつき、1枚の画像しか必要ありません。同じオブジェクトを2回学習させることは不要です」

この手法では機械学習を利用して、2D画像の複数のポイントから3D空間各地点の色彩や濃度を推定。より正確かつ、多面的に見られる3Dビジュアルを生成しています。

3Dモデル生成を容易に? 様々な企業が先を競う

公開された画像を見る限りでは、元の2Dイメージの視点から大きく外れたモデル背面などは生成されていません。しかしこの手法が確立すれば、現実にある物体の3Dモデル化の負荷を、大幅に減らすことができます。つまりは、大量の3Dモデルを必要とするメタバースなどバーチャル空間の構築を加速できる可能性を持つ、ということです。

2Dコンテンツから3Dデータを生成するプロセスは、これまでにも複数の企業が研究成果を発表しています。しかし2022年9月現在も確立した手法はなく、今後も進展が期待される分野です。