HTC NIPPON株式会社は、2018年12月3日に開発者向けカンファレンスイベント「VIVE JAPAN デベロッパー ミートアップ 2018」を開催しました。本イベントのロケーションベースVRセッションにて「VRの今後」というタイトルで登壇したのは、ティフォン株式会社CTOの中橋英通氏。現在、台場や渋谷で展開されているMRシアター 「ティフォニウム(TYFFONIUM)」でのコンテンツにおけるMR技術やCGの表現に関する解説が行われました。本稿ではその様子をレポートします。また、本講演の全編を収録した動画はこちらから。

「ティフォニウム」とは

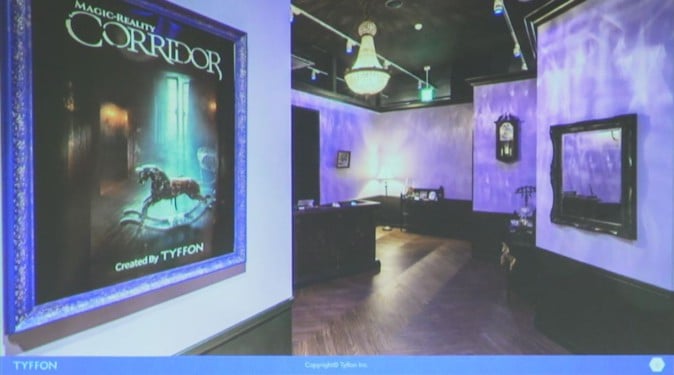

セッションの最初には、ティフォン株式会社と「ティフォニウム」、そして「ティフォニウム」の中で展開しているMRコンテンツ「コリドール(CORRIDOR)」と「フラクタス(FLUCTUS)」について解説がありました。

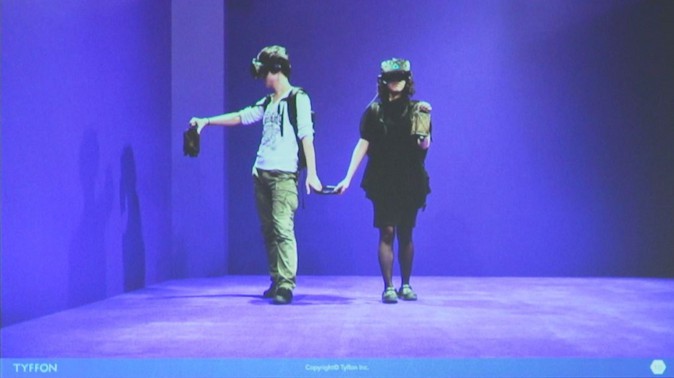

「コリドール」はティフォンが最初に作ったVRコンテンツで、廃墟になった洋館を探索するというホラーアトラクションです。現実世界では4m × 8mの何もない空間を歩いているだけなのですが、HMD(ヘッドマウントディスプレイ)を被るとCGで描かれた世界が現れ、開閉するドアの所を通過させることで、同じ空間を歩き回っているだけにもかかわらず、新しい部屋にどんどん進んでいるような感覚を体験することができます。

また、他のVRコンテンツとの違いとして、HMDに付けたカメラに映し出された現実世界の手や体、他人がCGで描かれたVR世界でも見えるため、より没入感があがる仕組みになっています。

また、「コリドール」は2017年の夏、赤坂サカスのイベントで最初にリリースし、その年の10月には直営店「ティフォニウム」を台場にてオープンさせました。台場店では店舗設計や運営もティフォン株式会社が行っています。

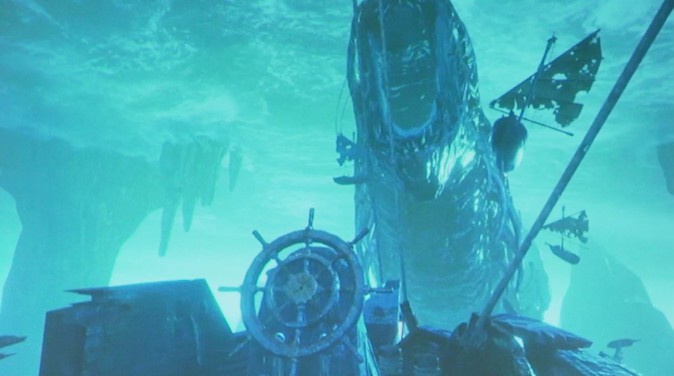

続いてリリースされた「フラクタス」は5人まで同時に体験可能な、船にのって別世界を旅するというファンタジーアドベンチャーです。特徴としては、4m × 4mの空間のブースに設置された舵を物理的に触って船を操作することができ、またハンドジェスチャーを使ってVR内のCGキャラクターとインタラクションすることができます。

「ティフォニウム」は台場だけでなく、11月に渋谷にも店舗をオープンしています。

そしてティフォンは、今後ホラーだけでない、様々な分野のアトラクションを展開予定しています。ティフォンによるオリジナルコンテンツと平行して、ハリウッドスタジオの大型IPなどパートナー企業コラボ企画も推進中とのことでした。

ティフォニウムのコンテンツを支えるシステムの裏側

コンテンツの紹介ののちに、ティフォンのコンテンツのシステムに関する技術解説が行われました。

「コリドール」「フラクタス」に共通した機能としては、

・シーンの展開にあわせて床を振動

・HMD内蔵のカメラを使って、撮影した様子をリアルタイムにCGで作られたVR空間に取り込む

というシステムがあります。

さらにフラクタスでは、

・現実空間でも、VR空間と同じ位置に船の舵や手すりがある

・体験の進行にあわせて風が吹く

・コントローラー無しに、ハンドジェスチャーをすることでCGに対してインタラクションが行える

といった機能が実装されています。

振動や船の動きの実現

床の振動については、床下に上を向けて配置したスピーカーを配置しており、低周波の音を大音量で鳴らすことで実現させています。スピーカーの動きはコンテンツを管理するPCにつないだシングルボードコンピュータ(Raspberry Pi)で制御することで体験の進行度合いによって床が振動するようになっています。

「フラクタス」における舵の操作についても、舵の回転角度をRaspberry Piを通じてPCに送信することで、体験者5人が同じ船の動きの映像を共有することができます。

体験者の手や顔をCGに取り込むMR機能

ティフォニウムのコンテンツでは、体験者の手や顔をHMDを通じてみるCGに取り込むMRの機能があります。これはどのような形で実現しているのでしょうか。

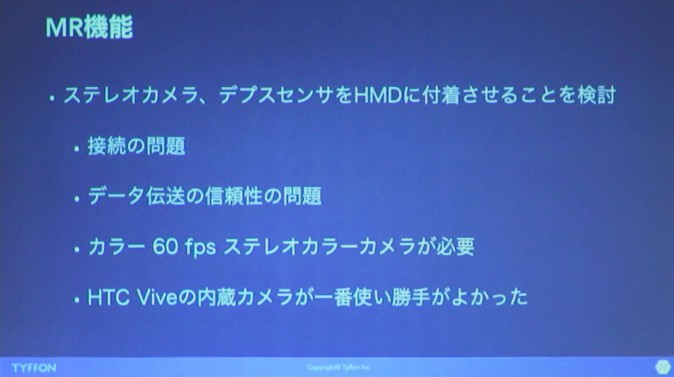

当初、HMDにステレオカメラや赤外線のデプスセンサを付けて運用することを検討しましたが、その際カメラに要求されたのは、カラーで最低60fpsで撮影できるという条件です。その条件を満たすカメラはありましたが、

・コンテンツを店舗で運用しているうちにコネクタが緩んだり外れたりするといった接続に関する問題

・映像をPCに取り込む際にディレイ(遅延)が想定よりも大きかった

・デプスセンサは、手など近くにあるものだけを取り込みCGに合成させる目的での利用をを考えていたが、蛍光灯のフリッカー(ちらつき)により赤外線の認識精度に影響があった。(当初は体験ルームの壁を緑や紫にすることは考えていなかった)

という、様々な問題に直面しました。

そのためHMDとの外付けによるカメラの利用は断念し、使い勝手の良いHTC VIVEの内蔵カメラを使用することを選択しました。ただし、現在流通しているVIVE Proのカメラは複眼である一方、初代VIVEの内蔵カメラは単眼ゆえにデプス(対象との奥行の距離)を測ることができなかったそうです。

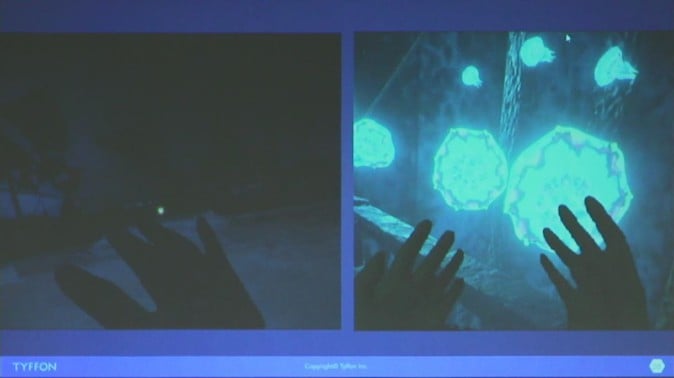

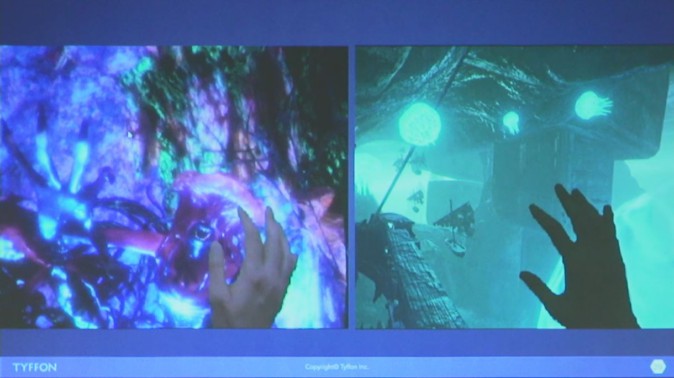

カメラで体験者の手を取り込む際に、実際は明るい部屋で手がカメラで撮影されているので、暗い雰囲気のCGの世界と合成する際には、CGと同じように手も暗くしてなじませる必要があります。

デプスが取れれば同じ場所にメッシュなどを置いて、そこにかかってくるライティングの効果などを合成の時に反映させるところですが、初代VIVEではデプスが取れないので、だいたい手がありそうなところに平面の(体験者には見えない)オブジェクトを配置し、そのオブジェクトにかかるライトの効果をカメラに反映させる、という手法をとりました。

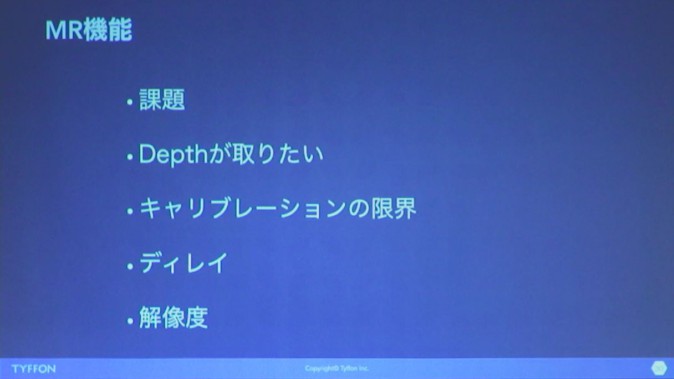

MR機能についての今後の課題、希望としては

・現在はハンドジェスチャーとして手を振り払った動きのみを取得しており、それによってVR空間のクラゲなどにリアクションをさせているが、デプスがが取れれば対象を触ったり握ったりという体験もができるようになるのではないか

・カメラはHMDについている、つまり体験者の目より前についているため、手をカメラに近づけると大きくなりすぎてしまう、というキャリブレーション面での問題がある

・カメラ画像はUSBを経由してPCに取り込まれてから表示されるので、少なくとも1フレームのディレイが発生する。CGなどの処理が重くなると、さらにディレイが発生してしまう

・解像度がもうちょっと欲しい

という点をあげていました。

ティフォニウムのコンテンツのCGについて

システム面の解説に続いて、ティフォニウムでのコンテンツでの現状のCGの表現手法について解説が行われました。

背景-プロシージャルに生成される雷

背景描画の事例として「コリドール」の暗闇の空に雷が光るシーンがあげられました。雷が落ちるたびに雷の光が空に現れるのですが、毎回同じ形で雷の光を描画されるとどんなにリアルなものを描いたとしても書割感は否めないため、コリドールでは稲光の形状をプロシージャルに生成させているということでした。形状が異なるため、雷の発生位置が固定であることには気づかれにくいそうです。

描画速度の都合で重い処理ができるわけではないけれど、今後は雲などにもプロシージャル処理を取り入れたり、プレイヤーの行動に応じて背景もインタラクティブに変わるということにも挑戦したいということです。

キャラクターアニメーション-作り込みのアニメーションとインタラクション

キャラクターアニメーションの事例として同じく「コリドール」から、化物が扉が締まるエレベーターに駆け込もうとするシーンが紹介されました。シチュエーションは固定されているシーンは、アニメーターによる作り込みのアニメーションでできてます。

続いて、亡者がプレイヤーに襲い掛かるシーンについての解説です。襲い掛かる部分は、作り込みのアニメーションをループさせて表現し、自由に移動できるプレイヤーに衝突したときは跳ね返ったのちに煙と共に消えていくというアニメーションに切り替えるという手法を用いることで、作り込みのアニメーションとインタラクションを両立させています。

こちらも、今後はプロシージャルで生成されたアニメーションと固定されたアニメーションをそのシーンにあった形で使い分けていきたいということでした。

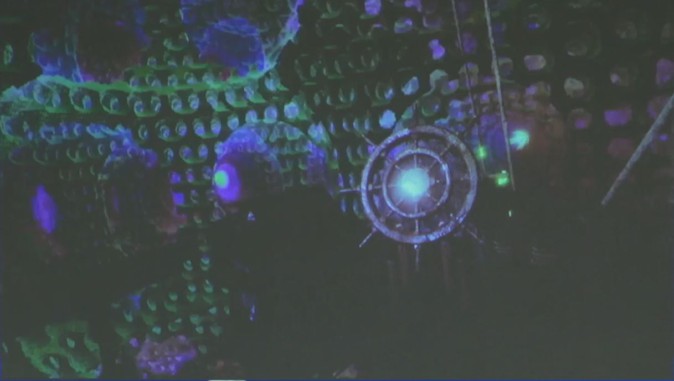

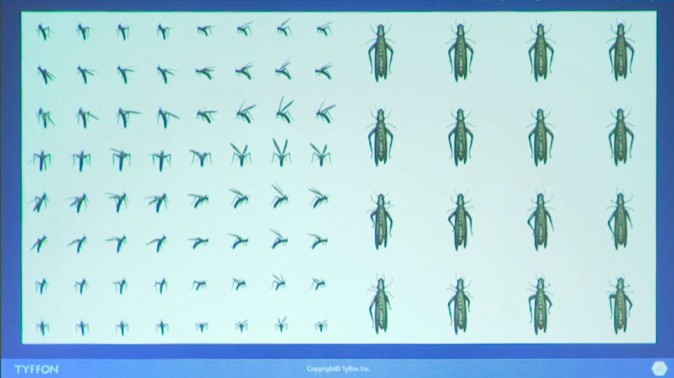

大量のキャラクターをそのまま描画しようとすると、フレームレートの低下につながってしまいます。例えば、壁に張り付く4万匹もの虫に体験者が持つコントローラーを近づけると飛び去るシーンでは、以下のような工夫で描画コストを下げています。

・虫をgeometry shaderで生成した板ポリにし、テクスチャを切り替える(Sprite Sheetにしてコマを変える)ことで虫のアニメーションを実現させる

・虫同士の衝突は考慮しない

・虫の動きを点の動きとしてGPUで計算させる

[wc_row][wc_column size=”one-half” position=”first”]

[/wc_column][wc_column size=”one-half” position=”last”]

[/wc_column][/wc_row]

こうした虫の大群の動きですが、制御するいくつかのパラメーターによっては、作り物の虫に見えたり、動きが速すぎてイナゴではなくゴキブリのように見えてしまったりしてしまい、試行錯誤で本当に虫に見える最適な値を作り出したそうです。

今後としては、そのパラメーター設定の自動化や個体間の違いなどにも挑戦したいとのことでした。

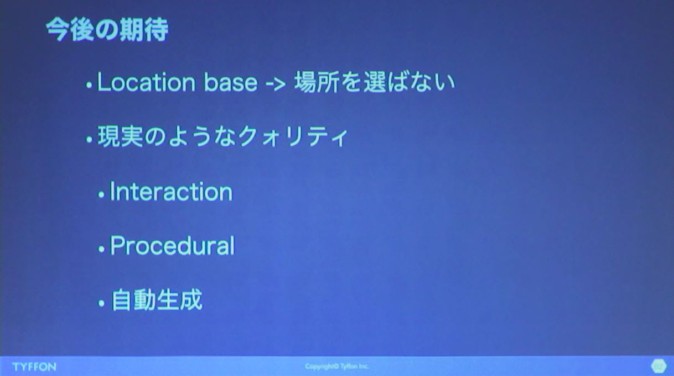

今後の展開について

中橋氏は本セッションの最後に、挑戦していきたい事項を「今後の期待」としてあげました。コンテンツとしては、映画や現実のようなリアルでクオリティの高いものを、プロシージャルに、インタラクションができる形で作っていきたいそうです。

そして、現在ロケーションベースでコンテンツ提供をしているティフォンですが、今後は場所を選ばない形での提供も挑戦したいとのこと。ロケーションベースは、例えば実際に自分の足を動かしてコンテンツの世界を体験するということができるのが強みではあります。それを自室で座ったままで同様の体験をさせるのはなかなか難しいところではありますが、例えばBrain Computer Interfaceを用い、考えただけでVR空間で歩いているような体験をさせる、ということにも挑戦してみたいとのことでした。