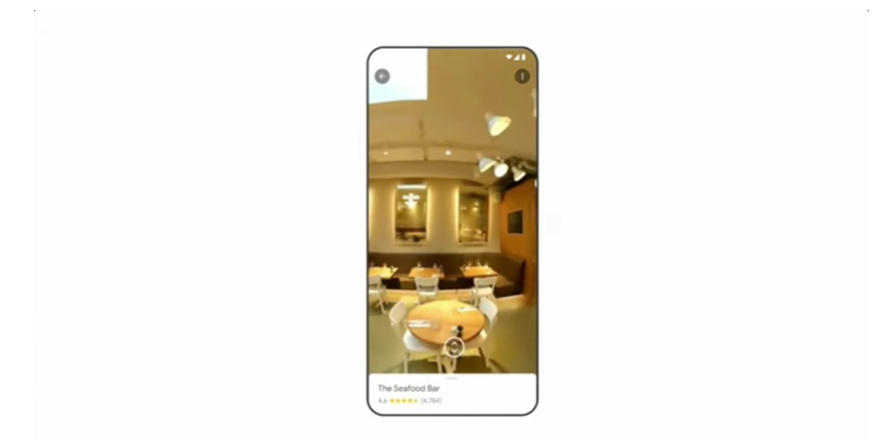

Googleは「neural radiance fields (NeRF)」を使って作成した、建物内の360度映像を公開しました。同映像はスマートフォンから視聴することが想定されています。

「NeRF」は、複数アングルから撮影された2D画像から、深層学習を活用して3D画像を作成する手法です。今回、Googleが公開した映像は、 DSLR(デジタル一眼レフ)カメラで撮影された写真から構成されており、撮影に360度カメラを使用していません。

まず、SfM(※)で撮影画像の位置情報や他写真との相互関連度、焦点距離などを反映したデータを作成。その後「NeRF」で映像の生成が行われました。今回使用された「NeRF」モデルの学習は、撮影場所でゼロから行われたとのこと。Alphabetが開発した「NeRF」関連の公開研究データも複数導入されているそうです。

※写真などをソフトウェアで分析し、3次元点群データとして再現する手法。

Immersive View gives users a virtual, close-up look at indoor spaces in 3D! Learn how it uses neural radiance fields to seamlessly fuse photos to produce realistic, multidimensional reconstructions of your favorite businesses and public spaces → https://t.co/hTndc084bD pic.twitter.com/lZUm5Hd4Lp

— Google AI (@GoogleAI) June 14, 2023

Googleは、今後も「NeRF」関連の研究を継続する予定。将来的には、各シーン(映像)へのセマンティック情報の付与や、屋外で撮影された写真からの映像生成などに取り組む計画です。

(参考)Google Research