本記事をお読みの方々に、いまさら「視界すべてがディスプレイに置き換わった時に生まれる世界の可能性」を語る必要はないと思っている。

MetaやPICO、ソニー・インタラクティブエンタテインメントにXREALと、この世界の可能性にトライする企業を挙げれば枚挙にいとまがない。

でも、xRデバイスの世界は「かぶってなんぼ」だ。言葉では伝わらないし、「PV詐欺」だって山ほどある。

ではそこで、アップルは新発表された空間コンピュータ「Vision Pro」でどんな答えを提示してきたのか? 以下のプレゼンビデオを見た人なら、誰もが気になるところだろう。

米・クパティーノのアップル本社で、短時間だが体験取材が行えた。そこで感じたことをそのままお伝えしたい。

「これはやばい。にせものじゃないぞ」

ではどういうものだったのか、ご説明していこう。

また、機構やソフトウエア的な構造なども含めた考察は、6月12日にMoguraが開催する有料オンラインイベント「XRの最新動向を語る「AWE&WWDC報告会」でもお話しする。ご興味があればぜひ参加のご検討を。

なお、実機体験中は、写真撮影や動画撮影が許可されなかった。記事中の写真は、別途行われた撮影セッションと、基調講演のものが中心である。

顔パッド+バンドで固定。「電源接続」で長時間動作にも対応

まず準備から入ろう。

Vision Proはかなり個人最適化が重要な機器のようだ。

体験の前には、「顔の形状認識」と、「視力補正レンズの調整」が行われた。

前者はiPhoneを使い、Face IDで顔の登録を行うような作業だ。後者は自分がかけているメガネを計測し、補正内容にあったレンズを探す作業だったようだ。

どちらにしろ、これらはそんなに時間もかからない。

今回、デバイスは補正レンズも含めて調整された形で渡された。だから、つける作業やそれ以外の調整を自分でどうやるかはわからない。

専用補正レンズを使うところからお分かりのように、メガネをつけたままでは使えない。

次に、いくつかの初期設定を行う。

最初にやったのはいわゆるIPD(瞳孔間距離)調整だ。

一般的なHMDでは、スライダーを使ったり、自分でレンズを動かして間隔を調整したりするが、Vision Proの場合には「ボタン1つ」。操作用の「マジッククラウン」を長押しすると自動的に調整が完了する。これはシンプルに便利に感じた。

Vision Proは視線認識機能を持っているので、それを使ってIPD調整をしたのだろう。

そのあとは視線認識のキャリブレーション。点を目で追っていくタイプのもので、PlayStation VR2などで採用されているUIに近い。シンプルかつ短時間に、こちらも終了する。

これは1つの考察だが、IPDが自動調整になっているのは、IPDのズレが体験の悪化につながるからだろう。特に、マイクロOLEDのように面積の小さなディスプレイを広い視野に拡大するものは、いかにレンズの良い部分と中心窩を合わせるかが大切になる。だからIPDは正しく設定されている必要がある。

ヘッドセットのずれなど、同様に体験を落とす可能性がある要素は多い。

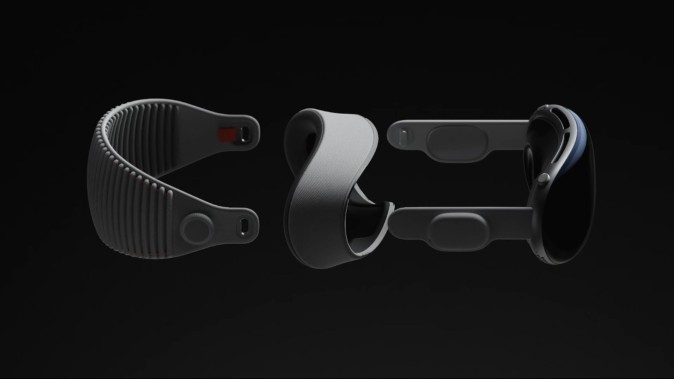

基調講演のビデオと違い、デモ機材には頭頂部にもバンドがあった。

結果としてだが、「額」「頬」「頭頂部」で支えてバンドを軽く締める、という形で装着する。後ろは幅広なのでそこまでバランスが悪いとは思わなかったが、どちらかといえば前が重い「フロントヘビー」ではある。

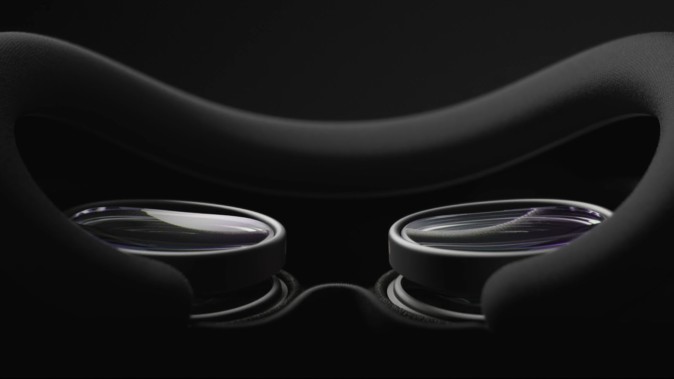

(本体と顔のパッド、そして頭部向けのバンド。このほかに、頭頂部を通すバンドもつく。)

ここで先に言及しておくが、バッテリーは外付け。専用のケーブルでつながっている。ホットスワップはできないそうだが、専用バッテリー自体にUSB Type-Cのコネクタがあって、ここから電源などに刺して給電すればいつまでも動作させられる。

(バッテリーはケーブル接続。ただ、バッテリーに直接USB Type-Cで給電可能)

また、バッテリーのサイズ・容量も、正確な数字は公開されていないものの、「航空機の中に問題なく持ち込めるもの」(アップル)だという。

自然すぎる「ビデオシースルー」

次に、基本的な体験から説明していく。

空間内にアイコンの並んだ「ホーム」が出てくる。ここでの背景は、今自分が座っている目の前の風景だ。

(ホーム画面の一例。後ろに映っている部屋が「自分が見ている風景」そのものだ。)

これが、びっくりするくらい「普通」だ。

解像度もしっかりしているし、発色も違和感がない。現実に比べるともちろん、多少色は浅いし解像感も劣るかな……とは思うが、そのくらいだ。

視野角(FoV)は、スペックとしては公開されていないものの、アップルによれば「約90度」だという。

まあ確かに、Meta Quest Proなどに比べると視界は狭いかな……という気はする。

しかし、すぐに気にならなくなる。理由はおそらく、視界の端の描写を工夫することで、うまく誤魔化されているためだ。

端はグラデーション的に暗くなっているのだが、顔の動きに合わせてその暗い部分も自然に変わる。自然な範囲で首を動かしているとそうした機能が「存在しない視野の端」をなんとなくカバーしてくれるので、FoVの狭さを感じづらいのだろう。

またそもそも、狭いといっても90度あれば「視界に開いた窓をのぞく」感じはないから、とりあえずOKとしていいのではないか、とも思う。ゲームをするにはちょっと物足りないかもしれないが。

見える風景が“自然”というのは、「肉眼で見た場合に自分が感じる距離感・立体感との乖離がない」ということでもある。これは非常に重要だ。

コンシューマ向けである「Meta Quest Pro」や「Meta Quest 2」、「PICO 4」ではどうしても違和感が拭えなかった。「PlayStation VR2」は歪みや立体感のズレが小さい印象だが、カラーではなくモノクロで、しかも設定や周囲を見たいときのための補助的な機能でビデオシースルーをゲームなどで活かす方法がない。

Vision Proは、それらよりもレベルが確実に上だ。しかも、映像の解像度も十分に高い。だから、つけたまま歩き回っても酔わないし、何かに引っかかって転びそうにもならない。机の上に置かれたコップを自然に持つことだってできる。

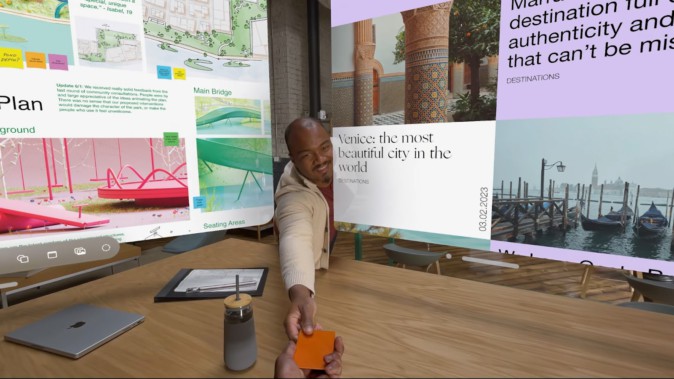

(家の中をつけたまま歩き回ったり、近くの人から自然にものを受け取ったりできるのも、ビデオシースルーの品質が高いためできること。)

アップルによれば、この部分は専用チップセット「R1」がかなりの仕事を担っているそうで、まさにハード+ソフトの合わせ技で実現しているといえそうだ。

操作の基本は「手」ではなく「視線」

操作は基本的に「手+視線」、あとは補助的に、本体上部右側にある「マジッククラウン」を使う。

マジッククラウンの使い方は、ぶっちゃけていえばApple Watchと同じ使い方だ。押すと「ホーム」への移行などが行われ、長押しでキャリブレーション。「回す」動作についてはあえて後ほど。

マジッククラウンを押すと、アイコンが並んだホーム画面が出てくる。

よく訓練されたVRマニアはここで腕を空中にあげて指差したくなるところだが、それはいらない。実際筆者は「手をあげなくていいです」と説明員の人に言われてしまった。

カーソル的な位置認識は「視線」で行う。

視線認識は便利だが、揺れなどもあるので正確さを出すのが難しい。しかし、Vision Proはかなり正確に視線で操作ができる。どのくらい正確かというと、1mくらい先にある指先くらいの●をチラ見してもピッタリあって、ブレなどもでないくらいだ。

もちろん100%の精度というわけではなく、ちょっとズレることもあったが。少なくとも今のハンドコントロールで「ポイントを指す」よりずっと認識率はいい。

決定は、親指と人差し指をぶつける「タップ」の仕草。手は膝の上でもどこでもいい。流石に背中の後ろなどでは試さなかったが、無理に手を持ち上げる必要もない。スクロールなども手首を捻る程度でいい。

(視線操作がメインで、手は上に持ち上げず「決定」などに使う。)

操作は左右どちらの手でもいいので、利き腕を気にする必要はなさそうだ。

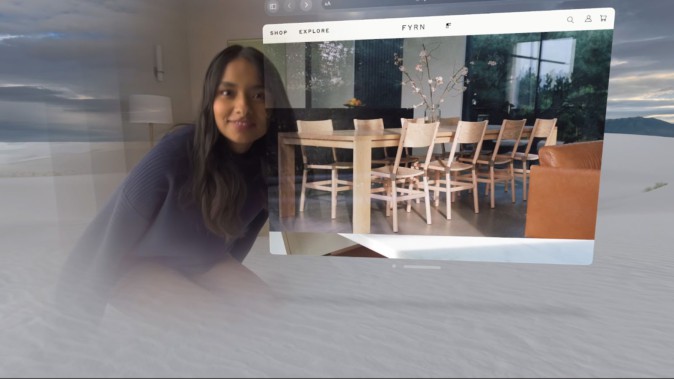

アプリは基本、空中に「ウインドウ」の形で表示される。端を引っ張ればサイズを変えられるし、同じくウインドウ下の「バー」をつまむと、ウインドウの3D空間内での位置を変えられる。

ウインドウを正面以外に置きたい場合には、そちらを向いてアプリを立ち上げてもいいし、バーをつまんで移動してもいい。iPadOSでアプリのウインドウズサイズを変えたり、位置を変えたりするのに似ている。

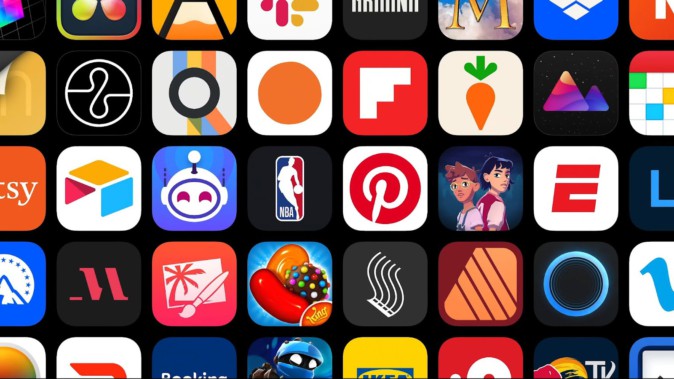

アプリとしては、iOS/iPadOS用のものがほぼそのまま動く。「一部iPadなどに特化したUIを持つものは修正が必要」(アップル)とのことだが、概ね全て動くと考えていいだろう。

現実と仮想の間を行き来する

前述のように、周囲の風景は、デフォルトでは「実景」。Vision Proのカメラで撮影された実景が、リアルタイムでUIなどのCGと合成されて表示されている、というべきだろう。

シースルの品質が自然すぎて「ビデオで撮影された映像である」ことを忘れがちになるが、本来は「背景ステージの1つ」にすぎない。

Macの壁紙のように、背景となるステージデータは複数のものが用意されている。この背景は「リアルタイムの実景表示」とは別のレイヤーに隠れた形となっている。

ここでマジッククラウンを回すと、表示されていた実景が少し透明になり、その分、設定されている「背景」が見えてくる。さらに完全に回し切ると、実景は一切見えなくなり、設定した背景の世界の真ん中に自分がいる状況になる。

マジッククラウンは、現実と仮想を行き来するためのコントローラーなのだ。

とはいえ、前出のように、これは「背景になる映像同士を切り替えている」にすぎない。その片方が「目の前の現実の映し絵である」から、我々は「現実と仮想の間を行き来する」ように感じるのだ。

同様に、「Persona」「EyeSight」も、現実と仮想の間を行き来する機能だ。

Vision Proでは、距離センサーを活かして自分の顔を「スキャン」して、自分に似せた「Persona」を作れる。

PersonaはVision Proの視線認識などと連動、目の動きや表情、口の動きや身振り手振りなどをそのまま再現する。

(Persona。自分の姿を機械学習で3D化、ビデオ通話などでアバターとして使う。)

他のHMDでいう「アバター」なのだが、アップルは周囲の誰にでも「自分とわかる」よう、リアル思考を選択している。

「EyeSight」は、誰かが近くに来て話しかけてきたら、その人を認識して、その部分だけ「相手を画面内で見える」ようにするもの。Vision Proをかけたままでも、外側にいる人と問題なくコミュニケーションができた。

(近くに来た人とコミュニケーションを取るための「EyeSight」。自然にその場所にいる人だけが見える。)

HMDでもヘッドホンでも、つけていると「話しかけてほしくない」印象ができる。だが、EyeSightによって、周りにいる人に話しかけられても自然に対応ができる。

なお、EyeSightに自分以外の映像、例えばキャラクターや文字などを表示したい、というデベロッパーもいると思う。だがアップルによれば、「EyeSightはPersonaを表示するために使うよう特化していて、他の用途には使えない」という。

理由はわかるがちょっと残念だ。

新型ARアプリはどこから生まれるのか

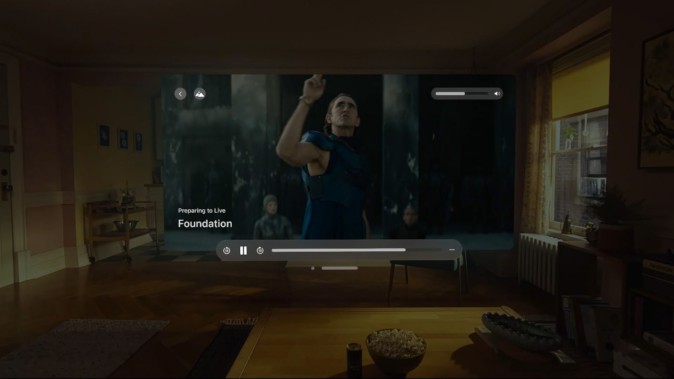

一般的なVR・ARデバイスと同じように、Vision Proでも大きなシアタースクリーンを出したり、3Dオブジェクトを出してインタラクションしたり、ということはもちろんできる。

今回の場合、3D版の「アバター」やアップル独自規格の「Apple Immersive Video」などを体験できた。どれも、やっていることは以前からあるものだ。ただ、コンテンツのクオリティが本気すぎる上に、Vision Proのディスプレイ品質と音質もかなり本気なので、いままでの「HMDでのオーディオビジュアル体験」よりずっとクオリティが高い。

3DによるARアプリケーションとしては、恐竜が部屋の中に入ってくるものを体験できた。

これも質が高い。

人差し指を空間に差し出すと、そこに蝶が止まる。ピッタリと指の上に止まり、色々な角度から見てもほとんど位置がずれない。近寄ってみると1ドットくらいしか太さのなさそうな、蝶の足や触角まで見える。

そのうち、部屋の空中に、大きな窓のように「恐竜の世界」が見えてくる。恐竜のモデルは、精密かつテクスチャーも精緻で、AR体験としてはかなりのものだ。

(恐竜に触れられるような3D体験も。自分の部屋の中で当たり前のようにできるところが素晴らしい)

しかも、このアプリのオブジェクトと自分の手・体の間では、ちゃんとオクルージョンが効いていた。手の指を1本1本認識し、「手の向こうに恐竜が見える」動作になっている。

もちろん、手の指の縁ギリギリには、オクルージョンの境界も見えてくる。だがそもそも、ここまで自然に手や家具までオクルージョンの対象になっている、自然な動作のデモアプリは少ないのではないだろうか。

アップル担当者は「なぜ発売から時間があるのに、WWDCでVision Proを発表したかというと、こういうアプリをたくさん作って欲しいから。ここからはみんなのターンだ」と話していた。

まさにそういうことなのだろう。

アップルとしては「リアルワールドに紐づいた空間コンピュータ」としてVision Proを作ったのだろうが、それをデベロッパーがどう使うかは別の話。アプリの存在が機械の特性を決める。

アップルはそのための「圧倒的に良くできた基盤」を、今回用意することができた。

価格は高いが、これがコストダウンしていくであろう2年後・3年後に向けて、Vision Proが提示した世界を基準にして開発を進めてもらいたい……というのが、アップルの狙いだと感じる。

●関連イベント「XRの最新動向を語る「AWE&WWDC報告会」(主催:株式会社Mogura)

世界最大のXR業界カンファレンス「AWE USA 2023」と、Appleの年次開発者会議「WWDC 2023」の報告会をウェビナーで実施します。

6月12日(月)の19:00から、参加費は1,500円です。参加申込はこちらのリンク(Peatix)から。

(登壇者:西田宗千佳(ITジャーナリスト)、久保田瞬(Mogura VR編集長))