今年の9月4日から6日にかけて開催された、ゲームを中心とする開発者カンファレンス「CEDEC 2019」。本記事ではWright Flyer Live Entertainmentによるセッション「REALITY『なりたい自分で、生きていく』リアルタイムライブでVTuberが活躍する舞台を作る現場の1年」で語られた、VTuberのリアルタイム番組の制作スタジオ「REALITY Studio」の様子についてレポートします。

REALITY Studioの概要

Wright Flyer Live EntertainmentはVTuber専用配信アプリ「REALITY」を運営するプラットフォーム事業をはじめ、バーチャルYouTuber(VTuber)関連のライブエンターテインメント事業に取り組む企業。VR関係の研究開発を行うGREE VR Studio Labと連携を取って活動しています。

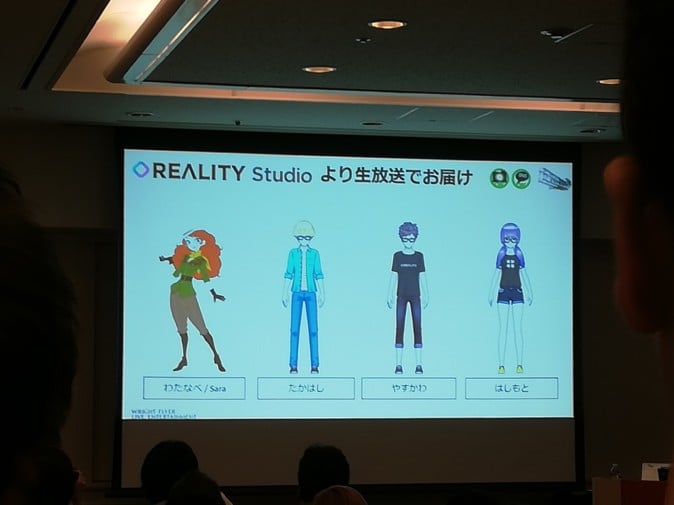

登壇したのはGREE VR Studio Labディレクターの白井暁彦氏と、REALITY Studioからアバター姿で遠隔参加する4名の社員。講演の進行はスクリーン内のバーチャル社員が行うという、REALITYならではの珍しい形がとられていました。

(REALITY Studioから生配信で遠隔参加。ちなみに当日は開場前から長蛇の列が形成され、ほぼ満員状態だった)

REALITY Studioはモーションキャプチャー技術を用いてVTuber番組を制作・配信するスタジオ。本セッションでは現場で運用している設備に加え、実際の番組制作で得た知見など、さまざまな話を聞くことができました。

講演でははじめに、REALITY Studioが1年で生み出した数々の成果を紹介。1年間で400回以上の生放送を行い、歌番組やゲーム実況番組、バラエティ番組など多様な番組を成功させてきたことが語られました。

「毎日生配信」の体制は要件定義や本開発を経て2018年下半期から開始し、VRM対応やソリューション事業等と並行して生番組の開発・運用を続けてきたとのこと。

スタジオにはエントランスや控室、キャプチャー用ルーム、コントロールルームを配置。

キャプチャールームには身体・表情・指のキャプチャー機材、モニターやマイクなどの一式が設置されており、1部屋につき4人まで共演が可能。コントロールルームにはデータ処理や音響調整、配信などを行うために多数のPCが並んでいます。

モーションキャプチャーシステムの選定

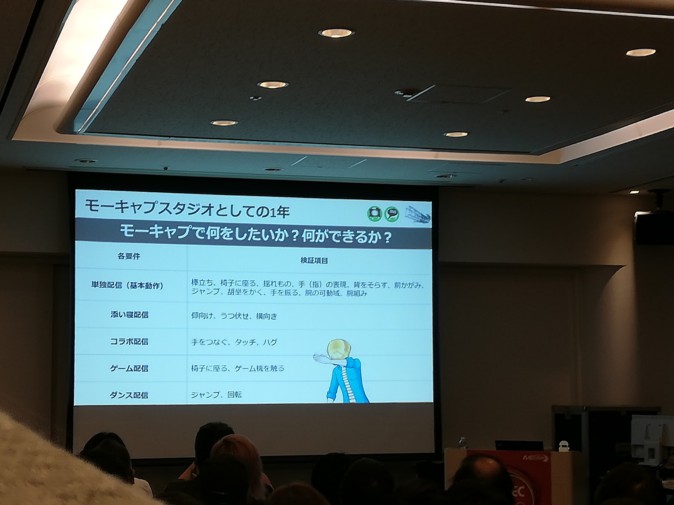

続いて、出演者の動きをバーチャルキャラクターに反映させるモーションキャプチャーの技術について紹介。モーションキャプチャーで実現しなければいけないVTuberの動作は、立ったり座ったりをはじめとする基本動作に加え、添い寝配信ならば寝転がる動き、コラボ配信ならばVTuber同士で自然に干渉する動き……などなど、配信の種類によって違いがあります。

(モーキャプには用途に応じた様々な要件がある。機材の選定にあたっては、ライブ配信の内容ごとに「どんな動作の実現が求められるか」を洗い出し、それを踏まえることが求められる)

モーションキャプチャー機材にはカメラで反射マーカーを認識する光学式やセンサの動きから位置を逆算する慣性式などの形式が存在。光学式は絶対座標を計測し誤差蓄積もありませんが遮蔽・反射に弱く、慣性式はそのおおよそ反対の特徴を持っています。さらに機材によってコストや機能の安定性、正確性、スケーラビリティなどの違いがあるため、現場の状況を考慮しつつ選んでいく必要があります。

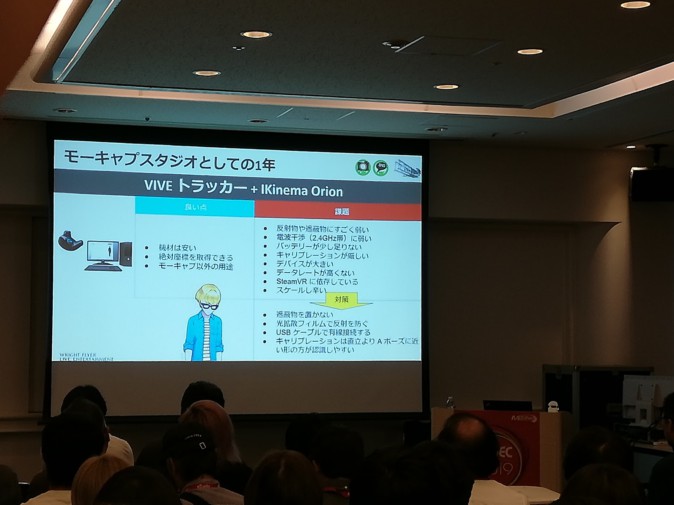

スタジオ立ち上げ時はデバイスにVIVEトラッカー、ソフトウェアにIKinema Orionを使用。いずれも比較的安価に入手可能で、VRデバイスとして汎用性があることも利点として挙げられます。

ただし反射物や遮蔽物によって妨げられやすい等の安定性の低さ、モーション品質の低さ、スケールのしにくさなど、全体的なクオリティにはやや難がある面も。また、バッテリーの持ちは6時間ほどが限界なので収録には少し足りないそうです。弱点に対しては障害物を取り除く、有線接続する、少し腕を上げた体勢(Aポーズ)でキャリブレーションを行うなどの対策を講じていたとのこと。

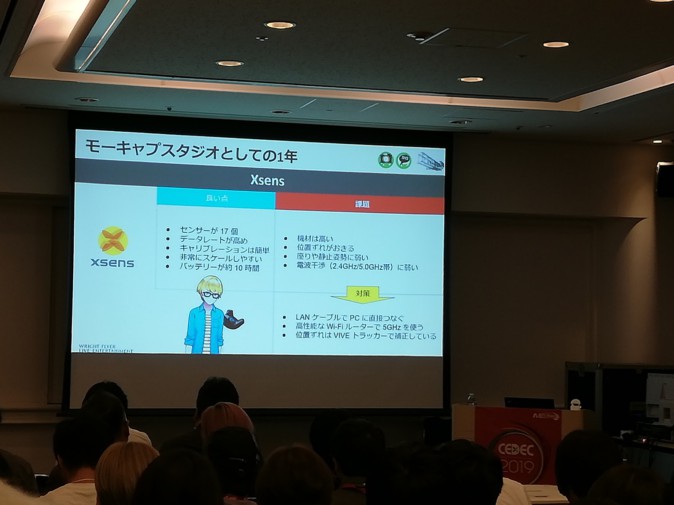

2018年末ごろからは新たにXsensの機材を導入。やや高価ですが17個のセンサーでトラッキングを行うことが可能になり、キャリブレーションの容易さやスケーラビリティ、バッテリーなど様々な面でも改善が見られました。慣性式の欠点である位置ずれに対してはVIVEトラッカーでの補正を行う、電波干渉については高性能ルーターや有線で対応する、といった対策を講じています。

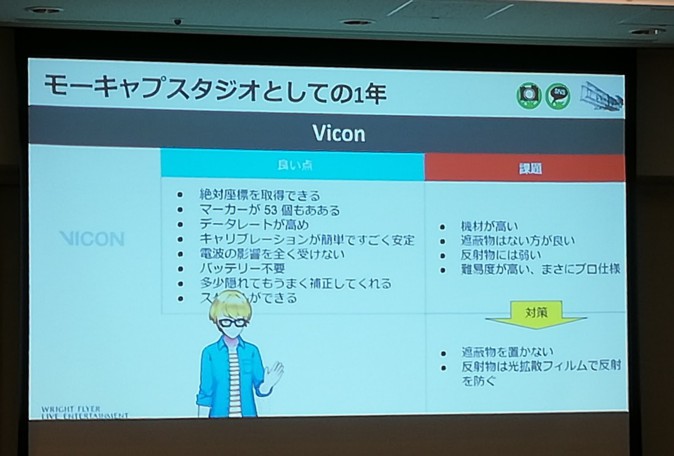

そしてここ最近使用している機材は光学式のVICON。高価で使用難易度の高いモーションキャプチャー機材ですが、53点の精密なトラッキングなど高い基本性能を実現しています。光学式特有の物理的な制限に対してはVIVEと同じく障害を取り払って対応。性能が高いので多少マーカーが隠れても破綻がないように補正してくれるそうです。

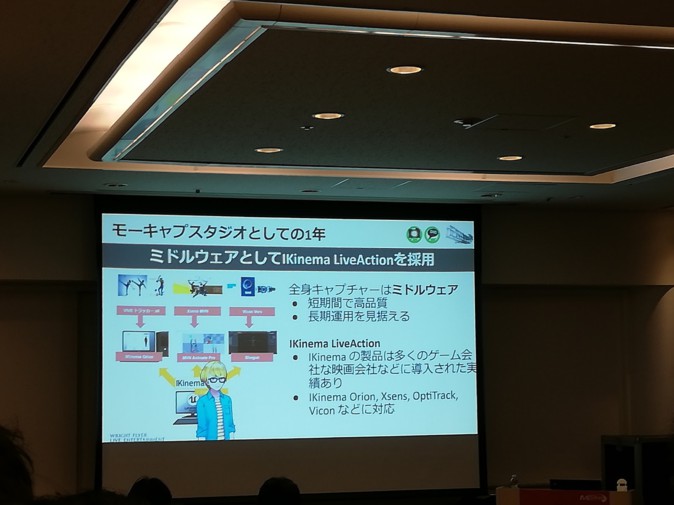

キャプチャーデータを最適化するミドルウェアにはIKinema LiveActionを採用。ゲームエンジン「Unreal Engine 4」を用いた高品質なプラグインです。アニメーションのクリーニングパイプラインは相性が悪かったので使わず、リターゲティングのみを行っているとのこと。

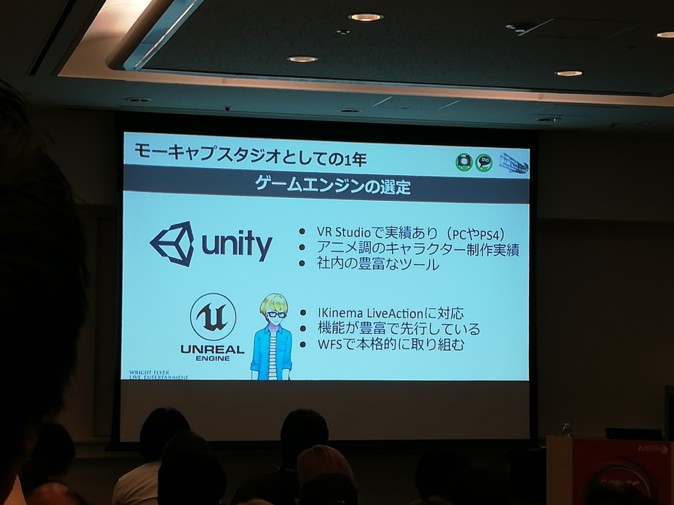

ゲームエンジンは候補として実績や社内ツールが豊富なUnity、機能が豊富でLiveActionに対応しているUnreal Engineが存在。

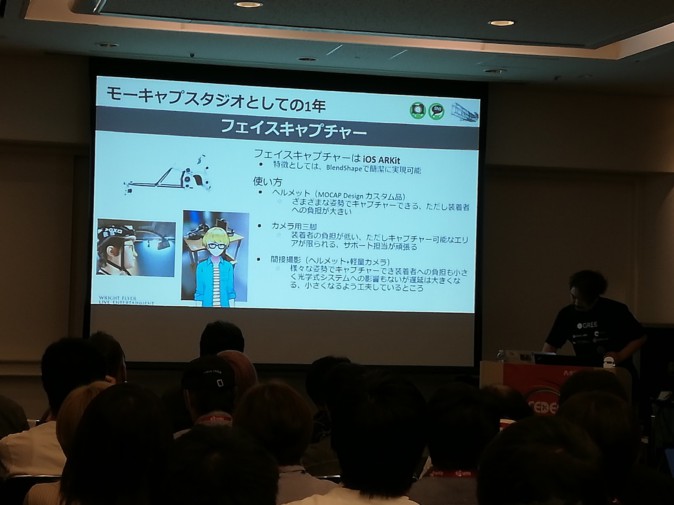

表情のキャプチャーにはiOSのARKitを使用。使い方にはヘルメットや三脚などがあり、それぞれ装着負担と性能のバランスが異なります。重く負担の大きいヘッドセットは演者によっては体調を崩してしまう例もあるため、使用するのはキャプチャーの品質が必要かつ体力のある人の場合のみ。現在はヘルメットに付けた軽量カメラの映像をiPadに送信し、それをiPhoneでキャプチャーする方法に取り組んでいるそうです。

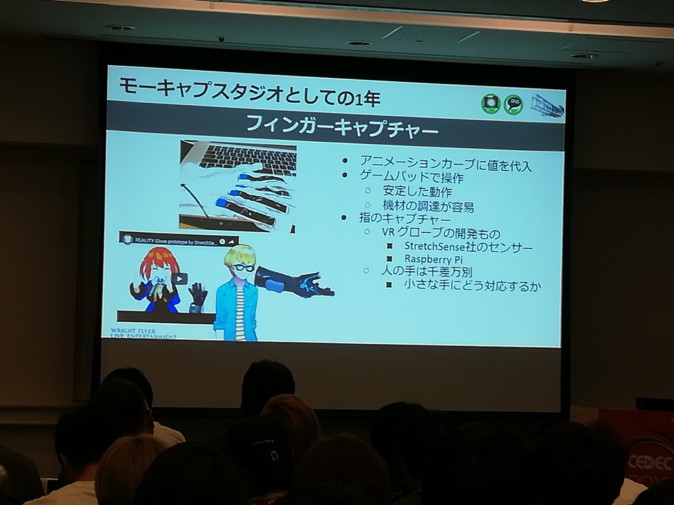

指の動きのキャプチャーにはVRグローブを用い、容易に調達可能で動作が安定したゲームパッドで操作。ここで難しいのは手が小さい人の場合で、人によってはグローブが大きすぎてうまく装着できないことがあるのだそう。こちらは別の手袋を嵌めてもらい手自体を拡大するなどの方法で対応。

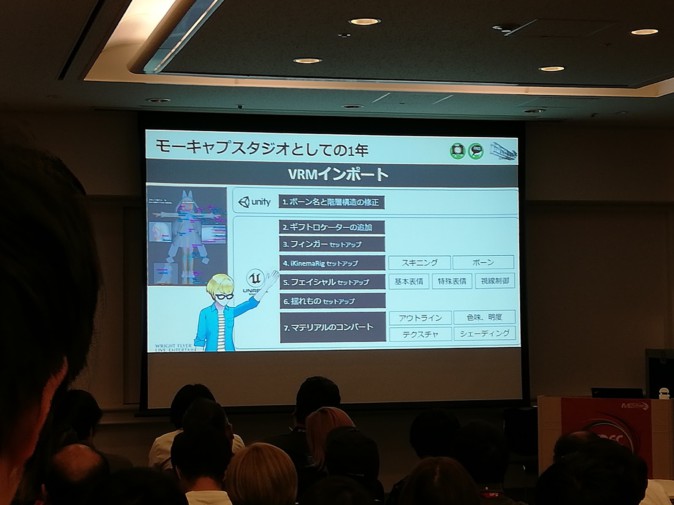

VRMインポートの過程ではUnityでのモデル編集ののちUnreal Engineでのギフトロケーターの追加や各種セットアップ、コンバートが必要。

コンバートには程度があり、20日かけてあらゆる調整を行うフルコンバートを「松」、フェイシャルキャプチャーやボーンの位置調整など一部を省略して4日で行うVRM変換を「竹」、目と口の動きやOrionでのキャプチャーなど最低限の調整を2日で行う特急VRM変換を「梅」として3段階に区別。状況に合わせた選択を行います。

音楽番組の開発例:「ぶいおん」

続いては実際の番組運用システムや開発時に直面した課題について。ここではREALITYで今年の3月から放送しているバーチャル音楽番組「ぶいおん!!」での例を紹介しています。同番組はトークとライブの二部構成からなるもので、ゲストがトーク→ライブ→トークとステージ間を移動することとなります。

トーク会場は既存のシステムを改造、ライブ会場は新規に作成することに。キャプチャーは2つのスタジオで同時に行い、それらの映像を切り替えていくことで番組を再生するシステムです。

元々10個だったカメラは32個へと大幅に拡張。キーボードで足りないような多数のボタンを持つ入力機器は限られており、最終的にはMIDIパッドを用いた制御に行きついたとのこと。

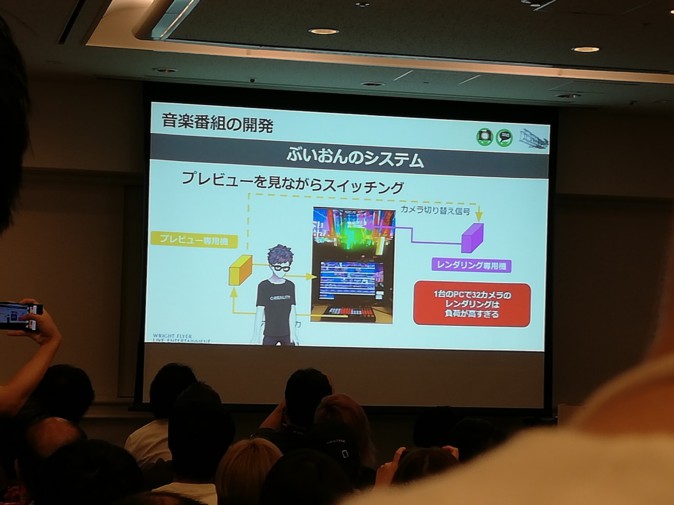

カメラはプレビューを見つつリアルタイムにスイッチング。32個ものカメラのレンダリングを1台のPCで行うのは負荷が高すぎるため、

・プレビュー専用機とレンダリング専用機を用意してプレビュー機へ手動入力→レンダリング機にカメラの切り替え信号を送信するシステム

・カメラのマルチプレビュー映像については、カリング距離の縮小やライティング・ポストエフェクトの削除、低解像度レンダリングなど負荷が小さくなるようにチューニング

といった工夫を行っています。

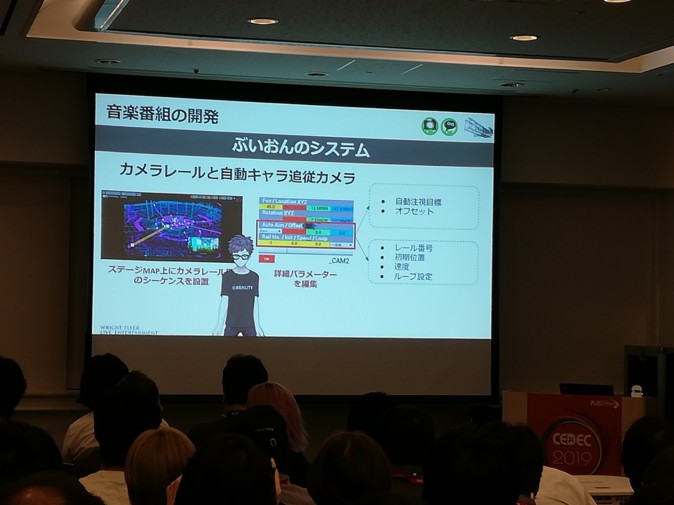

カメラレールのシーケンスはステージマップ上に設置。自動でキャラクターを追従してくれるよう詳細なパラメーターを編集していきます。バーチャル番組の特性上、レールの形はある程度自由が利くとのこと。

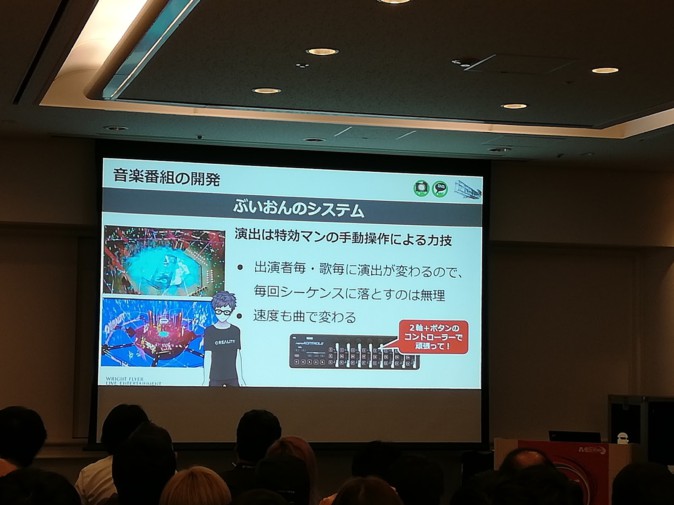

とはいえ、ライブの演出は場面ごとに種類も速度も二転三転するため毎回シーケンスで対応するのは不可能。実際の演出は担当者がコントローラーを駆使した手動操作で行っている状態です。言うなれば職人の力技での解決。

背景のスクリーンにはループバックやVJ、ビデオ素材をBlackmagic DesignのキャプチャーカードDeckLinkとUnreal Engine 4向けのプラグインを用いて映像素材として入力しています。2Dと3DのVTuberが同じ画面内で共演することも可能に。

素材はRolandのビデオスイッチャーV1-HDを通して1080p59.94の形式に統一、DeckLinkを経由し、Unreal Engine側に渡しています。

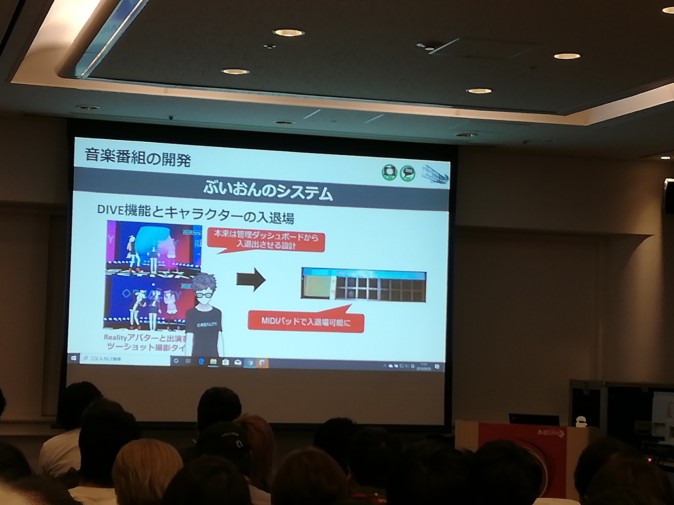

番組では本来は管理ダッシュボードからキャラクターの入退出を行う設計でしたが、MIDIパッドで入退出可能としました。

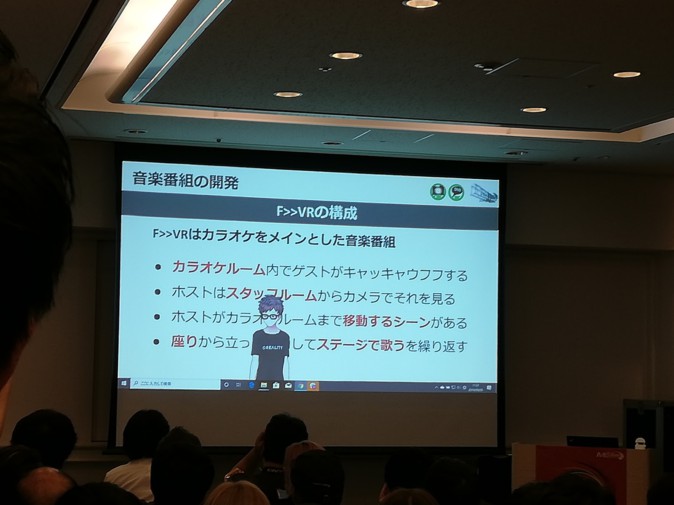

音楽番組の開発例:「F>>VR」

続いては今年8月に開始したカラオケメインの音楽番組「F>>VR」の例。この番組はカラオケルーム内でゲストが交流し、MCは別室からカメラでそれを傍観する構成となっています。時にはMCがカラオケルーム内に入り込むシーンも。

制作にあたってはキャプチャーエリア(現実空間)の設計とステージの設計を並行して実施。スタジオ内の導線も形作っていきます。

ポイントは現実空間でのキャプチャー位置をVR空間内の位置としっかり合わせること。こうして演者が混乱することなく移動できるようになります。

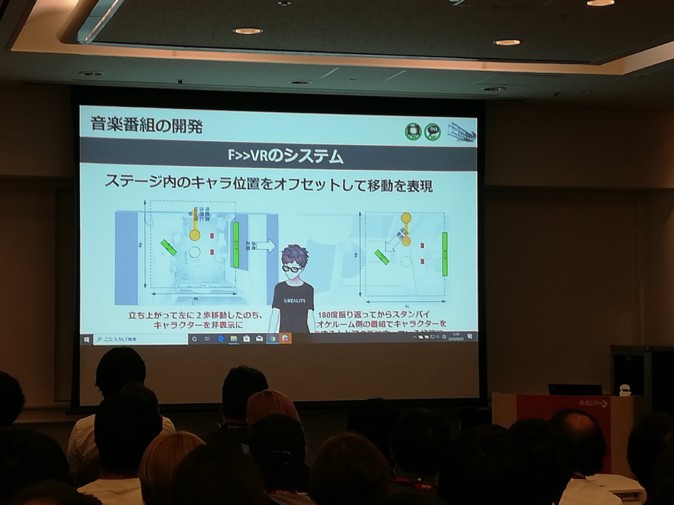

ステージ間の移動は特定の動作をした後あらかじめオフセットされたキャラクターの位置にワープすることで表現しています。

マイクなどの装着物はTouchOSCを使用してコントロール。フィンガーキャプチャーの上書きを行って自然に装着できるようにしているそうです。

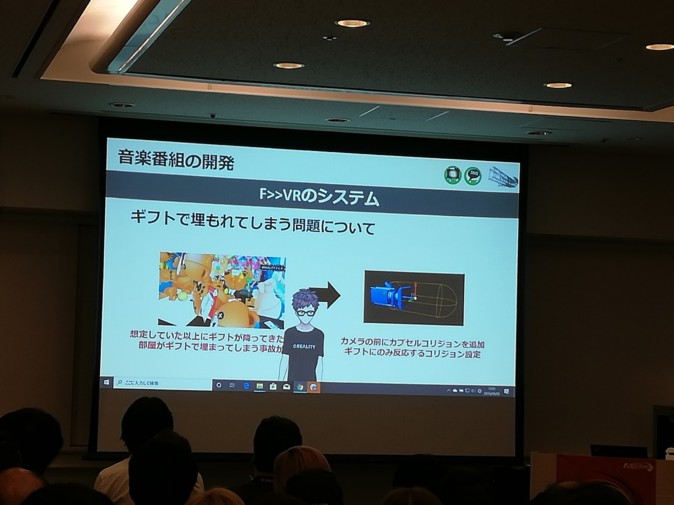

カメラが想定以上の量のギフトで埋まってしまう現象が確認されたので、カメラの前にカプセル状のコリジョンを追加し、ギフトに反応して弾くように設定することで解決。

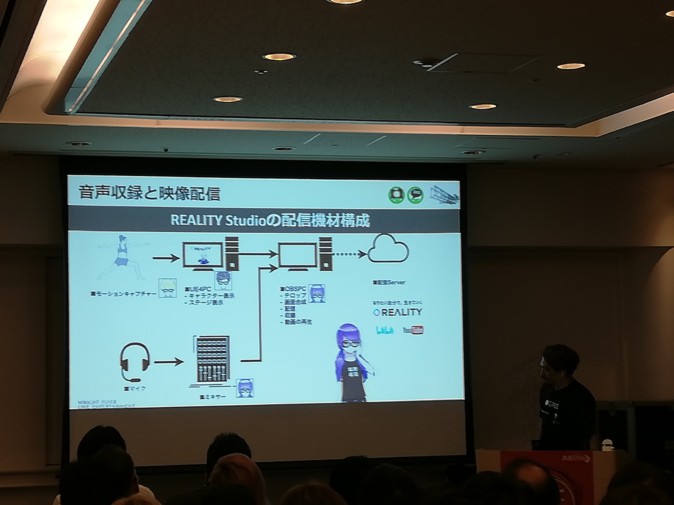

収録システム

REALITY Studioの機材構成はUnreal Engine 4のPCを通して渡されるキャプチャーデータとミキサーを通して渡される音声データを配信用のPCで受け取り番組としてサーバーへ送信するものとなっています。

マイクは主に単一指向性のヘッドセットマイクを使用。ピンマイクはノイズが入りやすいこと、ビジュアル的な配慮が必要なことから避けているそうです。ハンドマイクも口元が隠れてしまうため不適当。

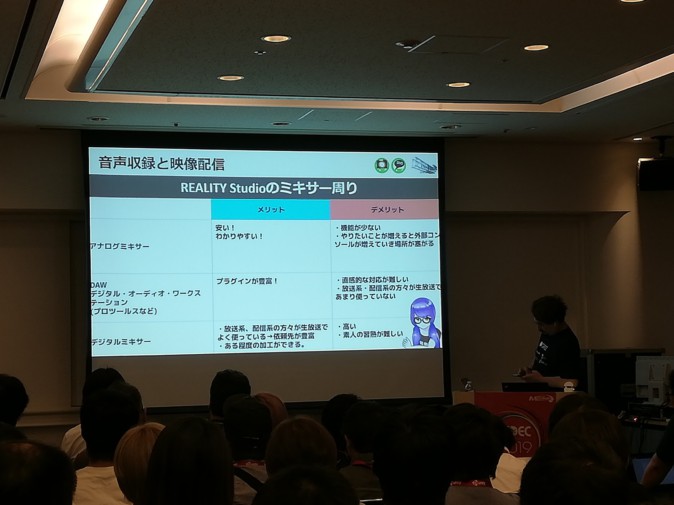

収録音声は常時ミキサーでバランス調整し配信用PCへと入力。また、ミキサーについてはそれぞれ一長一短の特徴が存在します。アナログミキサーは安く扱いやすいものの、機能が少ないことや使用範囲を広げると外部コンソールによって場所がとられることがネック。DAWなどはプラグインが豊富なのが魅力ですが、直感的な操作は難しく、普及度も低いです。デジタルミキサーは依頼先が豊富である程度の加工は可能ですが、アナログと対照的に高価で習得が難しいという欠点があります。REALITY StudioではYAMAHA製のデジタルミキサー(01V96i)を使用しています。

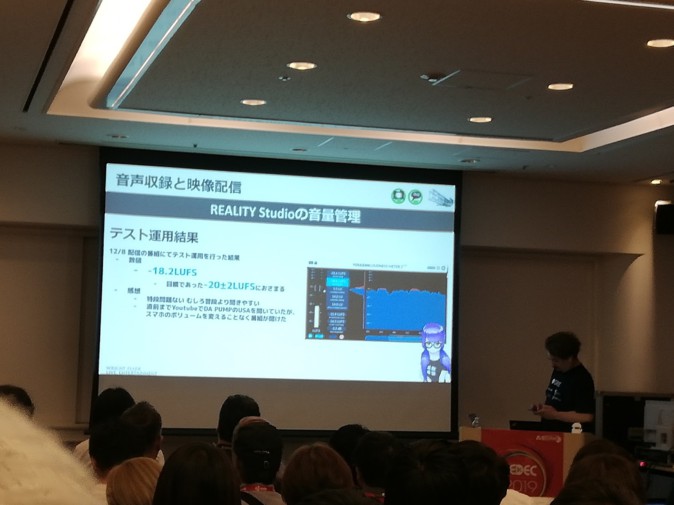

音量調整はラウドネス測定プラグインであるYoulean LOUDNESS METER 2を使用。昨年11月ごろの計測では音割れが起こる-11LUFSから聴こえにくい-40LUFSまで大きなばらつきがみられましたが、12月のテストでは-18.2LUFSと目標値の-20±2LUFSに収めることに成功。十分に聴きやすくバランスも良い状態にすることに成功したそうです。

いずれの要素も運用しているオペレーター、番組視聴者がストレスを感じないことをポリシーとして選定しているとのこと。

VTuber番組ならではの特徴

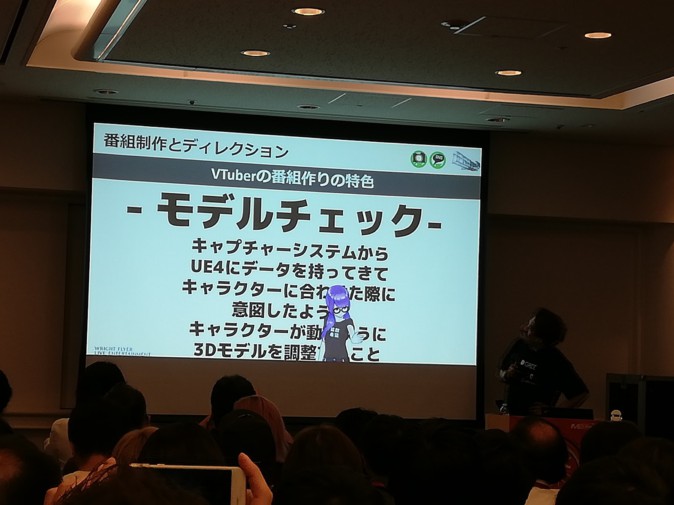

続いては通常の番組とVTuberによる番組の制作方法の違いについて説明。普通の番組であれば、出演者がいてカメラとマイクさえ用意してあれば成立はしますが、フルトラッキングのVTuber番組だとそうはいきません。

・出演者の身体情報をキャプチャーシステムに読み込ませるキャリブレーション

・キャプチャーデータに適合するように3Dモデルを調整するモデルチェック

の手順が追加で必要になるため、通常の番組制作に比べ準備負担が大きいということです。

スーツ装着とキャリブレーションでそれぞれ15分ほど、モデルチェックも最低で15分はかかるため、時間的な圧迫も。作業を並行で進めていかないと制作が間に合わず、REALITY Studioでは演出担当とは別にフロアディレクターが技術打ち合わせなどを分担しているのだそうです。

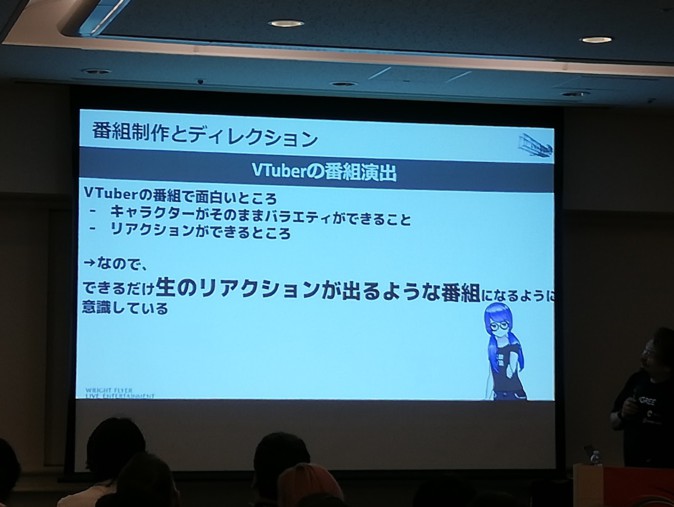

VTuberによる番組特有の面白い点は、キャラクター的存在がそのままバラエティ企画に参加し、リアクションをとれるというところ。番組で起こる様々な出来事に対しVTuberはリアルな反応を返してくれます。

制作にあたってはこういったコンテンツの性質を理解し、できるだけ生のリアクションを喚起する番組作りを心がけているとのこと。ハプニングの種を用意しておいたり、反応を引き出すようなVTR構成にしたり、コメントやギフトへの対応を見たり……とその工夫は多種多様です。

以上のようなメリット・デメリットに合わせるために、「制作進行はかっちりと、演出は余白をもって」という心構えで臨むことが重視されます。

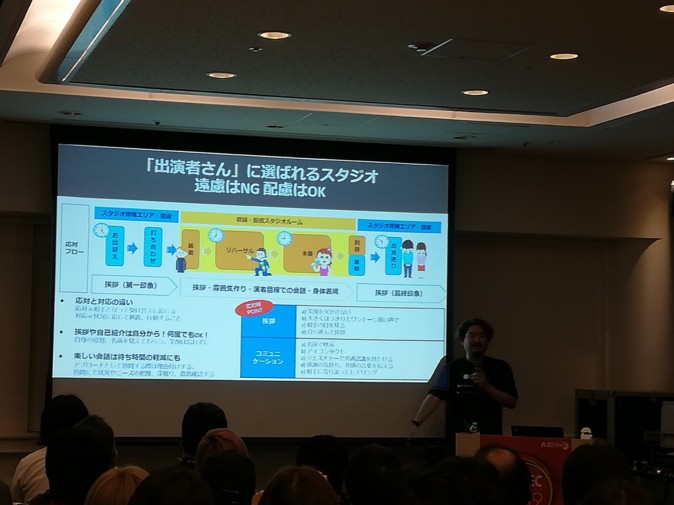

最後に語られたのは「出演者へのリスペクト精神」について。これまでにもたびたび出て来たように、出演者が快適に収録に参加できるようにする意識は重要です。

挨拶や自己紹介を積極的に行うこと、演者目線で明るく会話すること、最後の最後まで丁寧に接すること……システムのみならずスタッフの応対についても、遠慮はしないが配慮は十分にするという心構えのもと、また来たいと感じてもらえるようなものを目指していく、と語りました。

最後はリアル・バーチャルが入り混じった登壇者陣による記念撮影。進化し続けていくREALITYにこれからも注目していってほしい、という言葉をもって、本セッションは締めくくられました。