2018年12月4~7日に東京国際フォーラムで行われた、CGとインタラクティブ技術を扱う世界最大のイベントSIGGRAPH Asia 2018。今回もVR/AR関連の話題・展示が数多く登場しました。

ゲームエンジン「Unity」を開発するユニティ・テクノロジーズ・ジャパン社は開発者らを招待し、Unityで制作された作品の舞台裏などを語る講演会を開催しています。本記事では、SIGGRAPH Asia最終日に行われた、Unity Exhibitor Talks Part2および講演後の記者会見の様子をレポートします。

バーチャルカメラを使った革新的な映画制作の現場の話が聞けたばかりでなく、講演後の記者会見では、映画業界の今後についてなど非常に示唆深い話を伺うこともできました。

登壇者

今回登壇したのはHabib Zargarpour(ハビブ・ザーガパー)氏。Digital Monarch Media社の映像部門のトップとして、バーチャルカメラなど様々なリアルタイムテクノロジーによる映像撮影技法に長年取り組んでいます。

映画「ブレードランナー2049」では視覚効果コンサルタント自身の視覚技術をフル活用。Microsoft Studios時代に開発したリアルタイムビジュアライゼーションシステム「Photon」は、映画「The Jungle Book」「レディ・プレイヤー1」で活用されています。また「ブレードランナー2049」向けに「Expozure」という新しいバージョンのツールも開発し、作品内のいくつかのシーンで利用がなされています。

リアルタイムレンダリングという革命

「昔はレンダリングに一晩かかってしまうのが当たり前でした。リアルタイムレンダリングは本当に革新的な技術です」

講演の冒頭、ザーガパー氏はこう語りました。かつての時代とは異なり、現代では撮影現場で撮ったそばから、監督が出来上がりに近い絵を確認することができます。照明の条件が変わった時に、衣装や小道具、背景などの他の見え方がどう変わるのかなども、今ではそれぞれのアーティストがその場で確認・変更をすることもできます。

すなわち、バーチャルプロダクションとリアルタイムレンダリングの登場は、映画制作というもののあり方を根本から覆すパラダイムシフトだったのです。

映画「Junglebook」では、2人の人間が1匹のトラを演じている場面があります。人が直立二足歩行で前後に並んで歩くと、前の人の両足がトラの前足、後ろの人の両足がトラの後ろ足の動きにリアルタイムで変換されます。

(「Junglebook」のティザー動画)

バーチャルカメラプロダクション

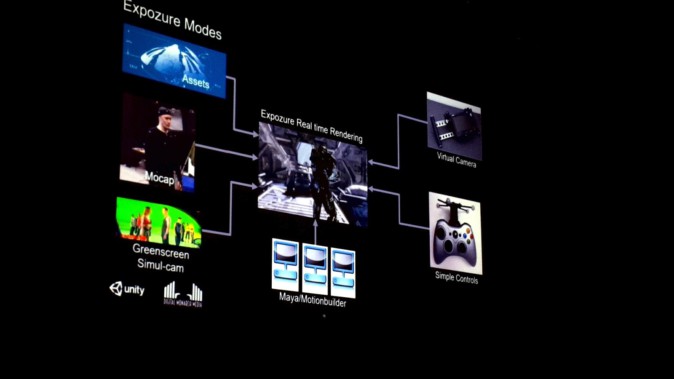

ザーガパー氏は、Unityで使える「Exposure」というビジュアルプログラミング用ツールを開発しています。これにより、モーションキャプチャやバーチャルカメラ、モーションビルダーなど、異なるツールから得られる様々なデータをまとめて取り扱うことができます。

氏は他にも、バーチャルカメラシステムの開発も手がけています。ここでいうバーチャルカメラとは、それを通じてCGでできた世界を覗くことができ、現実の物理環境にいながら、まるでCGの世界に入り込んだように撮影ができるものを指します。

バーチャルカメラを使えば、CG世界でのカメラの動きをマウスなどで操作しなくとも、現実環境で直感的に手を動かしながらカメラワークを考えることができます。従来の撮影方法であれば2週間程度かかっていた作業が、20分にまで短縮できたと氏は語ります。

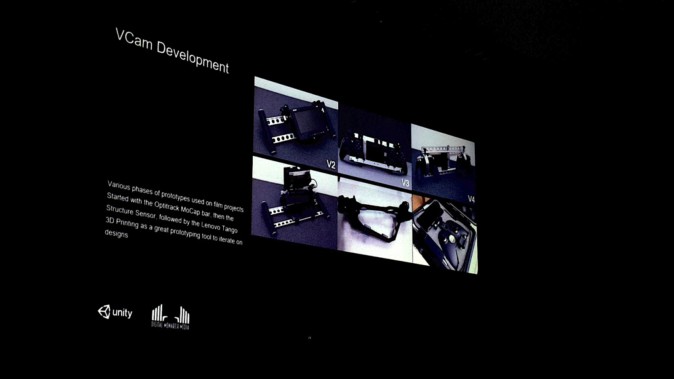

3Dプリントなどを用いて様々な試作を重ね、機能の利便性のみならず、現物のカメラの重みや慣性も表現しているそうです。映画「ブレードランナー2049」では、監督自らの手でバーチャルカメラを使ったプロトタイプを撮影し、そのカメラワークはほとんどそのまま完成版に使われたそうです。

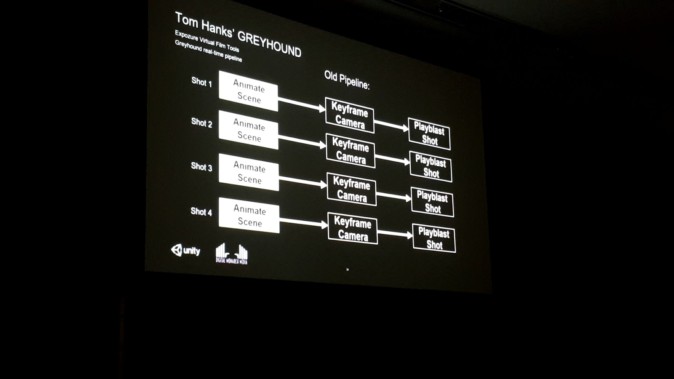

(映画「Greyhound」における工数削減の例。従来の撮影方法では、Mayaを使うアーティストが6人がかりで1日12ショットを制作していたが、一方でExposure(バーチャルカメラやリアルタイムレンダリング技術含む)を用いる方法では、2人のオペレータが実に1日300ショットを制作できるようになったそう)

[wc_row][wc_column size=”one-half” position=”first”]

[/wc_column][wc_column size=”one-half” position=”last”]

[/wc_column][/wc_row]

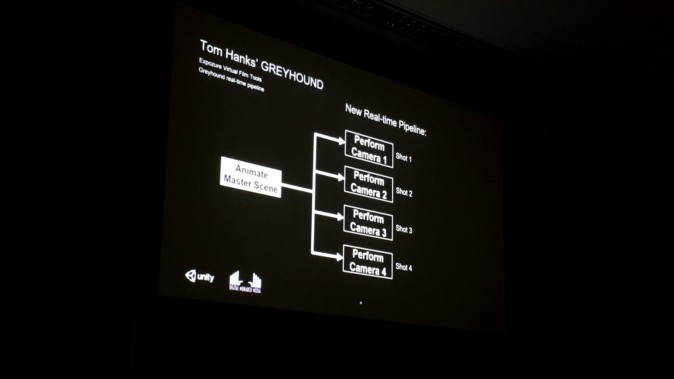

上記のように工数が削減できたのは、制作パイプラインが効率化されたため。従来の方法ではショットごとに別々のシーンを制作していましたが、リアルタイムレンダリング時代の制作では、たった1つのマスターシーンで、(カメラの位置をその都度変えたりすることで)複数のショットを作り出すことができる、と氏は語りました。

バーチャルカメラを使った撮影のデモ

講演会場でザーガパー氏は、実際に撮影で使ったバーチャルカメラシステムのデモを披露しました。

その場で「ドリーショット」の撮影に挑戦するデモです。ザーガパー氏がバーチャルカメラを持ち、カメラの角度や録画の操作をしています。それに加えて、講演を聞いていた人に専用コントローラーを渡し、カメラが動くスピードなどを制御してもらっています。

100人は入ろうかという大きな会場でしたが、このバーチャルカメラはWifiが続く限りどこまでも歩き続けることができるそうです。他にも飛行機や船などのオブジェクトにカメラを紐づけることで、「船に乗っている視点」「飛行機の後ろにつけている視点」といったカメラワークも簡単に実現できます。もちろん原物のカメラ同様、レンズセットを選んだり、シャッタースピードなどのパラメタを変更したりすることも可能です。

カメラワークをその場でゼロから(来場者と一緒に)作り、出来上がった作品がこちら。

こうしたバーチャルカメラを使った撮影では、ともすれば物理法則を無視して「やりすぎ」なカメラワークになってしまう恐れがあります。そういった問題は、バーチャルカメラのスピードの上限を設定する、カメラがドアをくぐり抜ける時はドアの大きさに注意する、コライダーを設定してカメラが壁を通り抜けないようにするなど、細かな設定に気を配っていく必要があるとのこと。

ただ、「逆にそういった物理制約を気にせず自由に撮影することで、面白いショットが得られる場合もあります。まずは撮ってみるという姿勢も悪いものではない」そうです。

「ブレードランナー2049」:スピナーから見た景色

「ブレードランナー2049」では、「スピナー」という空飛ぶ車のような乗り物が登場します。このスピナーの動きは、スマートフォンを使って実現していました。現実環境にあるスマホの位置や角度は、CG環境においてスピナーの位置や角度に反映されます。これにはGoogleのARプラットフォーム「Tango」が使われているようです。

先ほど使ったのと同じバーチャルカメラでスピナーの運転席にカメラを紐づければ、スマホを現実空間で動かすことによってスピナーを運転しているシーンが撮影できます。

(バーチャルカメラをザーガパー氏、スピナーの動きを司るスマートフォンを講演を聞いていた人が持っている)

(スピナーの座席に視点を紐付けた上で撮影したシーン)

(後編へ続く)