2018年12月4~7日に東京国際フォーラムで行われた、CGとインタラクティブ技術を扱う世界最大のイベントSIGGRAPH Asia 2018。今回もVR/AR関連の話題・展示が数多く登場しました。

[wc_row][wc_column size=”one-half” position=”first”]

[/wc_column][wc_column size=”one-half” position=”last”]

[/wc_column][/wc_row]

SIGGRAPH Asia 2018で見つけたVR/ARに関する展示について、特に技術的な新規性の見られる研究展示にフォーカスしてレポートしていきます。前記事では触覚に関する展示を選んでレポートしましたが、会場にはそれ以外にも、MRのための技術や人間の心や身体にアプローチするもの、嗅覚ディスプレイなどが見受けれました。

2016年にヘッドセットを中心とする視聴覚の提示技術のブームが起きました。現在はさらに「その先」を切り開こうとする流れが見て取れるようです。本記事では展示の中から、触覚以外の様々なVR/AR系体験ブースをレポートしていきます。

プロジェクションやMR技術

ダイナミック高速プロジェクションマッピング

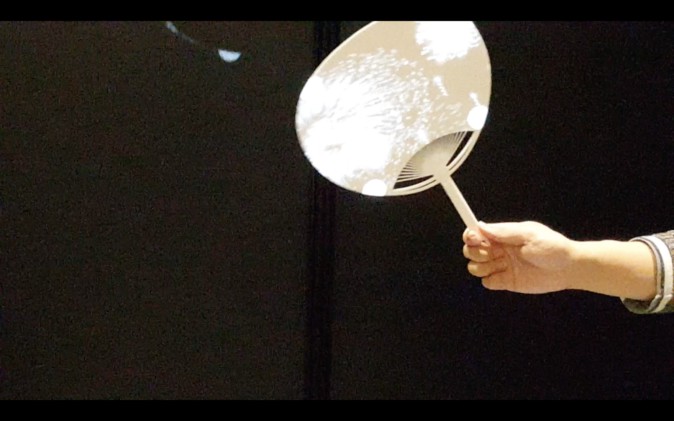

東京大学石川・妹尾研究室のプロジェクト。同研究室はこれまで、高速光軸制御系(サッカードミラー)を用いて広範囲なプロジェクションを実現し、 高速プロジェクタ(DynaFlash) を用いて衣服や顔など柔軟体の形状変形に対応し投影を実現してきました。

「VarioLight」と呼ばれるこのシステムでは、上記の2つの手法を統合することで、 広範囲に運動して、かつ回転変形する動的な対象へのダイナミックプロジェクションマッピングを可能にしています。

動画にある通り、うちわに花火(アニメーション)がプロジェクションされており、何度も打ち上がっては消えていく様子が見えます。しかしこの花火は、まるでうちわに「印刷」されたものであるかのように、うちわを素早く動かしてもブレずに追従します。

こうした技術を応用することで、スポーツやダンスなどの動きの激しいアクティビティにも、これまでできなかったような形でプロジェクション表現が可能になるだろうとのこと。

VarioLight: hybrid dynamic projection mapping using high-speed projector and optical axis controller

Yuri Mikawa, Tomohiro Sueishi, Yoshihiro Watanabe, Masatoshi Ishikawa(東京大学)

https://doi.org/10.1145/3275476.3275481

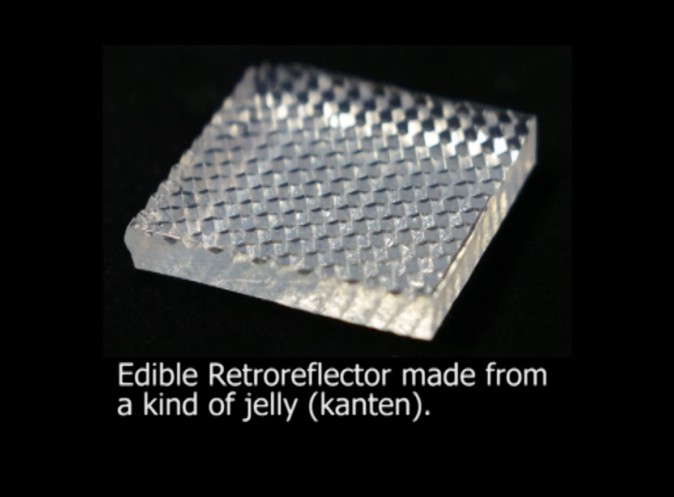

食べられる再帰性反射マーカ

ホットケーキの上端に載せられた透明な直方体は、これは寒天などからできており、食べることができます。再帰性反射(※)するような表面加工を施すことで、プロジェクションマッピング用のマーカとして使っています。いわば、食べ物による食べ物のためのマーカ。群馬大学奥研究室のプロジェクトです。

(※再帰性反射……鏡面反射や乱反射とは異なり、光を光源の方向へそのまま戻す反射。交通安全のための反射板などに使われている)

デモブースでは、ホットケーキの上に動くキャラクターが投影されており、皿を動かしてもホットケーキ上の同じ位置に留まる様子を見ることが出来ました。

[wc_row][wc_column size=”one-half” position=”first”]

[/wc_column][wc_column size=”one-half” position=”last”]

[/wc_column][/wc_row]

またこの再帰性反射マーカ、同意書を書くことで本当に食べさせて頂くことができました。砂糖も入っており、甘くて美味しかったです。食材・料理の特定位置にプロジェクションしたい場合、カメラなどで認識できるマーカを取り付けることで、位置合わせが簡単になります。

Edible projection mapping

H. Oku, M. Nomura, K. Shibahara, A. Obara(群馬大学)

https://doi.org/10.1145/3275476.3275486

手の中のモノにプロジェクションマッピング

三次元物体の表面に、マーカレスで(物体に何も取り付けることなく)プロジェクションマッピングを可能にする研究です。例えば上の写真では、本来は白くのっぺりした物体に、人間の顔を(凹凸などを考慮して)プロジェクションすることで人間の顔を実現しています。電気通信大学橋下研究室のプロジェクトです。

事前に物体の3Dモデルを入力しておく必要がありますが、そのおかげでターゲットとなる物体の位置や向きを求める処理が高速化されています。IRカメラで物体の輪郭だけを抽出し、その輪郭が物体のどこから眺めたときに得られるものなのか推定した後、天井から吊るされたプロジェクターで投影しています。

Tangible projection mapping: dynamic appearance augmenting of objects in hands

Yuki Morikubo, Eugene San Lorenzo, Daiki Miyazaki, Naoki Hashimoto(電気通信大学)

https://doi.org/10.1145/3275476.3275494

Augmented Virtuality、現実のモノをバーチャル空間へ

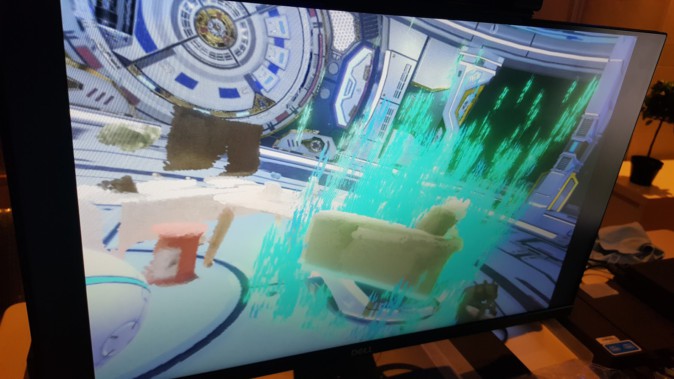

ソニー・インタラクティブエンタテインメント(SIE)は、バーチャル環境に現実の物体を持ち込む技術(※)の展示をしていました。

※バーチャル環境と物質的な現実環境の融合は、Mixed Reality=MR(複合現実感)と呼ばれます。ただ、バーチャル環境に物理環境のモノを取り込むための技術は、特にAugmented Virtualityと呼ばれます。

また机や椅子などのCGデータを学習させたモデルを作り、取り込んだ物体が何であるのかを認識することも出来るそうです。上記写真では、椅子である物体にはchair、植物である物体にはplantと名前が振られています。

[wc_row][wc_column size=”one-half” position=”first”]

[/wc_column][wc_column size=”one-half” position=”last”]

[/wc_column][/wc_row]

展示ブースに置いてあった椅子や机、Kinectを用いて当日その場でスキャンしたそうです。PlayStation VRを被ると、近未来的なステージに、現実の椅子や机が出現します。またモノを指定すると、その姿をCGで置き換えてしまうこともできます。

Space Fusion: Context-Aware Interaction Using 3D Scene Parsing

RGBカメラ撮影→点群データ化→AIにより自動でタグを付与(リアルタイム)

VR内では背景をCGに入れかえて

キャラとインタラクティブな体験ができる

つまり電脳コイルhttps://t.co/EqJddJuXwK#SIGGRAPH2018Asia pic.twitter.com/9Nps25dcm5— kure (@kure_kure_zo) 2018年12月7日

Space fusion: context-aware interaction using 3D scene parsing

Hiroyuki Yabe, Daichi Ono, Tsutomu Horikawa(ソニーインタラクティブエンタテインメント)

https://doi.org/10.1145/3275495.3275498

心と身体、没入感

抱くと落ち着くクッション

落ち着いた呼吸のリズムに合わせてクッションが膨らんだり縮んだりすることで、抱きかかえている体験者にリラックスした呼吸を誘発するデバイス。

(クッションを抱えてリラックスしているセッション登壇者(@shigeodayo))

呼吸を適切に制御することは、感情や身体の制御に対して重要です。例えば緊張状態にある時、人は呼吸が浅く早くなります。近年では適切な呼吸を促すアプリケーション(例えばライトの明滅でタイミングを教えてくれるなど)が開発されています。

一方この研究が取り組んだのは、体験者が無意識に、かつトレーニングしなくとも適切な呼吸リズムを促すことのできるシステムです。クッションが膨らむとお腹に圧迫感が提示されます。実際にクッションを抱きかかえてみると、それがまるで自分の身体の一部であるかのように感じ、確かに無意識にクッションの膨らみにつられて自分も深く呼吸をしてしまいました。

自分のリラックス時の呼吸より少し早いと申し出ると、クッションの収縮リズムを調節してくれました。なおこちらの展示は、committee(審査員)の投票で一位を獲得し、Emerging technologiesアワードを受賞しています。

Relaxushion: controlling the rhythm of breathing for relaxation by overwriting somatic sensation

Yuki Ban, Hiroyuki Karasawa, Rui Fukui, Shin’ ichi Warisawa(東京大学)

https://doi.org/10.1145/3275476.3275492

動く壁が没入感を上げる

平面のディスプレイでの映像体験において、三次元の空間性や没入感を高めるために、ディスプレイをインタラクティブに動かしてしまおうという研究です。ブースではドライブシミュレーターのような、自動車を運転する体験ができました。

アクセルを踏み込むとディスプレイは奥へと下がり、加速度感を際立たせます。カーブするときはディスプレイの角度が変わり、ブレーキを踏めばディスプレイはまた手前に寄ってきます。

(このディスプレイの動きを実現しているのは、まさかのお掃除ロボット「ルンバ」)

パイロットスタディ(本実験に向けて事前に行う規模の小さい実験)では、このシステムがコンテンツの表現力や臨場感を高められることが示されたそうです。

The living wall display: physical augmentation of interactive content using an autonomous mobile display

Yuki Onishi, Yoshiki Kudo, Kazuki Takashima, Anthony Tang, Yoshifumi Kitamura(東北大学 電気通信研究所)

https://doi.org/10.1145/3275476.3275489

傘をバサバサして幽体離脱(?)

傘をバサバサ開閉すると幽体離脱ができるという体験です(!?)。

今回の展示では、体験者は寝転がりながら傘を開閉します。傘を開いた瞬間、寝転がっている自分を上から見下ろす幽体離脱視点に切り替わり、空中に押し出されます。傘を開いている間は徐々に落下し、傘を閉じると元の寝転んで天井を見上げている自分の視点に戻ります。

寝転がった体勢では、視点が180度回転して天井から地面を見下ろす(重力と同じ)方向に変わっても、あまり違和感を覚えないのが不思議です。

さらに傘を開くという行為、そしてそれに伴う感覚(傘を押し出すインパクト、発生する風圧、音など)が、幽体離脱するという本来なら不自然な現象への納得感を補っているのだそうです。

名古屋市立大学芸術工学部・小鷹研究室のプロジェクトです。小鷹研究室の他の研究では、VRコンソーシアムが主催のVRクリエイティブアワード2018で「Elastic Arm Illusion」がファイナリストにノミネートされるなど。「からだの錯覚」をテーマに、不思議な身体体験を研究しています。

Self-umbrelling turns over subjective direction of gravity

Kenri Kodaka, Koyo Mori(名古屋市立大学)

https://doi.org/10.1145/3275495.3275508

誰かの顔を操って……!

Xpressionは、ビデオの中の人の表情を自分の表情で乗っ取り、リアルタイムに動かせるAR系のスマホアプリです。例えばトランプ大統領の動画を使うと、自分の表情がトランプ大統領の顔に反映され、トランプ大統領の顔を自由に操ることができるといった具合です。

iOS版アプリが既に公開されています。制作を手がける株式会社EmbodyMeは、他にも写真の顔を使って3Dアバターを生成できる『EmbodyMe』もリリースしています。

VRクリエイティブアワード2018でファイナリストにノミネートされています。

Xpression: mobile real-time facial expression transfer

Toby Long Hin Chong, Issay Yoshida(株式会社EmbodyMe)

https://doi.org/10.1145/3275476.3275477

嗅覚ディスプレイ

香りの切り替えが素早い、嗅覚ディスプレイ

[wc_row][wc_column size=”one-half” position=”first”]

[/wc_column][wc_column size=”one-half” position=”last”]

[/wc_column][/wc_row]

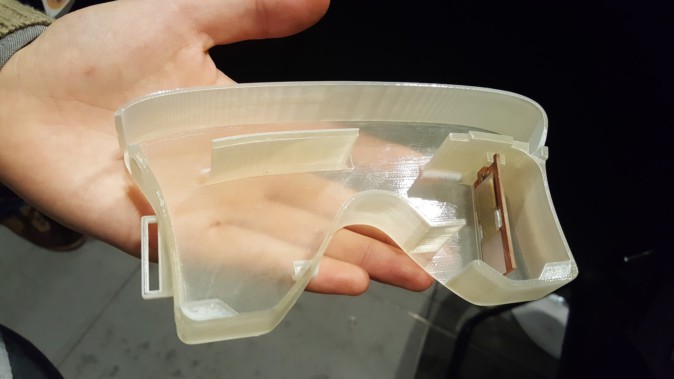

こちらの展示をしていた東京工業大学中本研究室では、嗅覚ディスプレイ、匂いセンシングなどの技術に関する研究が盛んです。今回展示していたのは、匂いの切り替えを素早く正確に行う嗅覚ディスプレイシステムです。

写真右側が嗅覚提示部分の構造です。半透明な容器の右隅に、何やら長方形の板のようなモジュールが見えます。SAWとも呼ばれるこのモジュールは、特定周波数の電圧をかけることで表面に波を発生させることができます。ここに液滴を垂らすと、微小な振動によって液体が微小な水滴になり(霧化)、空気中へ漂います。

このようにして発生した匂いの霧は、鼻の右側にある空洞から出て嗅覚刺激を提示します。人間が吸わなかった分の霧は、反対側(鼻の左側)にある穴に吸い込まれる構造です。この仕組みによって空気中に残り香が生じにくく、前の匂いに邪魔されることなく匂いを切り替えることが可能となっています。

液体を高温にして気化させるシステムも存在しますが、顔のすぐ近くに高温のモジュールを取り付けるのは少し怖いというのが人情。このシステムではそういった危険性もありません。

デモでは、バーチャル空間で3種類の香りを自由に嗅ぎ分ける体験ができました。確かに一つ前の香りは次の香りの提示時にはほとんど感じられませんでした。

ただ、ヘッドセットを装着して以降、常に香料の匂いがしていました。これは嗅覚提示部の中から漏れ出た匂いではなく、香りの霧が出てくる空洞の淵に付着してしまった匂いとのこと。気体や霧を射出するタイプの嗅覚ディスプレイでは、デバイス自体に香りが付着してしまう問題はなかなか解決するのが難しいのだとか。

Demo of olfactory display with less residual odor

Shingo Kato, Takamichi Nakamoto(東京工業大学)

https://doi.org/10.1145/3275476.3275493

天井から空間に嗅覚を提示

天井に吊るしたデバイスには、4種類の香りをセットできるタンクが備え付けられています。VRヘッドセットと連動して、シーンにふさわしい香りを霧として射出することができるシステムです。国立台湾大学らが進めているプロジェクト。

[wc_row][wc_column size=”one-half” position=”first”]

[/wc_column][wc_column size=”one-half” position=”last”]

[/wc_column][/wc_row]

VRヘッドセットをかぶると、どこでもドアのような不思議なドアをくぐるたびに春夏秋冬と季節が移り変わるシーンで、その景観にふさわしい香りを感じることができました。春は桜が咲いており、夏は緑が生い茂り、秋は紅葉が美しく、冬は冷たい雪が降る……。

ヘッドセットの下部にファンが取り付けられており、空気中に射出された香りのミストを巻き込んで鼻に提示する役割を果たしています。ほのかに感じられる花や草の香りは、作り物らしさがあまりなく、景色への没入感や得られる感動をグッと高めてくれました。

https://twitter.com/kure_kure_zo/status/1070564109882601472

Lotus: enhancing the immersive experience in virtual environment with mist-based olfactory display

Yang-Sheng Chen*, Ping-Hsuan Han*, Kong-Chang Lee**, Chiao-En Hsieh*, Jui-Chun Hsiao*, Che-Ju Hsu**, Kuan-Wen Chen***, Chien-Hsing Chou**, Yi-Ping Hung****(*National Taiwan University, **Tamkang University, ***National Chiao Tung University, ****Tainan National University of the Art)

https://doi.org/10.1145/3275495.3275503