国内最大級のVR/AR/MRカンファレンス「XR Kaigi」が今年も開催されました。今年の「XR Kaigi 2022」はオンラインカンファレンス(12月14日~16日)と、東京都立産業貿易センター 浜松町館でのオフライン(12月22日・23日)のハイブリッドで実施。オンライン開催では、3日間の期間中に60のセッションが行われました。

今回はその中から、12月15日に行われたセッション「ちいさくて、かるい、モバイルモーションキャプチャ―『mocopi』」をレポートします。登壇者は、ソニー株式会社(以下「ソニー」)新規ビジネス・技術開発本部 モーション事業推進室 室長の相見猛氏とプロダクトマネージャーの南翔太氏、そして技術責任者の徳野行太氏の3名です。こちらのセッションでは、話題のモバイルモーションキャプチャー『mocopi』の紹介が行われました。

スマホ1台と数個のセンサーでモーションキャプチャーを実現する『mocopi』

冒頭で、今回の主題であるモバイルモーションキャプチャー『mocopi』のプロモーションビデオが流された後、相見氏より同製品の紹介が行われました。

ソニーは、2022年はメタバースに取り組んでおり、そのひとつとしてリアルとバーチャルの垣根を越えた製品開発や試作を行ってきました。今回はその中から、モーションキャプチャーデバイス『mocopi』の紹介が行われました。

『mocopi』は、「従来のモーションキャプチャーとはまったく異なる革新的な製品」だと相見氏はいいます。一般の人にとってモーションキャプチャーはかなりハードルが高いものでしたが、『mocopi』を使えば、1台のスマホと数個のセンサーだけで、誰でも簡単に全身の動きをキャプチャーできます。

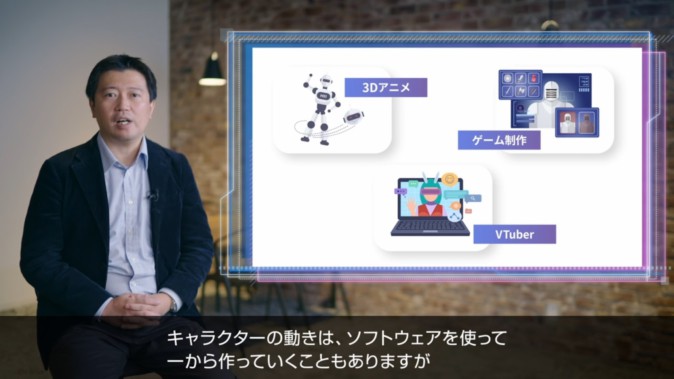

モーションキャプチャーとは、人体の動きをデータ化する技術です。主に、3Dアニメなどでキャラクターの動きを作るときなどに使われています。ソフトウェアだけでキャラクターの動きを作ることもありますが、ほとんどのケースでは、人体の動きをキャプチャーして作られています。

モーションキャプチャーには、大きく分けて3つの方式があります。ひとつ目は「光学式」。スタジオで専用のスーツを着て、室内に取り付けられた何台ものカメラで演者の動きを撮影する方式です。高精度に動きをキャプチャーできますが、設備が複雑で、費用も高額になりがちです。

ふたつ目は「ビデオ式」です。身体の動きや骨の動きを、動画から推測して抽出する方式です。

みっつ目は「慣性センサー式」です。加速度センサーやジャイロセンサーなどで身体の各部の動きを測定して、全身の動きを構成するという方式です。

『mocopi』は、慣性センサー式を採用していて、他のふたつの方式と比較して、比較的簡単な構成でモーションキャプチャーが行えます。

シンプルな構成が『mocopi』の強み

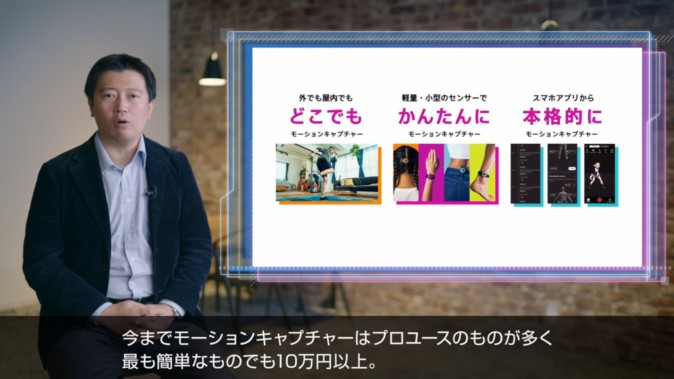

『mocopi』の強みは、シンプルな構成です。これまでは、モーションキャプチャーといえばプロユースのものばかりで、簡単なものでも10万円以上の予算が必要でした。それに加えて、高価な高性能PCやセンサーのデータを受け取るセンサー、カメラなども必要でした。

『mocopi』なら、スマホとセンサーだけでモーションキャプチャーを実現できます。コストや複雑さといった課題を解決しています。

なぜこのような技術を実現することができたのでしょうか? 相見氏がいうには、ソニーグループには、映画やゲームなどのエンタメコンテンツ制作で培った、モーション撮影の知見やデータが豊富にあったからです。

それらを活用した独自の機械学習アルゴリズムを採用することで、スマホ内の計算資源だけで、全身の動きを高精度で取得できるようになったのです。

映像制作やメタバースなど様々な用途で活用できる

続いて、プロダクトマネージャーの南氏から、『mocopi』の構成と機能について紹介が行われました。

『mocopi』は6点のセンサーを後頭部と両手首、腰、両足に装着して使用します。それぞれに内蔵された、加速度センサーとジャイロセンサーでデータを取得しています。

センサーから取得した値をもとに、スマホアプリ側の機械学習アルゴリズムで計算して、全身の動きを構築。好きなアバターに被せて、同じように動かすことができます。

アバターの動きは、動画として録画したり、モーションデータ自体をスマホに保存することもできます。モーションデータを映像編集サービスで利用するために、PCなどの外部機器にリアルタイムに伝送することも可能です。

南氏は、『mocopi』の開発に当たって、ソニーだからこそ実現できたことが3つあるといいます。ひとつ目は小型軽量のハードウェア設計です。競合商品の中でも、圧倒的な軽量化と装着性を実現しています。

ふたつ目は、独自の機械学習アルゴリズムを活用したモーション構築ソフトウェアです。少数のセンサーとスマホの計算資源だけで、一般的なモーションデータの精度を担保することが可能となりました。

みっつ目は、コンテンツ・クリエーションとの親和性です。グループ会社のソニー・ミュージックエンタテインメントなど、エンタメ領域の社外パートナーたちと多岐にわたる連携を行い、様々なフィードバックをもらっています。

『mocopi』のユースケースは、VTuberや3D映像制作、そしてメタバース領域です。とくに、メタバースを自由に闊歩するためのデバイスになると南氏は考えています。モバイルで実現しているからこそ、映像制作者には屋外やワンペ(編注:紙1枚(one paper)の和製ビジネス英語。この発表ではごく簡潔な企画であることの喩え)での制作に活用してもらいたいそうです。

開発者向けにSDKとソフトウェア開発キットも提供

続いて、SDKとソフトウェア開発キットについて、技術責任者の徳野氏が説明しました。

『mocopi』を使って新しい体験ができるように、サードパーティや個人のクリエイターが使えるSDKが用意されています。ひとつ目は、『mocopi』で生成したモーションデータを受け取ることが出来る「Receiver Plugin」です。

「Receiver Plugin」を使うことで、別のソフトウェアで取得したモーションを編集したり、外部サービスと連携できるようになります。現時点ではUnityとMotionBuilder、バーチャルモーションキャプチャーと接続するプラグインが用意され、連携先サービスにはRokoko Studioなどがあります。

ふたつ目は「Mobile SDK」です。iOSとAndroidに対応しています。現在対応しているのはソニーの『mocopi アプリ』だけですが、開発者に「mocopi センサー」を使った様々なアプリを作ってほしいと徳野氏は考えています。

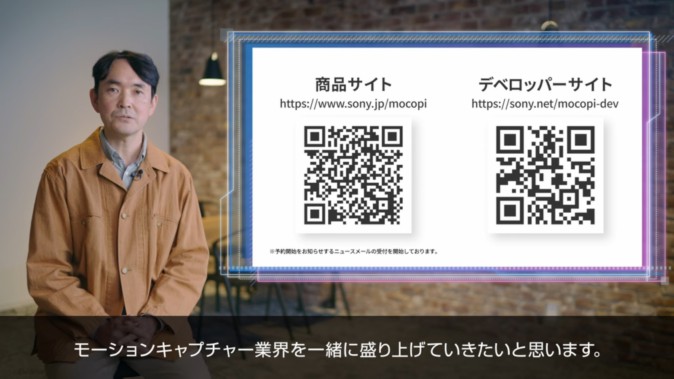

『mocopi』の公式ホームページには予約ページも用意されています。デベロッパーサイトでは、「Receiver Plugin」もダウンロード可能です。SDKで開発したサービスやコンテンツを使ってビジネスをしたい人のために、法人用ライセンスも用意されています。

VRChatや『バーチャルマーケット』でも使用可能に

続いて、VRChat CT兼共同設立者のジェシー・ジョードリー氏がビデオメッセージで登壇。「市場には様々なVRヘッドセットが登場していますが、『mocopi』と組み合わせて、VRChatのフルトラッキング機能を存分に体験してもらいたいです」と期待を寄せました。

最後に相見氏は、『mocopi』は発売時点でVRChatで利用できるほか、HIKKYとの連携も進行しており、『バーチャルマーケット』でも使用可能になる予定だと紹介し、セッションを締めくくりました。