12月3日にベルサール九段にて開催されたVR関連開発者向けイベント「VIVE JAPAN デベロッパー ミートアップ 2018」。本イベントの「バーチャルYouTuberセッション」では、VIVEの活用事例の紹介という形で、様々なバーチャルYouTuber(VTuber)関連企業が参加しました。

今回は、グリーグループの株式会社Wright Flyer Live Entertainment(以下WFLE)の「ゼロから作るVTuber専用スタジオ – モーションキャプチャー編 –」と題したセッションをレポートします。また、本講演の全編を収録した動画はこちらから。

WFLEはVTuber専用ライブ配信アプリREALITYを運営しており、株式会社イードと共同でゲーム情報番組を開始、「ゲーム部プロジェクト」「道明寺ここあ」の運営事業との提携などを発表しています。筆者・佐藤ホームズもいちVTuberとして注目し、この度聴講に参加しました。

講演は同社のVTuber専用スタジオ「REALITY STUDIO」の紹介からスタート。講演者はWFLEのPresenceTechnology Group シニアマネージャー、渡邊匡志氏です。REALITYではVTuberグループ「にじさんじ」のJK組(月ノ美兎さん、樋口楓さん、静凛さん)など様々な人気VTuberが配信を行っており、収録と生放送でVTuberが共演可能なスタジオを用いているとのこと。3Dギフトによって視聴者と交流する機能もありますが、今回メインで語られたのは題名にもある通り「モーションキャプチャー」の部分。本記事もこちらにフォーカスしていきます。

ゼロからVTuberスタジオを作るために

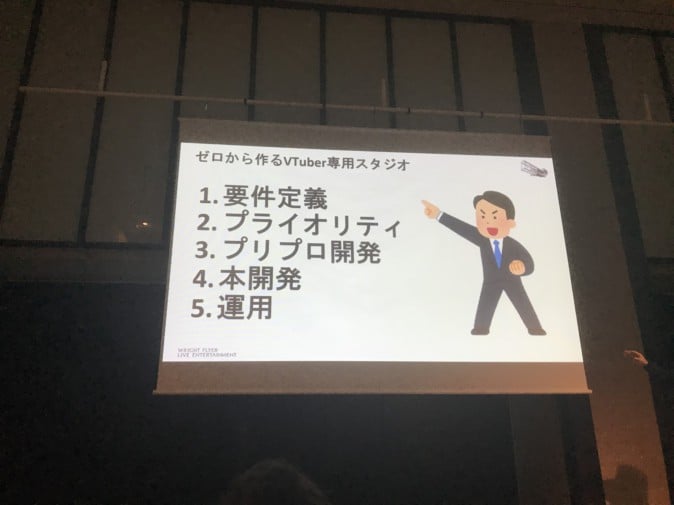

さて、ここからが本題。講演テーマでもある「ゼロからVTuber専用スタジオを作る」ための工程として、

1.要件定義

2.プライオリティ(優先順位)

3.プリプロ開発(事前開発)

4.本開発

5.運用

が挙げられました。

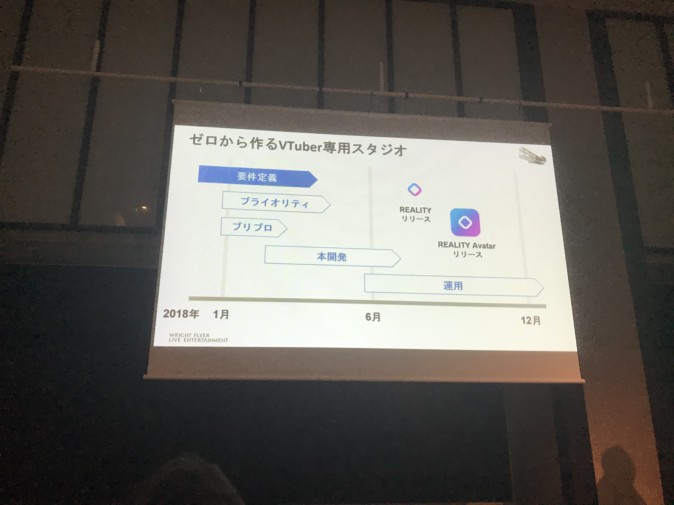

上図のように、要件定義を丁寧にやっていく中で、優先順位の決定やプリプロ開発を同時並行で進めていったとのこと。これらの工程を一つずつ順番に見ていきます。

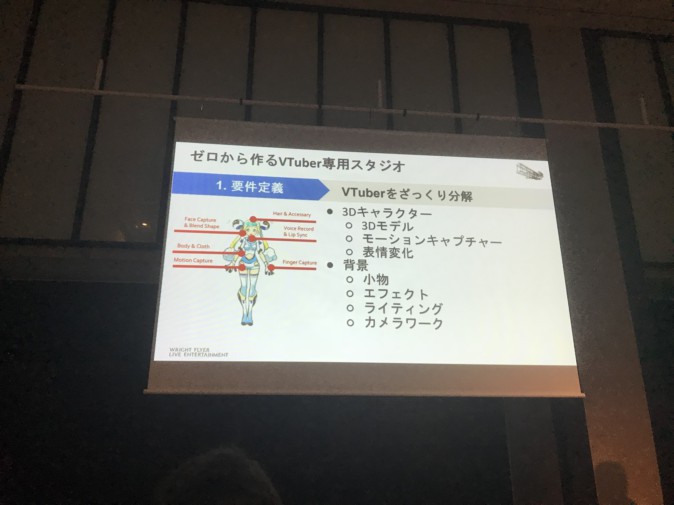

1.要件定義

今回、WFLEは文字通り「完全にゼロ」からVTuber専用スタジオの構築をスタートしています。したがって、そもそも「まず何が必要なのか」を知る必要があり、VTuber配信はどのような要素でできているのかを分解・分類するところから始まりました。

結果、大きく分けて四つのシステムである、

・キャラクター制作

・ゲームエンジンの選定

・キャプチャークオリティの合意

・REALITY Platform(=配信プラットフォーム)

が必要になったとのこと。特に「キャプチャークオリティの合意」に関しては人によって認識の相違が起きやすい部分であり、「新しい領域の事業だからこそ大事」と語りました。

2.プライオリティ

まず、要件定義で必要だと分かった四つのシステムについて優先順位を決定するため、2018年1~3月当時のVTuberを多数チェック。講演内ではキズナアイさんと「八月のシンデレラナイン」の有原翼さんのコラボ、アズマリムさん、富士葵さん、東雲めぐさんらが挙げらました。特にキズナアイさんと有原翼さんのコラボは「共演の明確なイメージだ」と感じたそう。

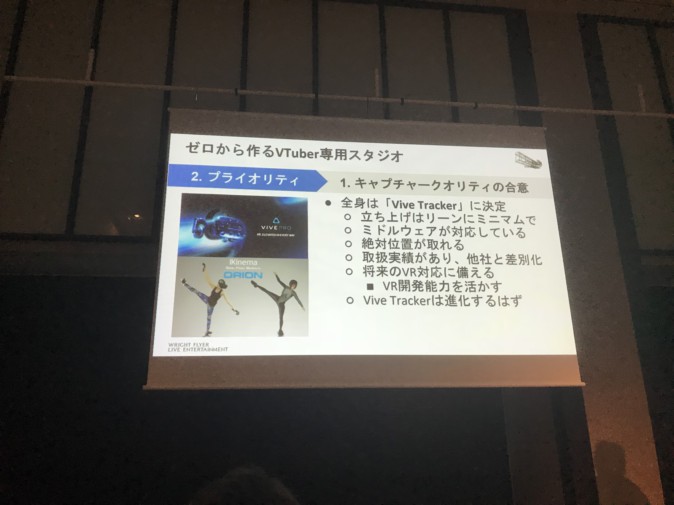

まずキャプチャークオリティのイメージを決定した所で、モーショントラッキング用ツールの選定に入ります。「Perception Neuron」、「Xsens MVN Link」「Vicon / OptiTrack」が候補に上がる中で、全身のトラッキングには「VIVEトラッカー」を使用することが決定。

「Xsens MVN Link」は多くのセンサーを保持・可搬性・複数人対応などの面で有力候補でしたが、ライセンスとスーツで一着あたりが高額で、初期コストとしては高価だということで却下。「Vicon / OptiTrack」も有力候補だったものの可搬性に難があり、やはり初期コストの高さもあって却下されたそうです。「初期からいきなり高い投資をするのではなく、ミニマムにできることから積み上げていくのが大事」と語りました。

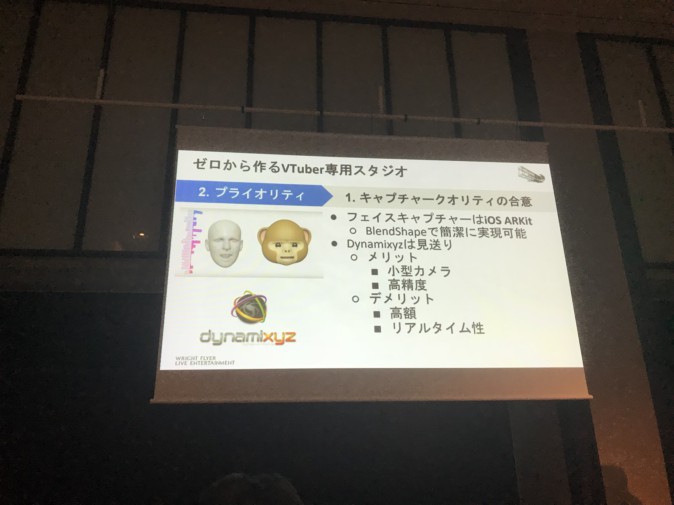

フェイスキャプチャーにはiOSの「ARKit」を使用。「Dynamixyz」などはリアルタイム性に欠ける部分があり見送ったとのことです。

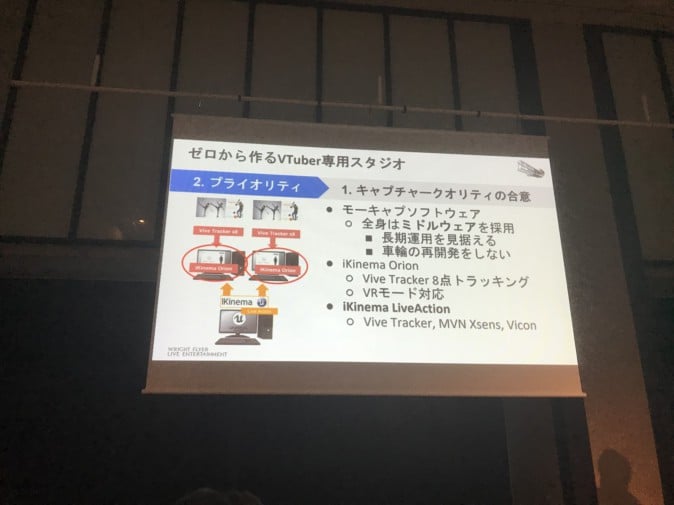

全身のモーションキャプチャー(モーキャプ)ソフトウェアには「iKinema」のものを採用。「iKinema Orion」に加えて「iKinema LiveAction」を使用している。「iKinema Orion」がモーションデータを送り、「iKinema LiveAction」が解決しているため、モーションキャプチャーデバイスに幅広く対応している「iKinema LiveAction」は、運用に置いて重要であるようです。

さらにフェイスキャプチャー用のモーキャプソフトウェアには無線(現在はUDP)で「Unreal Engine 4」と接続する自作のものを使用。当時はそうした実績あるツールも少なく、いっそ作ってしまおうということで自作が決定したとのこと。

そしてキャプチャークオリティについて概ね合意したところで、ゲームエンジンの選定に入ります。グリーではずっと「Unity」を使用していたのでそのまま決定……するかと思いきや、「iKinema」との兼ね合いで「Unreal Engine 4」に決定。現在は「iKinema」の「Unity」への対応は進んでいるが、当時としては時間を優先して「Unreal Engine 4」を採用しています。流れの速いVTuber業界ならではの選択だと言えるでしょう。

次はゲームエンジンも決まった所で、キャラクター制作へ移行。現在はVRM(3Dアバター向けの汎用ファイルフォーマット)への対応も進んでいるようです。

さらに、「Unreal Engine 4」でアニメ調の絵作りをする必要があるため、デフォルトで有効になっている設定を外すことからはじめています。キャラクターのルックについては課題が多く、キャラクターの絵作りの部分は来年1月からスタッフが増強され「グッと良くなる」と渡邊氏。来年以降のREALITYの配信は絵作りに注目して見てみると面白いかも。

また、「Level Blueprint」の設定で基本的な運用を行っているそうです。キャラクターの入れ替えはPluginで行っているとのこと。

ここまでは見てきた通り、まずどれくらい動かすかの認識の合意をし(キャプチャークオリティの合意)、キャラクターを動かすためにどういうエンジンを使うか決定(ゲームエンジンの選定)、キャラクターを作りつつ(キャラクター制作)、複数のVTuberが出演するためのフォーマットを作る(REALITY Platform対応)という流れで進行しています。

次はプリプロ(事前開発)の流れを見ていきましょう。

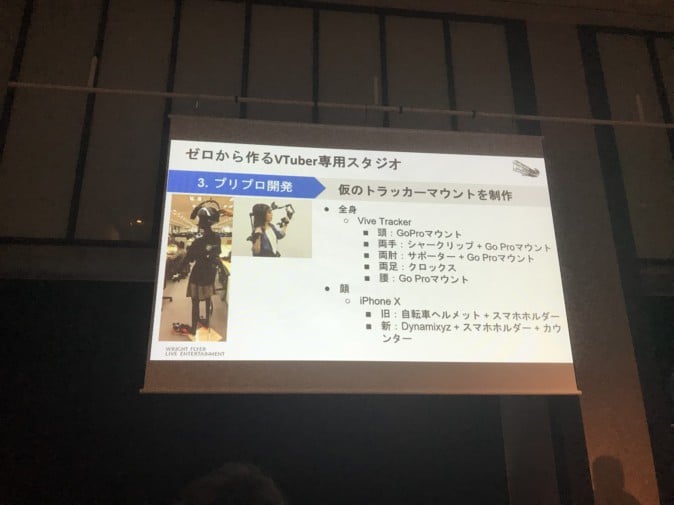

3.プリプロ開発

最初はキャラクター・背景・小物が表示可能で、2、3人のVTuberが共演可能、簡易的なギフト機能がある所までの制作期間は2か月ほどで制作したそうです。

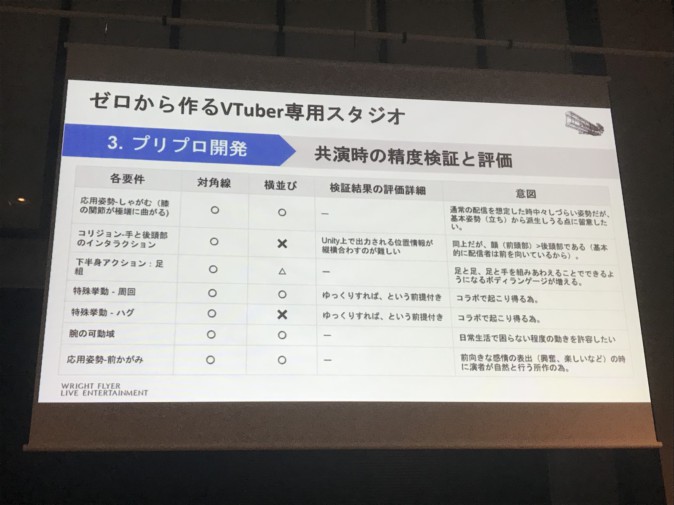

REALITYでは特にVTuberの共演を重要視しており、共演時のモデルの挙動について、上図の他にも50項目以上の要件について検証したとのこと。

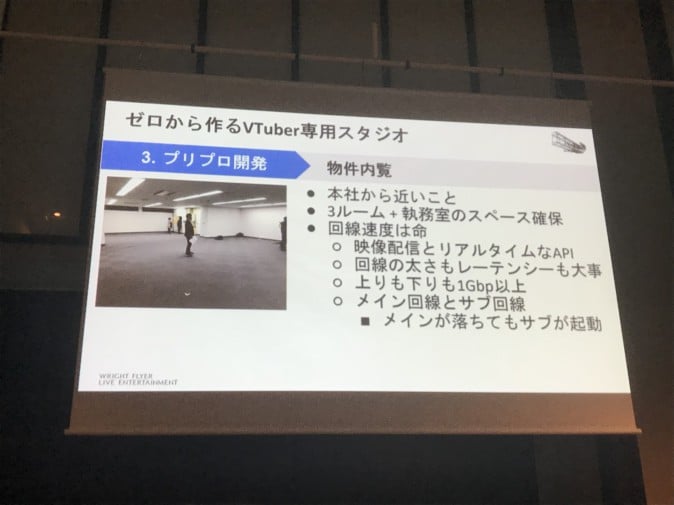

また、設営するスタジオの概観は3Dモデルでアウトプット、それを元に構築しています。現在の様子とは若干違うものの、おおまかなイメージ図があるだけでも作業しやすさは変わってくるとのこと。

もちろん物件を実際におさえるのも重要。回線速度や保険となるサブ回線の有無は映像配信を行う上で命と言えるでしょう。

4.本開発

そしてプリプロ開発も終わった所で、本開発が開始。物件工事が終わってから1、2か月ほどの期間で行ったとのこと。

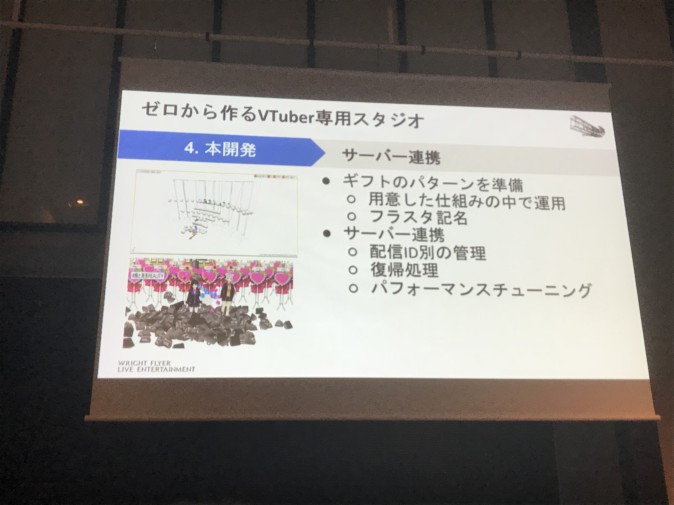

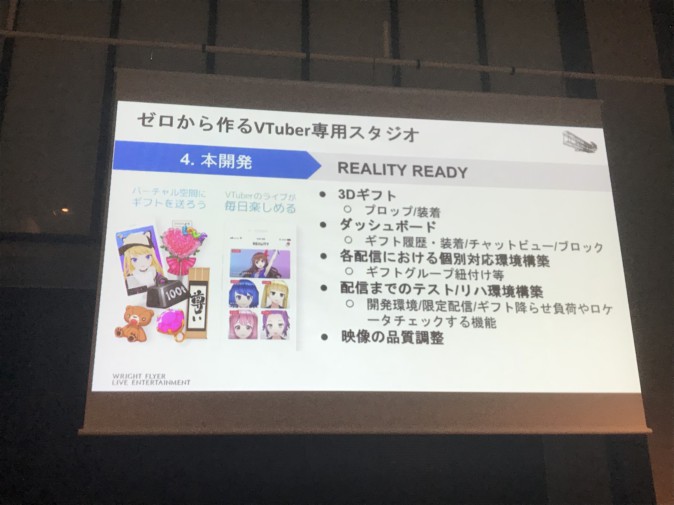

REALITYの主な機能の一つであるギフトについては、スタジオ・サーバー連携の仕組みを構築。樋口楓さんと月ノ美兎さんの「楓と美兎」コラボ配信が史上最多ギフト数だったそうですが、上図のように、これくらい大量にギフトが投げられても大丈夫な仕組みにしているそうです。

さらにREALITY READYと題された、「これらに対応しておけばREALITYでの配信が可能になる」項目があり、REALITY Platform対応に必要なものが洗い出されています。

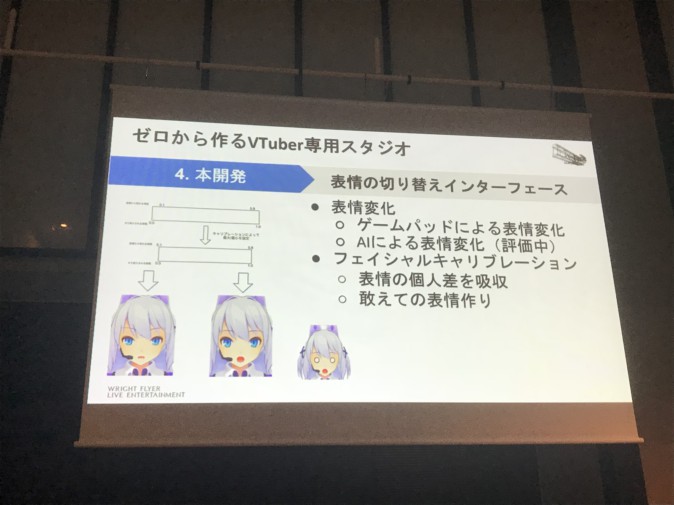

さらに、キャラクターの表情変化についても本格的に着手。VTuberによって異なる表情変化をキャリブレーションするほか、目を大きく開いたときに白目を表示するなど「敢えて」の表情作りを行っているそう。ここはプライオリティの項目でも触れられていた、アニメ調の絵作りにも通ずる所があるように感じられます。

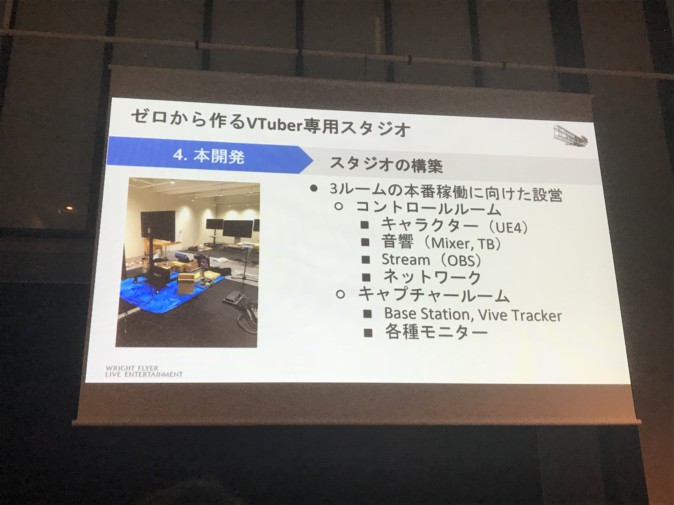

そして本運用に向けて、スタジオも構築。コントロールルームには必要なネットワークシステムを、キャプチャールームにはベースステーションなどのキャプチャー用機器を設置。複数ルームの運用を想定しての設営となりました。

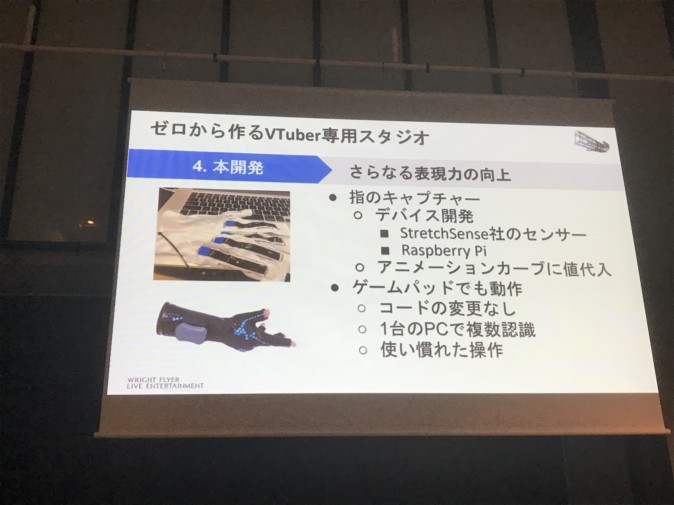

そして表現力の向上のため、指のキャプチャーも試行錯誤。グローブが無い状況や複数認識に対応し、ゲームパッドでも動作するようにしているそうです。

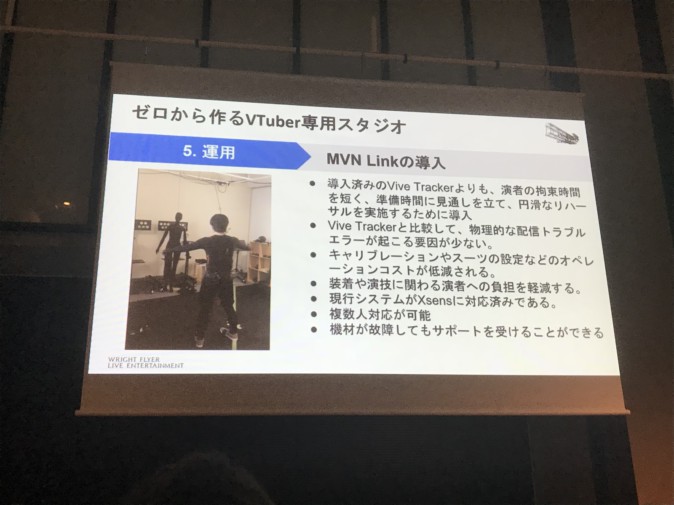

5.運用

そして本開発が一通り終わり、8月7日にREALITYがリリース。いよいよ運用段階に移行してからの話となります。

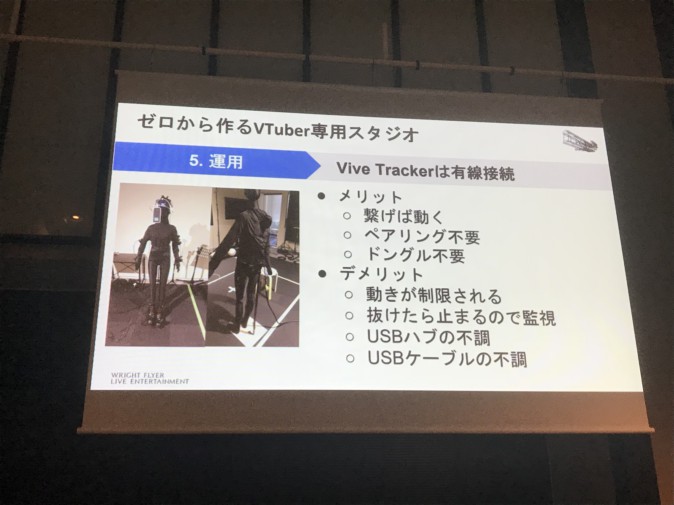

実際に運用してみると、「VIVEトラッカー」は無線接続では認識がぶれるため、有線接続することに。ケーブルが抜けると動作停止するものの、逆に「接続さえすれば動く」というメリットとして捉えることも可能です。デバイス同士のペアリングも不要ではありますが、今度はUSB周りの不調をうまく検知・切り分けするための注意が必要とのこと。

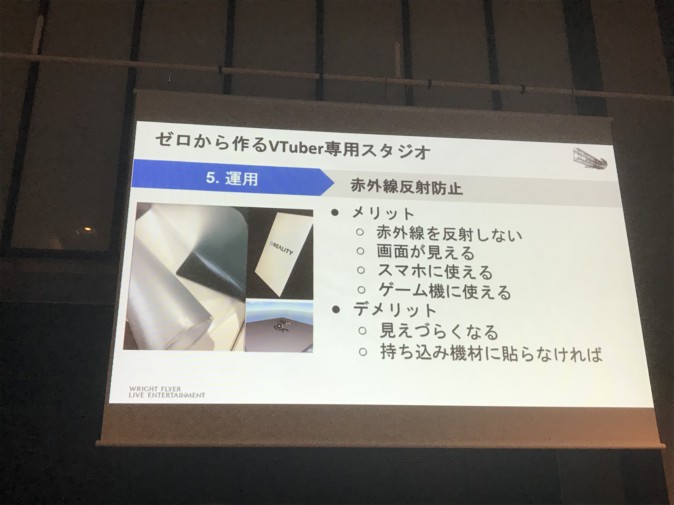

また赤外線の反射を防止するため、モニターや台本、カンペにまで反射防止シートを貼って対策。徹底しています。

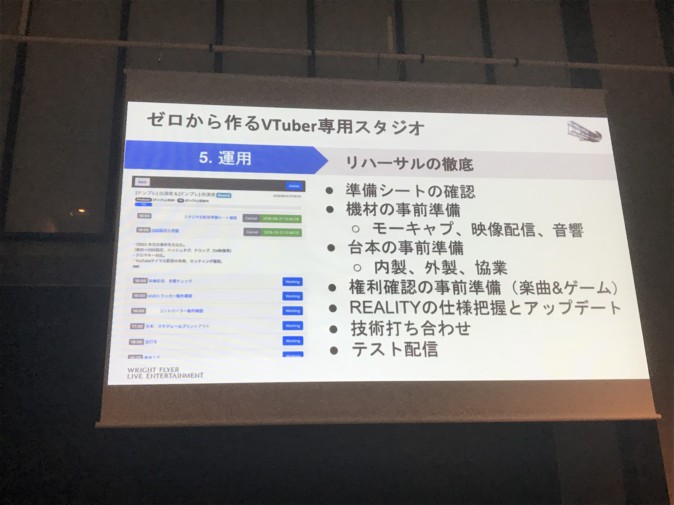

システム運用とはやや離れる話だが、リハーサルは徹底している。配信の1時間前には必ずリハーサルを行っており、生配信だからこそ事前確認を重要視しているようだ。

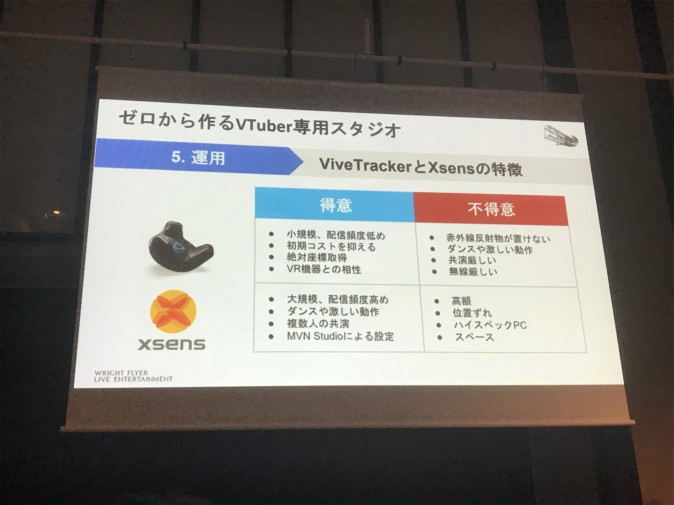

また運用する中で、トラッカーについても検証。改めて「VIVEトラッカー」は初期コストが抑えめで、1人で配信をするのであれば始めやすいが、REALITYのように複数人が共演する環境には不向きな面があるそうです。

そして現在は「VIVEトラッカー」と「Xsens MVN Link」を併用しているとのこと。「MVN Link」は「VIVEトラッカー」に比べて演者の拘束時間が少ない、VTuberの複数出演に対応可能であるなどの利点が多く導入したとのこと。

最後にiPhone X以外のiOS・Android版対応アプリが開発中となる「REALITY Avatar」の紹介が入り、講演は終了しました。

長期的な運用を見据えた上で、地道な作業も取り入れる

本講演内では「グローブが装着しづらいため、あとから自作でチャックを取りつけた」「仮想空間内にホワイトボードを設置するのは難しいため現実空間のホワイトボードを活用」といった、手作り感のあるエピソードが意外にも多く、ゼロから作ることの苦労や試行錯誤が多数語られました。

企業に属していない、いわゆる個人勢VTuberの筆者が聴講以前に漠然と持っていた「企業の資金力ならやりたい放題できるのでは?」という考えはいい意味で塗り替わりました。長期的なVTuber専用スタジオの運用を見据え、工夫と努力を惜しまない、WFLEの「本気度」が垣間見える講演だったと言えるでしょう。