きみはIKINEMA Orionを知っているか

にんげんども~、余だよ。バーチャルYoutuberのマグロナです。最近、3Dの身体になることができました。おじさんなのに。

さて、唐突ですがきみはIKINEMA Orionを知っているか。

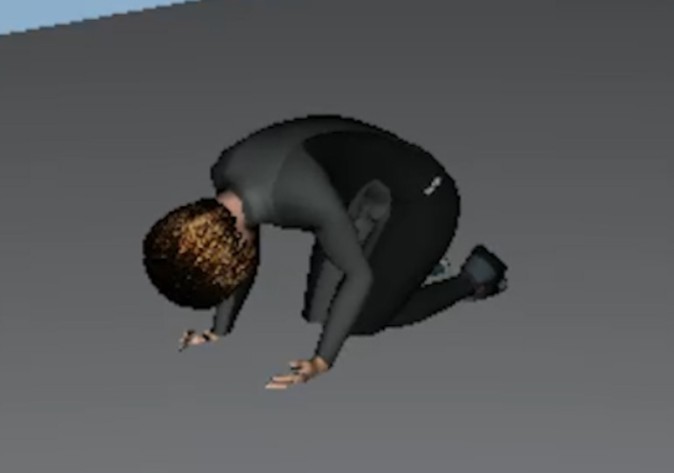

「IKINEMA Orion」はHTC VIVEとVIVEトラッカーを使ったモーションキャプチャシステム。6点トラッキングでこの精度です。すごい。一体どうなっているんだ……?

以前から興味はあったのですが、果たして個人で導入できる物なのか? 導入費用と必要な機材は? そういう部分がイマイチ分からないまま日々を過ごしていたある時、Moguraさんから一通のメールが届きました。

Moguraさん「色々教えてあげるので、Orionの導入レポートを書いてみませんか?」

マグロナ「Orion体験できるの!? 書く!!」

……という事で一も二もなくOKのお返事をしたのでした。今回はこの「IKINEMA Orion」を実際に試してみての導入レポートをお送りします。

実際にOrionを体験してみた:これすごい。

しばらくして、Moguraさんのオフィスで実際にOrionを体験させてもらう事ができました。

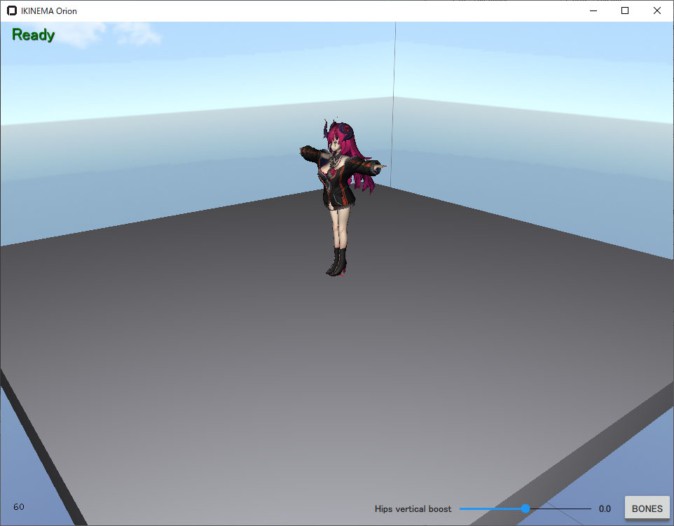

(Viewportに簡易モデルを読み込んだ状態でポーズを取っているもの)

これすごい。どうなってるんだ。

体験時のトラッキング部位は頭(VRヘッドセット)と両手のコントローラー、それから腰と両足の6つのみ。追加で両肘にトラッカーを追加する事もできますが、やってみて「6点でもいいんじゃないかな?」と思うくらいにはトラッキングの精度が良いです。特に膝。

最初は「膝に追加でトラッカーを付けられない」と言われて「えぇ……?」と思ったものの、実際に体験してみると違和感はなく、追加の必要性を全く感じないほど。誇張抜きで、まるで膝や肘にもトラッカーを装着しているようなフィーリングです。

(「さすがにこうやって膝だけ動かすと取れないでしょ……えぇ……? 取れてる……? ウッソ……?」となったシーン。)

(ちなみに土下座も可能。ただしMoguraさんによれば、足の甲についているトラッカーが隠れるので非推奨とのことでした)

そんな感じで色々とOrionを触ってみて、「凄い!」 と思った部分は沢山ありますが、単純にトラッキングの精度が物凄く高い点と、クオリティに対して装備の着脱、システムの起動が圧倒的に容易であることの二点が特に強いと感じました。

6点でも高精度のトラッキング、デバイス着脱も楽

6点トラッキングでもトラッカーが付いている箇所はもちろん、トラッカーが付いていないはずの膝、肘まですさまじい再現力で追従してくれます。座ろうが、回ろうが、そうそうトラッキングが飛んだり足がぐにゃっと曲がったりしません。ジャンプには弱いということでしたが、大きくジャンプをしたりしなければ軽く跳ねるくらいはできる印象です。というか、おじさんには大きいジャンプができない。

なので、Orionがあれば高精度なモーションキャプチャーをしたい場合でも、ヘッドトラッカー、コントローラー、ベルト、スリッパという簡単に着脱できる装備だけで済みます。

「装備の着脱が楽」というのを重要視する理由は、VRChat等で既にフルトラッキングを体験している人には分かってもらえるのではないでしょうか。真面目な話、着脱の容易さはやる気に直結します。いくら高品質なモーションが取得できても、着脱に時間のかかるシステムはその分疲れてしまうんですよね。週に一回か二回使えればいいや、となってしまいます。

VRChatでも「今日はデスクトップモードでいいや」となる経験、あると思います。6点トラッキングですら面倒になる時があるというのに、それ以上ともなると個人ではなかなか……。

Orionはそこを現状の装備以上に複雑化しないまま、高精度なモーションを取得する事ができます。なんというか、この強みはRPGで例えると「単純にレベルが高いから強い」みたいな感じですね。

トラッカーが少ない事にはもう一つメリットがあって、それは関節部等にトラッカーを必要としないためトラッカーのズレを気にしなくてもいい、というものです。実際、関節にVIVEトラッカーを付けているとズレやすいんですよね……。かといって、ガッチガチに固定していると動きが阻害されて固くなっちゃいますし。特に膝トラッカーは装着していると床に膝をつけ辛くなってしまうので、行動にかなりの制限がかかってしまいます。それがない状態で、しっかり各関節の動きまで再現できる。これは大きな強みだと感じました。

そんなこんなで、メチャクチャ「これ欲しい!」となった余なのですが、Orionと言えば3Dのスタジオやら企業さんやらから「導入しました!」という話を聞くようなシステム。個人VTuberかつ「Unityわからん……なんも……」とか言っている素人が、自宅にOrionを導入してVTuber活動に活かすことができるのだろうか……? と、若干の不安を抱えながら、追加トラッカーを手に帰宅したのでした。

Orionを導入した配信環境を考える

さて、余がOrionを使ってやりたい事は「VTuberとしての動画を撮影すること」です。それを実現するためには、Orionは一体何が出来るのか、どのような環境を構築してVTuber活動に活かせるかを知らなくてはいけません。

という訳で調べて分かった事と、固まった動画撮影用の環境はざっくり説明するとこんな感じです。

・Orionでキャプチャーしたモーションは、UnityとUnrealEngine 4に流し込むことができる。余のモデルにいろいろ設定を仕込んでいる環境がUnityなので、今回はUnityを採用。

・Unityのシーン内に設置されたカメラの映像を、仮想Webカメラデバイスの出力映像として取り出せるプラグインがある。したがってUnityのシーンをそのまま撮影環境として使用できる。UnityのAsset Storeでマップを購入するなどして用意し、その中にキャラクターを配置、そこにモーションやエフェクトを流し込めば、好きな場所・好きな雰囲気で動画を撮影する事が可能に。

さて、果たして上手くいくのでしょうか。

Orionインストール:14日間の体験版導入まで

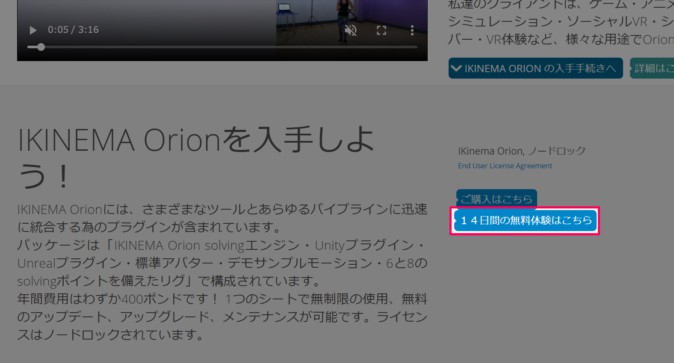

まずはOrionをインストールしなければ何も始まりません。ライセンスに関しては、14日間使える無料の体験版ライセンスがあるので、まずはそちらを使って自分の環境にOrionを導入できるかテストしましょう。Orionの公式サイトはここです。

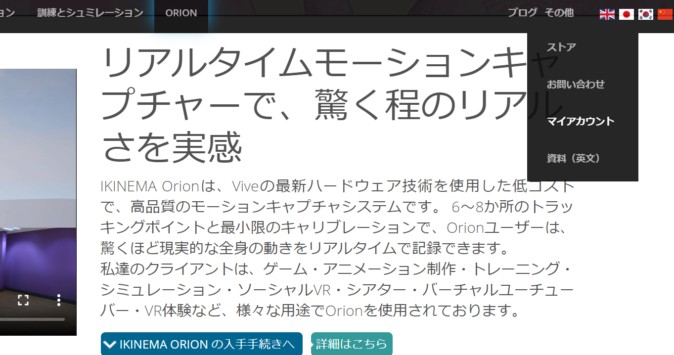

(右上の国旗アイコンをクリックするとサイトの表示言語を変更できます。)

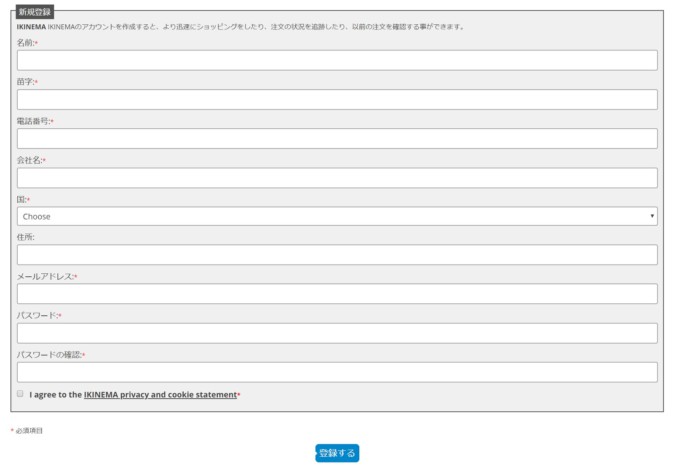

まずはアカウント登録をしましょう。 その他>マイアカウントへ。

手続きが終了したら登録したアドレスにメールが届くので、メールに記載されている認証URLにジャンプしてアカウント登録完了です。

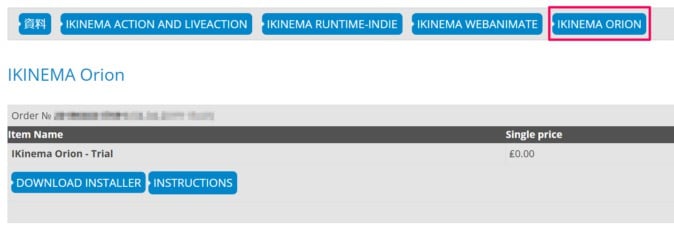

公式サイトのここから体験版のダウンロードができます。ログインした状態でこのボタンを押すと、マイアカウントのIKINEMA ORIONの項目にトライアルライセンスが登録されてファイルがダウンロードできるようになります。

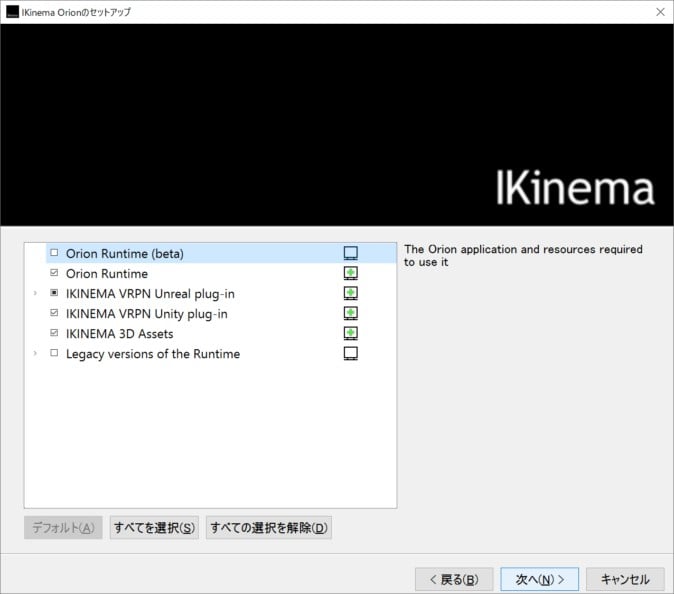

ダウンロードが終わったら、そのままインストールに移ります。ダウンロードしたファイルを実行し、インストーラーを起動しましょう。

インストールは特に解説することはありません! 全てデフォルトの設定のままで大丈夫です。念の為、インストールパスに2バイト文字(ひらがなやカタカナ、漢字、全角英数など)が含まれる場所は避けたほうがいいのかな、とは思います。

これでOrionのインストールは終了です。ここまでは簡単ですね。

Orion起動~Unity上でデフォルトのモデルを動かしてみる

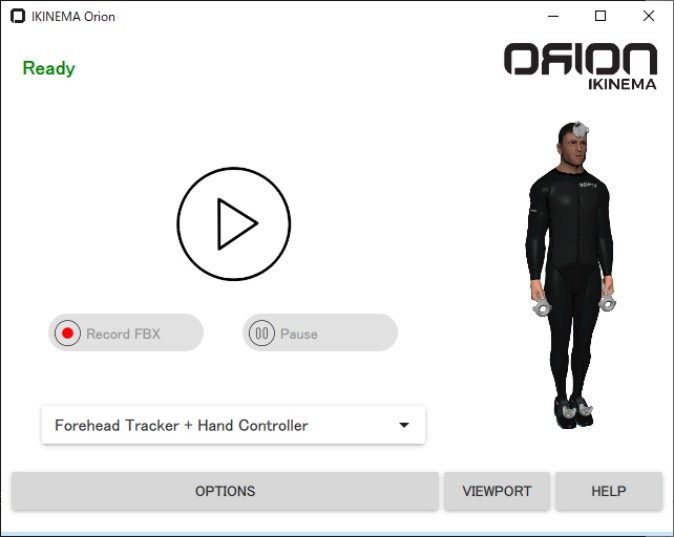

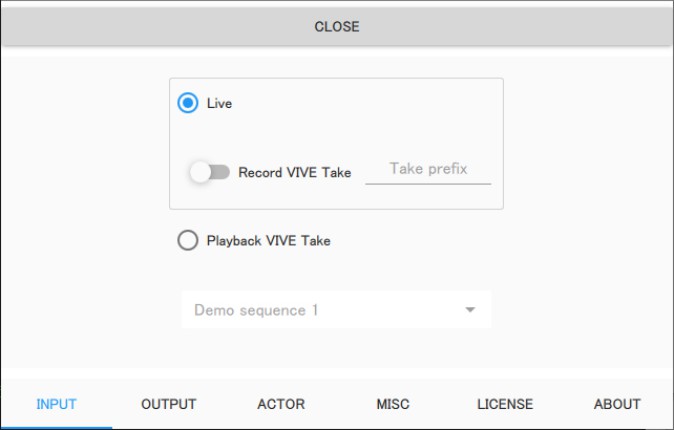

Orionを起動すると、このような画面になります。

下のプルダウンメニューから、自分の環境に合わせたトラッカーの構成を選択しましょう。そうしたらOptionを開き、各種オプション設定をします。

「Live」にチェックを入れればトラッカーを装着した自分の動きを読み込んでくれます。Playback VIVE Takeにチェックを入れてモーションを読み込めば、録画されたモーションデータを再生する事もできます。動作テストにも便利。

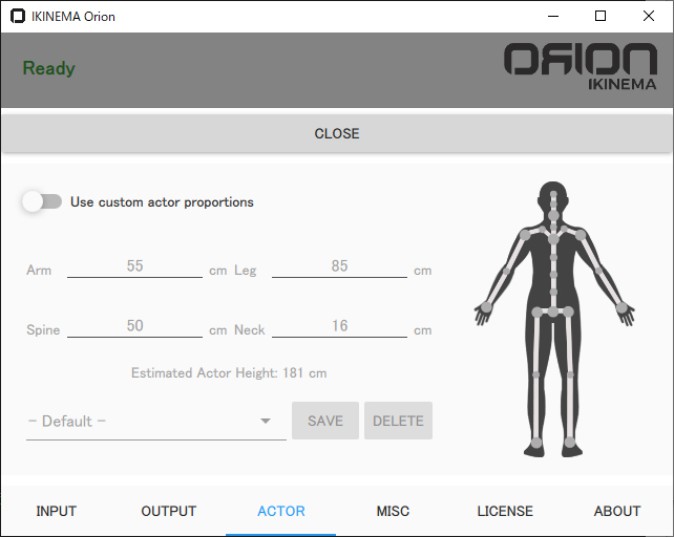

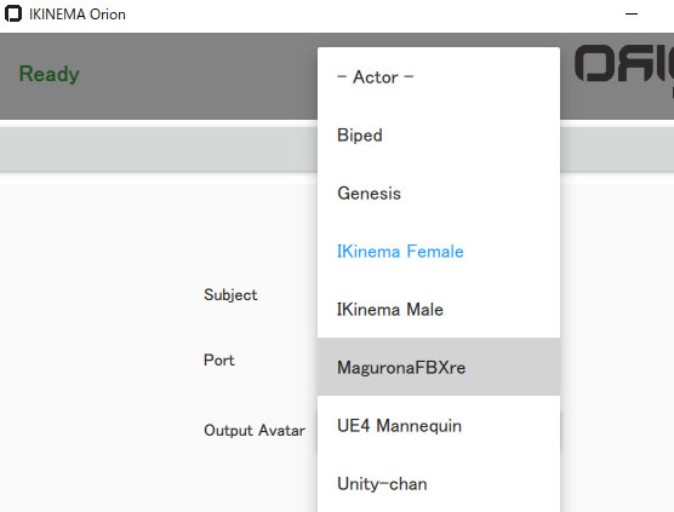

こちらはOutputの項目。SubjectとPortの二つはデフォルトのままで大丈夫です。Output Avatarには自分の使いたいモデルを設定するのですが、カスタムアバター(=自分の3Dモデル)を設定するには後述するリターゲットという作業が必要になります。なので、まずはデフォルトの中にあるIKinema Femaleを設定しましょう。

ACTORの部分は基本的に弄らなくて大丈夫だと思いますが、アクターの身体のサイズを計測して入力すると精度が上がるのではないかと思います。余は設定していませんが問題なく動いています。MISC、LICENSE、ABOUTに関しては触らなくても大丈夫。ちなみにマニュアルはこちら。

これで設定は終了です。かんたん!

Orionでモーションキャプチャーをしてみよう

さて、Orionの準備ができた所でトラッカーを装着します。事前にSteamVRを起動して、VIVEトラッカーのペアリングを行いましょう。トラッカーの装着方法については、既にWeb上に沢山の方法があるので割愛しますが、自分の好みに合ったものを選びます。

ちなみに今回はヘッドトラッカー、VIVEコントローラー(両手)、腰トラッカー(骨盤ベルト)、足トラッカー(スリッパ)という構成。VIVEコントローラー2個、VIVEトラッカー4個の6点トラッキングになります。

ここで一つ注意。Orionで正しいトラッキングを行うには以下のマニュアルにあるとおり、装着時のトラッカーが向く物理的な方向に指定があります。

基本的に装着面に対してLEDが左側になるように装着しますが、肘や手首トラッカーを使う場合は身体の正面を向いている必要があります。

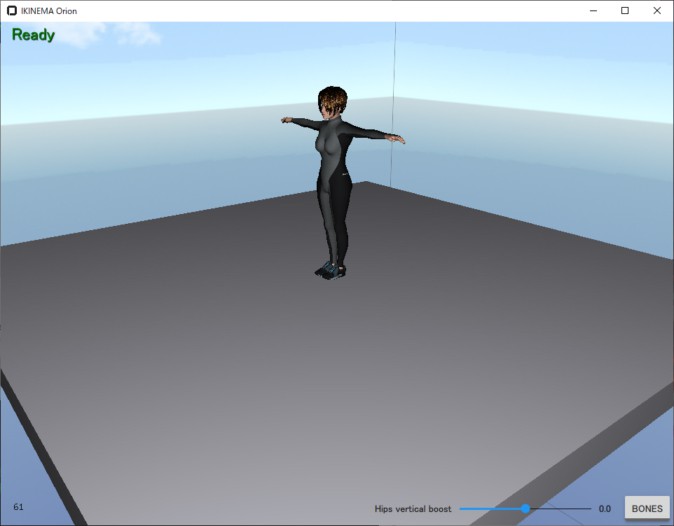

さて、トラッカーの装着が終わったらVIEWPORTのボタンを押してこの画面を開きます。

……というわけで、ここでキャラの手足の位置を確定します。VRChatで言う所の、白い玉の位置をTポーズのキャラに合わせるアレですね。

この画像と同じポーズを取って、コントローラーのトリガーを引きましょう。すると、キャラクターのモデルがロードされて自分と同じ動きをしはじめます。簡単!!

手にトラッカーを使っていてコントローラーを持っていない場合は、Optionの「MISC」内にある「Calibration delay」に秒数を入力しましょう。再生ボタンを押した直後からカウントダウンが始まり、0になった瞬間のポーズが取得されます。

……とはいえ、このままでは配信には使えません。VIEWPORT画面そのままでは、いくらなんでも画面が事務的すぎます。モーションデータのデータ録画等もできるのですが、こちとら末席とは言えVTuber。リアルタイムにキャラクターを動かしたいんですよね。

そこで、Unityとの連携機能を使って、OrionのモーションデータをUnity上でリアルタイムに読み込めるようにしましょう(UnrealEngine4との連携機能もありますが、筆者はUE4なんもわからんので今回はUnityで説明します)。

OrionのモーションデータをUnity上で再生してみよう

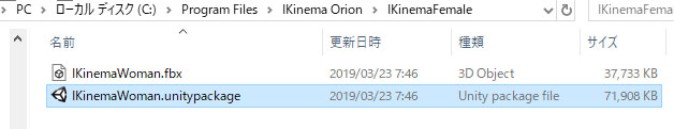

まずは、VIEWPORT上にも読み込まれているIKinema FemaleのモデルをUnityに読み込んで、モーションを適用してみましょう。Unityの新規プロジェクトを作成し、そこにIKinema Orionをインストールしたディレクトリにある「UnityStream/Assets」以下のファイルを投げ込みます。

そうしたら、プロジェクトにIKinema Orion/IKinema Femaleに入っているUnitypackageをインポートします。これでIKinema Femaleのモデルが読み込まれました。

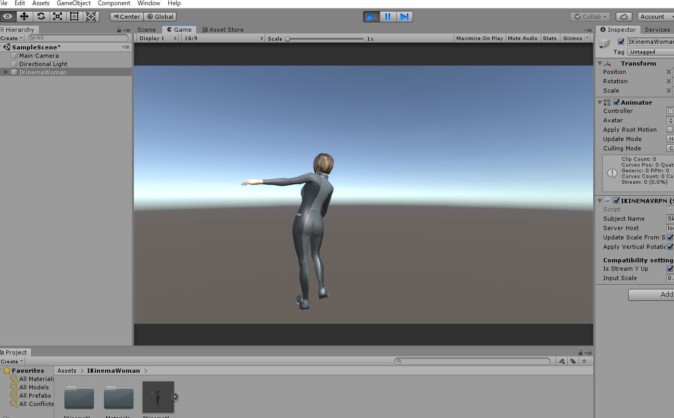

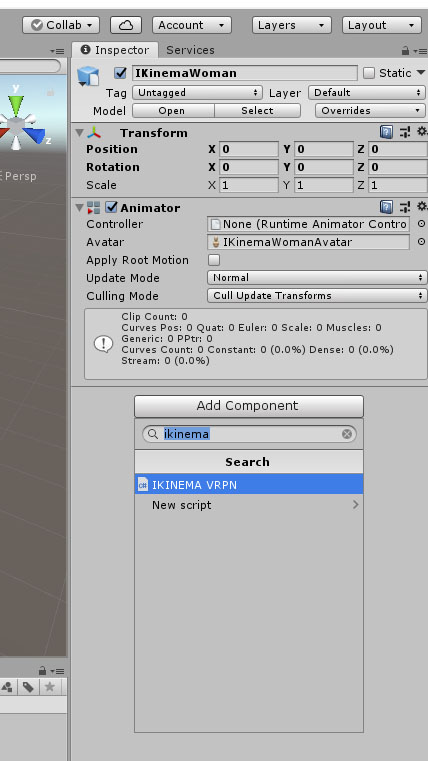

(Add componentのボタンを押してIKINEMAVRPNを設定しているところ)

このIKinema Femaleのモデルをシーン上に配置し、Hierarchy上のIKinema Femaleのモデルを選択。Add componentを押して出てきた検索欄に「IKINEMAVRPN」を入力して読み込みます。設定は特に変えなくても大丈夫です。これでセットアップはおしまい。

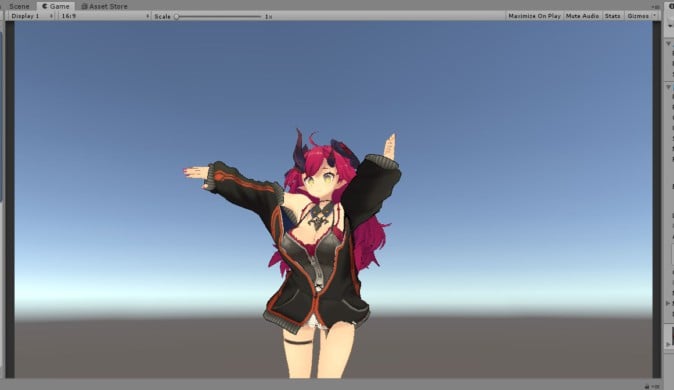

あとは、MainCameraをいい感じの位置に設置してからUnityのPlayボタンを押した状態でOrionの再生ボタンを押してみましょう。実際に自分で動いてもいいですし、Optionからサンプルのモーションデータを読み込んでそれを再生してもOKです。

と、いうわけで動きました。あまりにも簡単すぎる……。

カスタムアバター(自分の3Dモデル)の適用

そんな感じで、OrionのモーションデータをUnity上に流し込むのは非常に簡単です。OptionのOutput Avatarで使いたいモデルを選択し、そのモデルをUnity上に読み込んで、IKINEMAVRPNを設定するだけ。これなら余も今すぐOrionでモーションキャプチャーをした配信ができる! ……と、残念ながらそうはなりません。

先程説明したとおり、OptionのOutput>Output Avatarの部分を動かしたいモデルに設定しなくてはなりません。が、ここに自分の3Dモデルがない。この状態でいくらモーションを流し込んでも、自分の3Dモデルは動いてくれません。

ここで必要なのがリターゲットという作業になります。これはOrionの情報をキャラクターモデルに対応させる作業なのですが、残念ながら現状Unity向けには自分でこの作業を行うことはできません(ちなみにUnreal Engine 4向けにはLiveActionというツールがあり、こちらでリターゲットが可能)。

Unity向けには、IKINEMA社に3D(FBX)のデータを送り、有償でリターゲットを行ってもらう必要があります。記事執筆時点での費用は200ポンド(およそ3万円くらい)です。

・IKINEMAのCustom Avatar Requirements

カスタムアバターの必要条件は上記のページ(英文)に記載されていますが、基本的には名前の重複やメッシュ化されていないスキン、2バイト文字といった要素を含まないでね、といったものになります。特定のボーン構造やセットアップを要求している訳ではないので、既に3Dの身体を持っている人がOrionの為に1から作り直し/セットアップやり直し……という事はまず発生しないのではないかな、と思います。

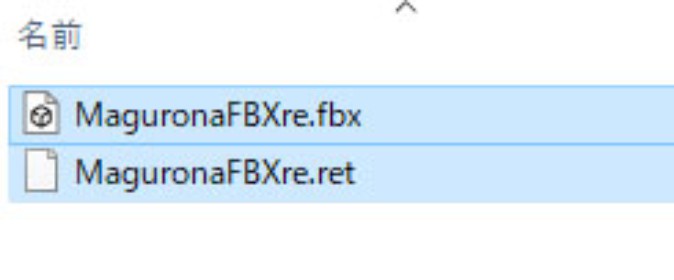

無事にデータが返ってくると、中にはリターゲットファイルと元のFBXファイルが入っています。これをIKinema Orion/Runtime/retarget/以下に入れましょう。

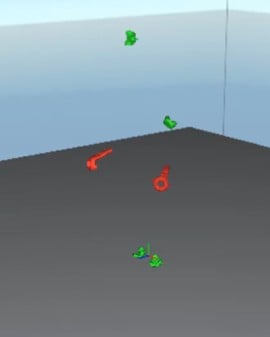

すると……

Output Avatarの欄に、自分のモデルが出ましたね! この状態でVIEWPORTを起動すると……?

ちょっと怖いけど余が出てきました! あとはIKinema Femaleの時と同じようにUnityにデータを読み込んで、IKINEMAVRPNを設定すれば……

動きました!!

IKINEMA社に送付するのはFBXファイルですが、ファイル/ボーン等の構造やサイズ等に変化がなければそれを元に作成したVRMファイル等も動きます(モデルデータとして見れば同一なので当たり前ですが)。

そのため、既にUnity上で揺れもの等を設定してVRM化しているモデルがある場合、元となったFBXファイルをIKINEMA社に送ってリターゲットファイルを作成してもらい、そのリターゲットデータでセットアップ済みのVRMモデルを動かす、という事が余の環境では可能だった事を一応報告しておきます(保証はしませんし自己責任にはなりますが……)。

そして配信へ

あとは、配信にこの画面を乗せるだけです。今回の記事の主旨ではないのでサックリ行きます。

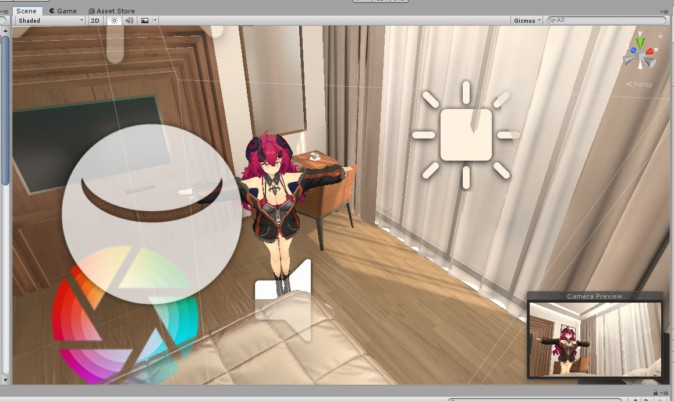

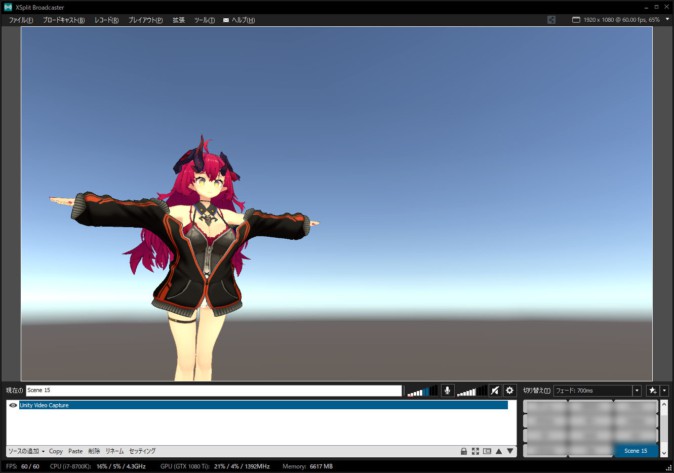

(/XsplitにUnityのカメラが出力されている。使用したプラグインはUnityCaptureです。>

プラグインでメインカメラ出力を仮想Webカメラ化して、配信ツールに読み込み……

アセットストアで買ってきた部屋の中にキャラクターとカメラを配置して、Orionからモーションを流し込んだら……

人間ども~、余だよ。

そんな訳で、Orionを使った配信環境が完成しました。この環境に加えてリップシンクや瞬き、視線追従やカメラエフェクト等を追加した上で、実際にYoutubeLiveを行った配信がこちらになります。

Orionを使った感想

モーションが高品質なのは当然ながら、撮影環境(Unity)への導入があまりにも簡単。素人でもチュートリアルビデオを片手間視聴するだけで簡単にセットアップできる上、チューニングの手間がほとんど無いのは強すぎます。導入時にリターゲットの手間はあるものの、これだけ綺麗なモーションを個人レベルで、なおかつ装着が容易にできる装備で行えるのはあまりにもお手軽と言わざるを得ないと思います。

普通の感覚で言えば決してお安いとは言えませんが、専門のスタジオがエグい予算をかけて機材を導入した上でモーションキャプチャーのデータを撮影していた一昔前を考えると、社会人がお金をためて奮発すればこのレベルの撮影環境が個人でも手に入る、というのはとても凄いことだと思います。

OrionはHi5 VR GLOVEやManus VRといったグローブ型コントローラーとも併用可能なので、自宅にいながらスタジオ撮影さながらのクオリティでモーションキャプチャーをする、というのも全く夢ではありません。すごい時代ですね……。

ワンランク上の環境を求めるVTuberや運営スタッフの皆さんに、Orionを是非一度試してほしいですね。以上、個人VTuberが撮影環境にOrionを導入してみたレポートでした!

IKINEMA Orionに興味をお持ちの方へ

(※以下、MoguLive編集部)

IKINEMA Orionは年間ライセンス62,400円(税別)で、リアルタイムでキャラクターを同期させることができます。14日間の無料体験版などもありますので、購入や詳細情報、資料請求などはこちらのページから。