祝連載10回目。複数回にわたりお送りしております、アメリカ・アナハイムで開催されたコンピュータグラフィックスとインタラクティブ技術の国際会議ACM SIGGRAPH 2016解説シリーズです。

すでにSIGGRAPH2016報告として、科学技術寄りの技術デモ「Emerging Technologies(E-Tech)」を前編/後編に分けて紹介しました。デモの体験展示と研究者との対話に特徴があるE-Techとは対比的に、今回はゲームグラフィックスなどのリアルタイムグラフィックスのショーイベント「Real Time Live!」を紹介したいと思います。

Real Time Live!

長い歴史を持つSIGGRAPHにおける映像作品フェスティバル「Computer Animation Festival(CAF)」。そこで、VR方面の参加者にとって特に注目のセッションが、ゲーム技術などのリアルタイムグラフィックスを扱うセッション「Real Time Live!」です。

最も大きいホールで今年最高のリアルタイムグラフィックスのデモを選出します。

http://s2016.siggraph.org/content/real-time-live

2015年に優秀賞を受賞したEpic Gamesのリアルタイムショートムービー「A Boy and His Kite(少年と凧)」

2010年より開始され、毎年規模と人気が高まっているこのセッションは、昨年、Epic Gamesの「A Boy and His Kite」に最優秀賞を授与しました。Unreal Engine 4によるリアルタイムグラフィックスであることを感じさせないクオリティのショートフィルムであり、さらにUnreal Engine 4が無料(free)であることをプロモーションした動画でした。

またここ数年、2014年「Birdly」、2015年「Real Virtuality」など、本セッションで発表する譽れを受けるVR作品は、規模の大小問わずその年のVR作品を特徴付けるようなプロジェクトになっている事にも注目です。

『ファイナルファンタジーXV』:AIとプロシージャル技術の先にある生きたリアルさをもつファンタジー世界

たくさんの興味深い発表が行われましたが、まずは多くの人々が期待しているであろう『ファイナルファンタジーXV』(スクウェア・エニックス,プレイステーション4およびXbox One向けソフト,2016年11月29日発売予定,以下FFXV)に関するデモ&プレゼンテーションを紹介します。

講演者はFFXVのVFX開発主任・長谷川勇氏とAI開発主任・三宅陽一郎氏。長谷川氏はすでに別のセッションで、FFXVにおけるノードベース管理のエンジンのコンセプトとその実装を講演「Visual effects of Final Fantasy XV: concept, environment and implementation」で発表しており、大きな注目を浴びていました。

Real Time Live!での講演は、長谷川氏と三宅氏によるデバッグモードを使ったライブ解説で、三宅氏の専門である人工知能(AI)についてさらに踏み込み、「リアルなファンタジー世界の環境をいかに生かすか?」といった近未来のVRコンテンツに非常に関連のある内容でした。

まず「ファイナルファンタジーはファンタジー世界のリアルさが特徴のゲーム」と定義し、「プレイヤーは主人公の身体を使い、主人公の身体感覚を感じながらファンタジーの世界を旅していく」と、まさに本作の開発が次世代のゲーム開発とVRコンテンツ開発の両方に影響があることを示唆するような定義から解説が始まりました。

体験する世界には実際の時刻が流れ、太陽や天候などの自然環境が存在します。

空の雲はプロシージャル技術でリアルタイム生成されています。従来方式のように「背景に描いたテクスチャ」ではありません。太陽も刻々と移動していきますので、二度と同じ空を見ることができないかもしれません。

その他の環境、水、風、大地、植生、モンスターや、魔法といった、従来は「グラフィックスの生成だけに処理」されるような現象も、すべて相互に物理的な関わりを持っています。プレイヤーは、生き生きとそこに存在している世界を体験しながら旅を続けていく設計です。

例えば、炎の魔法を使うと、大地の草や小屋は燃え、炎を怖がるモンスターは逃げていきます。

雨が降っている状態で炎の魔法を使うと、視界は水蒸気にまみれ、魔法の効果は薄れてしまいます。

このようなファンタジーの世界でありながら、我々が日常接している物理法則に則るリアルタイム世界の描写、「ファンタジー世界のリアリティの追求」は、シミュレーションゲームでは一部の作品で扱われた事はありますが、ファイナルファンタジーのような映像やストーリー重視のRPGで使われる事は稀です。

今後のVR世界のAI設計、世界構築やゲームエンジンそのものに大きな影響を与えそうですね。

ちなみに三宅氏はこの夏にゲームAIに関連する2つの書籍を刊行されています。

・人工知能のための哲学塾 (三宅陽一郎)

・絵でわかる人工知能 明日使いたくなるキーワード68 (三宅陽一郎,森川幸人)

森川幸人氏はPlayStation初期に人工知能をつかったゲーム『がんばれ森川君2号』を開発した伝説の開発者ですね。

Real Time Live!講演及びデモは公式動画の20分17秒ぐらいから視聴可能です。

なお、FFXVは正式にPSVR対応が発表されており、2016年6月のE3では主人公の仲間のひとり「プロンプト」視点でのプレイアブルバトルデモが公開されています。FFXVの戦闘方式は見た目のアクション性とは異なり「攻撃ボタンか防御ボタンを押しっぱなしにする」というシンプルな方式。さらに主人公は「ワープ」が使えるようですので、HMD装着でも酔いづらく、遊びやすい工夫が後付けでなく設計されているもの推測します。11月29日の発売が楽しみです。

参考:E3で公開されたPSVR対応動画

PIXAR – 映画製作とVR開発の急接近

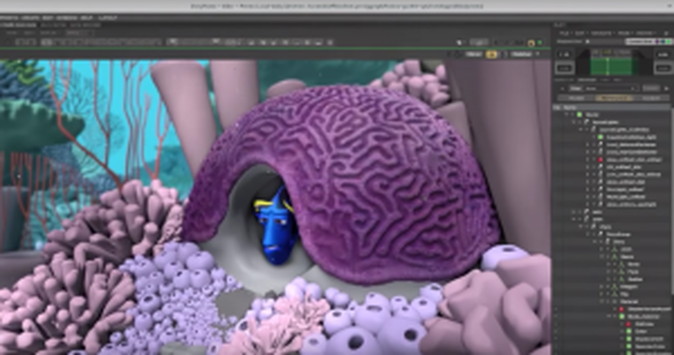

ディズニーアニメーションとともに、ハリウッドのCGアニメーションの最大のプレイヤーであるPIxar Animation Studios(以下、ピクサー)から「Real-Time Graphics in Pixar Film Production」というタイトルで発表が行われました。

実は公式プログラムには2004年に開発された『メリダとおそろしの森』、『アーロと少年』などで使われている「Presto」という内製システムについての話が書かれているのですが、SIGGRAPHの期間中にピクサーの新しいオープンソースプロジェクト USD (Universal Scene Description)について発表が行われ、Real Time Live!ではそれにあわせて劇場公開最新作「ファインディング・ドリー」のラストシーンを使ったライブデモが行われました。

USD はファインディング・ドリーの制作で本格採用され、それ以降の映画全てで全シーン・全部門のデータ交換に使われる、現在のピクサーの映画制作の根幹とも言えるデータ構造となっているそうで、起動の速さ(3秒!)、OpenSubdivによる高品質なモデリング、キャラクターアニメーションためのリギング作業、Pythonバインディングによる拡張性の高さ、フォーカスブラーやリグの操作なども行なえる、GPUを使ったリアルタイム表示 Hydra の品質の高さなどが紹介されました。

講演及びデモは公式動画の48分40秒ぐらいから視聴可能です。

<講演動画より。YouTubeで画質が劣化していますが、本当にリアルタイムで高品質なアニメーション制作作業が動いています>

<講演動画より。YouTubeで画質が劣化していますが、本当にリアルタイムで高品質なアニメーション制作作業が動いています>

このUSDは発表直後よりGithub上で本当にオープンソースで公開されており、現在はLinux版でのビルドが入手できます。もとバンダイナムコ、現在ピクサーで中心的な開発を手がける手島孝人氏が日本語で解説を書かれておりますので、情報もわかりやすく、今後も注目ではないでしょうか。

解説によると Hydra はOpenGL4.5 に対応した高速かつスケーラブルなリアルタイム用のレンダリングエンジンで、Hydra を使って独自のアプリケーションのシーングラフを描画することもできますし、それにUSD を組み合わせることもできるそうです。氏がこれまで取り組んできた非ポリゴンによるモデリングおよび高速レンダリング処理がHydraに組み込まれていることを考えると、CG映画クオリティのVR作品製作といったワークフローも夢ではないように聞こえます。また単に大規模データを高速に描画するためのレンダリングエンジンとして考えても大変有益で、今回のピクサーによるUSD発表は、大規模アニメーション映画製作とVR開発が急速に接近していることを象徴づける出来事ととらえても良いのではないでしょうか。

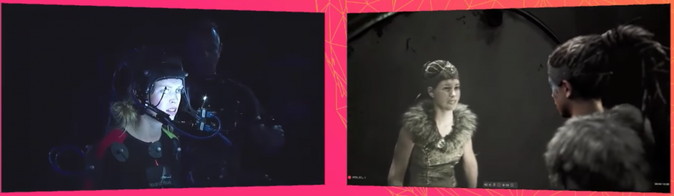

Epic Games:超ハイクオリティなプレビズ

昨年度の最優秀賞を獲得したEpic Gamesは「From Previs to Final in Five minutes: A Breakthrough in Live Performance Capture(プレビズから最終工程まで5分:ライブパフォーマンスキャプチャーのブレイクスルー)」というタイトルで、Ninja Theory, Cubic Motion, 3Lateral, House of Moves, IKINEMA, Technoprops, NVIDIAという大チームを率いた派手なデモを行いました。Ninja Theoryの新作アクションゲーム,「Hellblade: Senua’s Sacrifice」と、House of Moves によるVICONによるモーションキャプチャスタジオ、3LateralによるUnreal Engineによるリアルタイムキャラクタープレビューを統合し、実際の女優がフェイスキャプチャとモーションキャプチャ、さらにボイスを収録しながら「鏡の中から現実に現れた自分とそっくりな亡霊と対話」という複雑なシーンを目の前で演じて見せました。

公式動画の1時間4分46秒から視聴できます。

次に、そのキャラクターと対話するもう一人のキャラクターを収録します。同じ女優さんです。

次に、そのキャラクターと対話するもう一人のキャラクターを収録します。同じ女優さんです。

カメラワークだけでなく、細かい表情の演技、エフェクトやフォーカスなどもリアルタイムでプレビズしていきます。

カメラワークだけでなく、細かい表情の演技、エフェクトやフォーカスなどもリアルタイムでプレビズしていきます。

Ninja Theoryは「DmC Devil May Cry」シリーズを手掛けていることもあり、ハイクオリティキャラクターアニメーション、さらに表情や演技も含めたリアルタイム収録には定評があります。将来的にはプレビズのためのカメラをVRの自己視点に置き換えるようなゲーム作品も出てくるのでしょうか。期待です。

日本国内でもプレビズは活用されてきています。7月29日から8月28日までの公開1か月で累計動員360万人、累計興行収入53億円を突破、2016年公開の邦画実写映画1位を獲得した「シン・ゴジラ」でもプレビズが使われています。狂言師・野村萬斎がシン・ゴジラをモーションキャプチャで演じたことが公開後に明らかになったのですが、1台100万以上する業務用モーションキャプチャカメラ『VICON』を使ったプレビズ手法は、手付のアニメーションではできない演者のリアリティを具現化する最先端の技術です。この「シン・ゴジラ」のプレビズを担当したクレッセント社は、お台場VRZONEの「高所恐怖SHOW」の開発会社でもあり、こちらもVICONが使用されています。過去のSIGGRAPHには企業展示ExhibitionにてキヤノンのMRソリューション「MREAL」などの展示協力も行っています。

このように Real Time Live! は、まさに映画とゲーム、映像産業とVRが出会う場所、SIGGRAPHの場における頂上ショーとなりつつあります。

リアルタイム映像の「頂上舞台」とその緊張感

以上の通り、今年度の Real Time Live! はEpic Games、スクウェアエニックスをはじめ、Oculus Story Studio、Disney、Pixar、Google、ILM、NVIDIA…といったそうそうたる面々、さらにそれらに有名ゲームスタジオが最新のデモを協力する形で参加し、濃厚なセッションになりました。

公式に1時間33分のYouTube動画が公開されていますので、興味のある人はぜひ視聴をおすすめします。

本当はすべて紹介したいのですが、以下、紹介しきれなかった発表を公式動画のタイムコードとともに紹介します。

Quill: VR Drawing in the Production of Oculus Story Studio’s New Movie – Oculus Story Studio

<Oculus Story LabsのVR空間ドローイイングツール「QUILL」によるデモ。描かれた描線の再生が気持ちいい>

<「QUILL」のデモ、めったに見れないメッシュ生成の様子。(YouTube動画のスクリーンショットのため画像荒れがあるが)本当に3D空間上に破綻のないメッシュが生成されている>

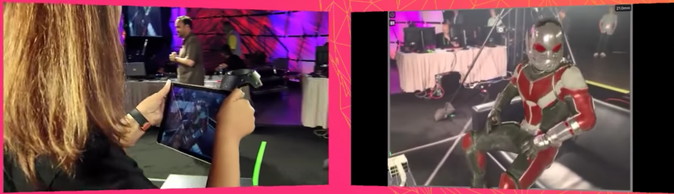

ILMxLAB Augmented Reality Experience – Industrial Light & Magic

<ILMの「xLAB」、タブレットにHTC Viveのコントローラをつけたコンシューマベースの技術で作ったプレビズのためのツール。映画『シビル・ウォー/キャプテン・アメリカ』のシーンや、派手なキャラクターを登場させた>

Real-Time Simulation of Solids with Large Viscoelastic Deformation – NVIDIA Corporation

<Real Time Live! 常連発表者であるNVIDIAのヌタポン博士による粘土デモ。本当に楽しそうに高解像度モデルをこねくり回したり手刀で切り刻んだりしている>

Gary the Gull – Limitless Ltd / Motional LLC

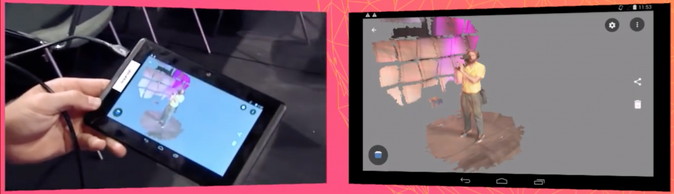

Immersive Augmented Reality in Minutes with Meta 2 – Meta Company

<Google Tangoによるリアルタイムメッシュ取得デモ。実際にTango対応タブレットを使い、ステージの様子を目の前で取得して処理しているので見ている方もかなりドキドキする>

<Google Tangoによるリアルタイムメッシュ取得デモ。実際にTango対応タブレットを使い、ステージの様子を目の前で取得して処理しているので見ている方もかなりドキドキする>

The Afterpulse: State-of-the-Art Rendering on Mobile GPUs – Digital Legends Entertainment

Character Shading of Uncharted 4 – Naughty Dog, Inc.

その他、現代舞踊のバレリーナが主人公のアーティスティックなPSVR対応ゲーム「Bound」や、プレイヤーの会話だけでインタラクティブなストーリーが進む「Gary the Gull」も発表がありましたが、既にMogura VRでも紹介されていますので割愛します。

以上のように観る側にとっては最新で大変楽しい「Real Time Live!」ですが、発表者にはリスキーな面もあります。講演中にどんなトラブルがあったとしても、演者の適応力で解決する必要があります。

実際にピクサーの講演開始や『アンチャーテッド4』の講演でも、ちょっとしたトラブルがありました。

一方で、最優秀賞を取得したEpic GamesはCEOによるメッセージ付きで受賞後メイキング映像も公開していますので、力の入りようを感じます(もしかしたらこれも何かのトラブルを想定した準備の一環なのかもしれませんが)。

▼ Introducing Realtime Cinematography | Hellblade | Siggraph 2016| Award Winner

▼ Unreal Engine 4によるプレスリリースとビデオ

https://www.unrealengine.com/blog/siggraph-real-time-live-demonstration-video-released-as-ninja-theory-launches-senua-studio

会場は数千人が入る大ホールですので、それだけでも大舞台です。リアルタイムでライブですから、失敗も撮り直しもできません。緊張もトラブルも大きい一方で、技術力を示す上では大きなプロモーションになります。しかも他のプレイヤーも3月のGDCや6月のE3で発表した最新のデモや、未発表・超最先端のデモをひっさげて実演します。

オリンピック級の「リアルタイム映像の頂上舞台」であることは間違いありません。

来年もこの場で、日本のVRプレイヤーからの挑戦を見ることができれば幸いですね!

【お知らせ】

2016年9月23日に大崎ブライトコアホールにて、ゲームの科学研究を行う「中山隼雄財団」の第22回成果発表会が開催されます。こちらで「挑戦:エンタテイメントシステムを社会にアタッチする 」というタイトルで、講演を行わせていただく予定です。一般参加可能です。他の研究成果発表も大変興味深い内容ですので、ご興味あります方は是非ご聴講いただければ幸いです。