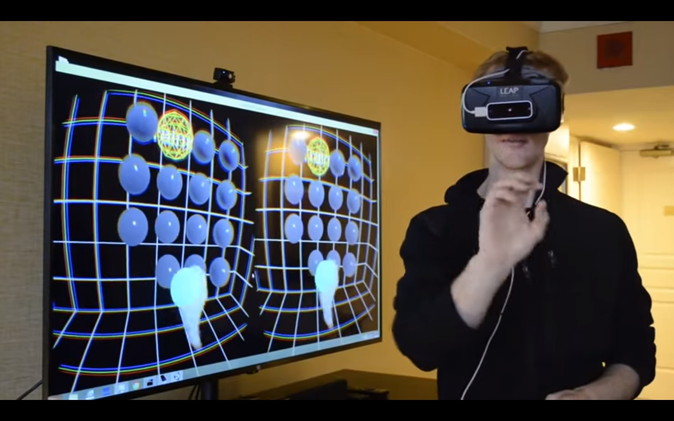

赤外線センサーを使ったコントローラー「Leap Motion」は、物理的なコントローラーを必要としない「直感的な操作」の実現のため、手のトラッキング技術を日々改良し続けています。現在、同社のはユーザーの入力とVR空間内の物体のやりとりをスムーズに行える「インタラクション・エンジン」と呼ばれるシステムの開発に注力しています。

同社のCaleb Kruse氏はオブジェクトを直感的かつ正確に操作するデモを公開しました。同エンジンがユーザーの入力と物理エンジンを仲介することで、開発者はクリエイティブな作業に集中することが可能となります。同エンジンは社内プロジェクトとして推進されていますが、近い将来、開発者向けに公開予定であるとのこと。

この、「インタラクション・エンジン」。どのような方法でユーザーの入力と物理エンジンを仲介するのでしょうか。普通の物理学で考える時、モノを強く握りすぎると弾き出されどこかへ飛んでいってしまうなど、予期せぬ状況も考えられます。

インタラクション・エンジンでは、Leap Motionのトラッキングデータからユーザーの動作意図(掴む、投げる、押す など)を予測することで、このような問題に対応しています。VR空間内に、ユーザーの手を再現するより簡単な方法です。

現在では、掴む、投げる、押すの動作意図が予測可能となっています。同エンジンの開発に向け、同社は手の操作の定量化を考え、数百人のユーザーを対象に「強調表示されたボールを掴み、ランダムに指定された位置に置く」といったテストを実施。結果、約96%の人が正確に操作できることが分かりました。

また、一指し指と親指を使った「つまむ」ジェスチャーによる、VR空間内にキューブを生成するデモも行われました。キューブを生成する際、手を前後に動かし、ピンチ、ズームを表現することで思い通りにキューブの大きさや輪郭を形作ることが可能です。

物理的なモノでないVR空間内のオブジェクトを掴むということは、まだ可笑しな話に聞こえるかもしれません。しかし、インタラクション・エンジンは、物体の操作をきちんと予測し、かつ相互作用するように、さらに改善を続けていくとのことです。

(参考)

Leap Motion’s ‘Interaction Engine’ Aims for Effortless VR Input(英語)

http://www.roadtovr.com/leap-motion-interaction-engine-virtual-reality-input-ces-2016/

米Road to VRとMogura VRはパートナーシップメディアです。