アップルは6月5日(現地時間)からアメリカ・カリフォルニア州サンノゼで開催している開発者向けイベント「WWDC2017」で、ARプラットフォーム「ARkit」を発表しました。

最大の特徴はiOS11としての新機能として提供されることで、すでに普及しているiPhoneやiPadで利用できるということです。発表会でもクレイグ・フェデリギ氏が「数億のiPhoneやiPadで動く。つまり、世界最大のARプラットフォームだ」と胸を張りました。

スマホ向けのARプラットフォームとしては、グーグルの「Tango」がありますが、対応機種が限られるなど、普及にはまだ時間がかかりそうです。しかし、ARkitならすでに普及しているiPhoneやiPadをiOS11にアップデートすれば、ユーザーはAR体験を楽しめるようになります。

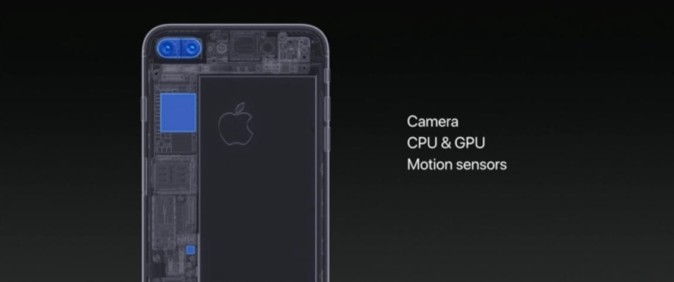

ARkitは、端末内のカメラ、CPU/GPU、モーションセンサーだけを使っています。iPhone 7 Plusには2つのカメラが内蔵されており、ARkitも2つのカメラを使うかと思いきや、ひとつのカメラだけでARを実現しているようです。

グーグルのTangoでは赤外線センサーなどで深度が測れますが、ARkitではそうしたセンサーがないために深度が測れません。アップルとしては、新たなデバイスを追加して深度を測り、数センチ単位の精度を求めるよりも、いま普及しているiPhoneやiPadで稼働するARプラットフォームを優先したようです

ARアプリの飛躍的な増加が期待

実際に会場ではタッチアンドトライ会場があり、ARを試すことができました。

iPad Proにあるデモアプリを起動すると、まずカメラが立ち上がります。画面上に四角い枠が表示されるので、iPad Proを上下左右に動かし、机の上をスキャンします。

しばらくするとデモが試せるようになり、机の上にコーヒーカップを置くことができます。コーヒーカップを机の奥や手前に移動させることができ、距離に応じて大きさも変わっていきます。さらに花瓶や照明を置くことができました。

照明によって、机に影ができるのですが、照明をつけると、机の上に影できます。

iPad Proを横にしたり、斜めにすることで、コーヒーカップや花瓶、照明の見え方も変わってきます。

ちょっとしたデモでしたが、iPad Proがしっかりと机を認識し、ARとして機能することが充分に確認できました。始めにテーブルを認識したあと、さらに追加で床を認識することもできます。例えば、テーブルの上に花瓶を置いたあとに、床にいすを配置するのも可能です

ARkitでは、「高速で安定したモーショントラッキング」「基本的な境界での平面推定」「スケール推定」を可能としています。

iOS11が正式リリースされる今秋以降、iPhone、iPad向けのARアプリが飛躍的に増えてきそうです。